Fazer com que seu aplicativo de página única (SPA) seja descoberto por mecanismos de busca não é uma tarefa fácil. SEO para aplicativos de página única ajuda suas aplicações web a obter mais visualizações orgânicas.

Sites "HTML-based" são mais fáceis de acessar, rastrear e indexar porque fornecem uma marcação estruturada para rastreadores.

Portanto, ter seu conteúdo em páginas HTML pode levar a melhores classificações de busca, e elas são mais fáceis de otimizar do que aplicativos de página única.

SPAs dependem muito do JavaScript para reescrever dinamicamente o conteúdo com base nas ações de um visitante no site (pense em "texto expansível" ou "caixas pop-up").

Portanto, isso dificulta para os Googlebots indexarem o conteúdo da página, pois eles não executam o conteúdo JavaScript do lado do cliente.

Neste artigo, vou discutir os verdadeiros desafios de usar "SPAs" e compartilhar o processo completo de fazer "SEO" para aplicativos de página única para obter melhores classificações nos mecanismos de busca.

Principais Conclusões

- SEO para "single page applications" é essencial porque SPAs impulsionadas por JavaScript muitas vezes escondem conteúdo chave dos rastreadores.

- Use renderização do lado do servidor (SSR) ou pré-renderização para fornecer aos rastreadores versões HTML totalmente renderizadas de suas páginas.

- Títulos dinâmicos, meta descrições e tags canônicas são cruciais para SEO de "single page application" para prevenir conteúdo duplicado e manter a relevância em todas as rotas.

- Combine links internos, URLs limpas, sitemaps XML e códigos de status HTTP corretos para ajudar os motores de busca a descobrir e indexar todas as rotas chave dentro do seu SPA.

O que é SEO para "Single Page Applications" (SPA)?

A "otimização para motores de busca" para aplicativos de página única refere-se ao processo de tornar SPAs, construídos com frameworks JavaScript como React.js, Angular.js ou Vue.js, acessíveis e indexáveis pelos mecanismos de busca.

SEO para "aplicativos de página única" inclui:

- "Renderização" do lado do servidor ou "pré-renderização"

- "Tags de título", "meta descrições" e otimização de dados estruturados

- Otimização de URL e tag canônica

- Otimização de links internos

- Criação e envio de "Sitemap"

- Construção de links

Google, Bing, Baidu, DuckDuckGo, e outros "motores de busca" encontram dificuldades para rastrear e indexar conteúdo em JavaScript, já que SPAs carregam [conteúdo] dinamicamente no lado do cliente.

Portanto, SEO de SPA consiste em estratégias e melhores práticas para melhorar a "descoberta" e a presença na web de [aplicativos de página única] nos motores de busca.

Exemplos de "Single Page Applications"

Aqui estão os principais exemplos de SPAs:

Gmail

Gmail é um exemplo clássico de uma "SPA". Quando você faz login, toda a interface do usuário, incluindo sua caixa de entrada, pastas e chat, é carregada uma vez.

A partir desse ponto, "navegar" pelos emails, abrir "tópicos" ou compor novas "mensagens" não requer um recarregamento completo da página.

JavaScript gerencia o roteamento e as mudanças de conteúdo nos bastidores, tornando a experiência rápida e contínua.

Google utiliza requisições assíncronas para buscar apenas os dados necessários, reduzindo a latência e melhorando a experiência do usuário.

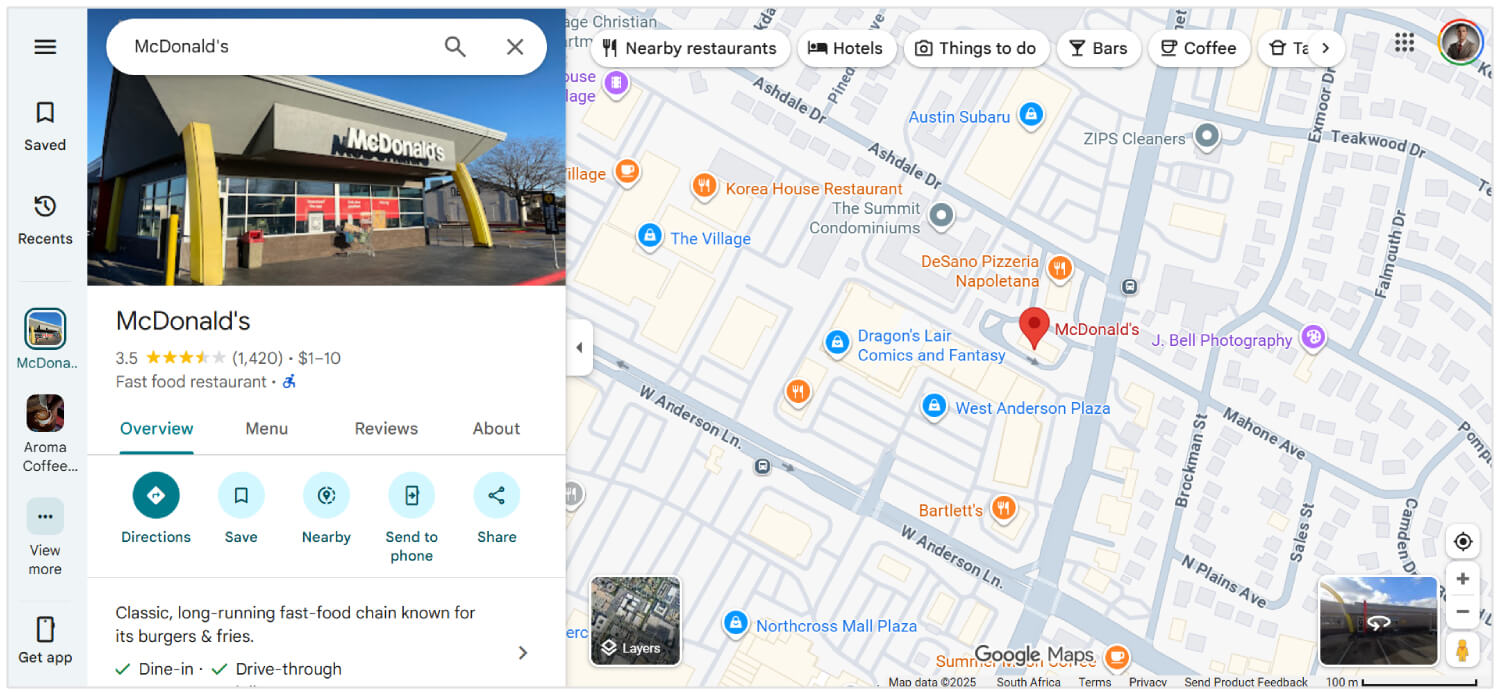

Google Maps

O Google Maps oferece recursos interativos ricos, como "deslocamento", "zoom" e "pesquisa de locais", tudo na mesma página.

Ele não recarrega quando você solicita novas "direções" ou alterna entre "visões" de satélite e mapa.

Em vez disso, os dados são buscados via AJAX, e os blocos do mapa ou componentes da interface do usuário atualizam-se dinamicamente. Isso faz com que o Google Maps pareça extremamente "responsivo" e utilizável, mesmo em conexões mais lentas.

Embora não seja 100% SPA, grandes partes do Facebook usam a arquitetura SPA.

Quando os usuários rolam pelo seu "feed" de notícias, abrem postagens, reagem ou comentam, todas as atualizações acontecem sem recarregar a página.

Mesmo ao alternar entre páginas como "Mensagens", "Notificações" e "Marketplace", o site usa roteamento do lado do cliente com frameworks JavaScript (como React) para renderizar dinamicamente o conteúdo, o que reduz chamadas ao servidor e melhora a velocidade de carregamento.

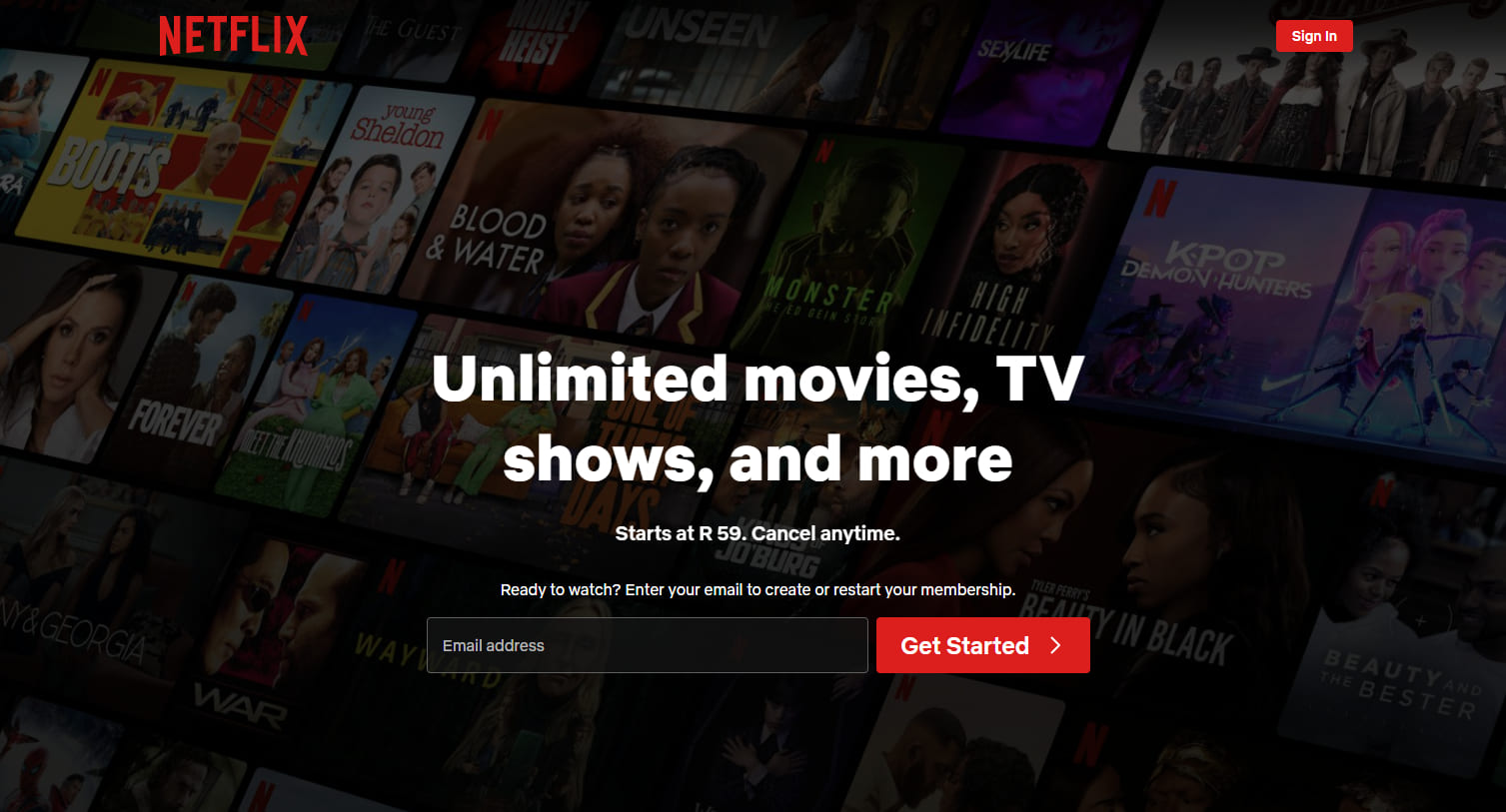

Netflix

A interface web da Netflix é outra SPA de alto perfil. Conforme você navega por sugestões de filmes ou programas de TV, "trailers" são reproduzidos automaticamente, e detalhes do conteúdo aparecem imediatamente sem recarregar.

Clicar em um título abre uma sobreposição modal ou nova visualização enquanto mantém a interface principal intacta.

O "roteamento", as "recomendações" e as mudanças no "perfil do usuário" são gerenciados por JavaScript, proporcionando uma experiência consistente com tempos de espera reduzidos.

Uma "Single Page Application" é boa para SEO?

Sim, uma aplicação de página única é boa para SEO se você souber as dicas certas de otimização para SPAs.

Mecanismos de busca como o Google podem renderizar JavaScript, mas eles podem atrasar a "rastreamento" ou pular "conteúdo" que exige interação do usuário.

Para evitar isso, você pode usar "renderização do lado do servidor", "geração de site estático", "roteamento de URL limpo" e "atualizações dinâmicas de metadados".

Ferramentas como Next.js, Nuxt.js, React Helmet e Vue Meta ajudam a fazer tudo isso funcionar.

Com a configuração certa, uma SPA pode "rankear" tão bem quanto qualquer site tradicional. No entanto, sem os ajustes adequados de SEO, os mecanismos de busca podem perder muito do que você construiu.

Leitura Relacionada: Como Realizar SEO para Conteúdo Dinâmico

Como fazer SEO para "Single Page Applications"

Aqui estão as melhores soluções de SEO para aplicativos web de página única:

Use "Renderização do Lado do Servidor" (SSR)

"Aplicações" de "página única" dependem de JavaScript para carregar "conteúdo" dinamicamente.

No entanto, os mecanismos de busca esperam HTML completo do servidor na resposta HTTP para acessar, rastrear e indexar o conteúdo.

Portanto, você deve implementar "renderização" no servidor para "renderizar" páginas no servidor antes de enviá-las para o navegador.

Na renderização do lado do servidor, o navegador solicita arquivos HTML, e o servidor busca todos os dados. Isso garante que todo o conteúdo seja imediatamente visível e rastreável.

Cachear páginas "frequentemente" acessadas para reduzir o tempo de carregamento e servir conteúdo mais rápido. Evitar a renderização no lado do cliente para elementos chave, pois os motores de busca podem falhar ao processar visualizações com muito JavaScript.

Implementar "Pre-Rendering" para "Static Routes"

Você deve pré-renderizar rotas que mostram o mesmo conteúdo para cada visitante. Isso permite que você gere HTML no momento da construção e elimina a necessidade de renderização em tempo de execução.

Como resultado, os "motores de busca" podem acessar a página instantaneamente.

Ferramentas de geração estática de frameworks como Next.js ou Nuxt.js podem ajudar você a criar arquivos estáticos para rotas como "páginas de destino", "blogs" ou "visões gerais de produtos".

Você deve servir essas páginas pré-renderizadas através de uma Content Delivery Network ou servidor web para melhorar a velocidade de carregamento e visibilidade. Evite aplicar pré-renderização a visualizações com dados em tempo real ou específicos do usuário.

Adicionar Saída de "HyperText Markup Language" Limpa e Rastreadora

Você deve gerar uma Linguagem de Marcação de Hipertexto [bem] estruturada que os motores de busca possam interpretar facilmente.

Uma "marcação limpa" ajuda os "bots" a entenderem o layout da página, a hierarquia e os elementos principais sem depender da execução de JavaScript.

Evite injetar conteúdo dinamicamente após o carregamento da página. Em vez disso, garanta que o texto importante, títulos, e links apareçam diretamente no código-fonte.

Quando você está trabalhando em SEO para um aplicativo de página única, a maior coisa a lembrar é que o Google nem sempre vê sua página da mesma forma que as pessoas veem. Porque eles carregam conteúdo com JavaScript, às vezes o rastreador apenas obtém uma página em branco. Então, certifique-se de que o que você quer que o Google leia realmente apareça no html.

- Ciara Edmondson, "Gerente de SEO e Conteúdo" na Max Web Solutions

Use "tags semânticos" como <header>, <main>, <article>, e <footer> para fornecer estrutura clara.

Você também deve minimizar estilos "inline" e a desordem de "scripts" que podem obscurecer o conteúdo significativo.

Mantenha o documento legível e leve para um rastreamento mais rápido e melhor indexação.

Use "renderização" do lado do servidor ou pré-renderização para produzir HTML estático para cada rota. Isso garante que os "crawlers" acessem o conteúdo completo da página na solicitação inicial.

Expor "Instantâneos" Estáticos para Rastreadores

Você deve expor "snapshots" estáticos para garantir que os "crawlers" possam acessar o conteúdo completo, especialmente quando a renderização do lado do cliente atrasa a saída da página.

Um "instantâneo estático" é uma versão totalmente renderizada da página gerada antecipadamente e servida especificamente para bots.

Esta "tática" é útil quando a renderização no lado do servidor ou pré-renderização não é viável em todo o aplicativo.

"Snapshots" fornecem um caminho alternativo para "crawlers" acessarem a "HyperText Markup Language" estruturada sem executar "JavaScript".

Você deve configurar o servidor para detectar agentes de usuário como o Googlebot e servir "snapshots" pré-construídos para essas solicitações.

Ferramentas como Rendertron, Prerender.io, ou renderizadores NodeJS headless personalizados podem ajudar a gerar e entregar "snapshots" de forma confiável.

Certifique-se de que cada captura de tela reflita o conteúdo completo e a estrutura da página, incluindo títulos, metadados, links e marcação de esquema.

Safira da Somar Digital, uma agência com sede na Nova Zelândia, recomenda que todas as "SPAs" devem usar "schema markup" para seu "SEO".

Eu recomendo o uso de marcação de esquema de dados estruturados para SPAs. Integre marcações de esquema relevantes como "organização", "página da web", "lista de navegação", "FAQ", etc.

Eu percebi que às vezes a marcação de esquema pode não aparecer no código-fonte ou mesmo no Teste de Resultados Ricos do Google, mas se você testar o esquema usando o validador de marcação de esquema, você verá as marcações de esquema adicionadas nos resultados. Isso acontece porque "SPAs" que injetam o Esquema (via JavaScript) não têm isso disponível na carga inicial. Mas o Google é capaz de ler o JavaScript pois é "headless".

- Safira Mumtaz, Especialista em "SEO/SEM" na Somar Digital

Você também deve monitorar a cobertura de índice para confirmar que os rastreadores estão processando "snapshots" conforme o esperado.

Servir "snapshots estáticos" melhora a visibilidade para páginas com lógica de renderização complexa, ajudando a manter um valor consistente de indexação e SEO.

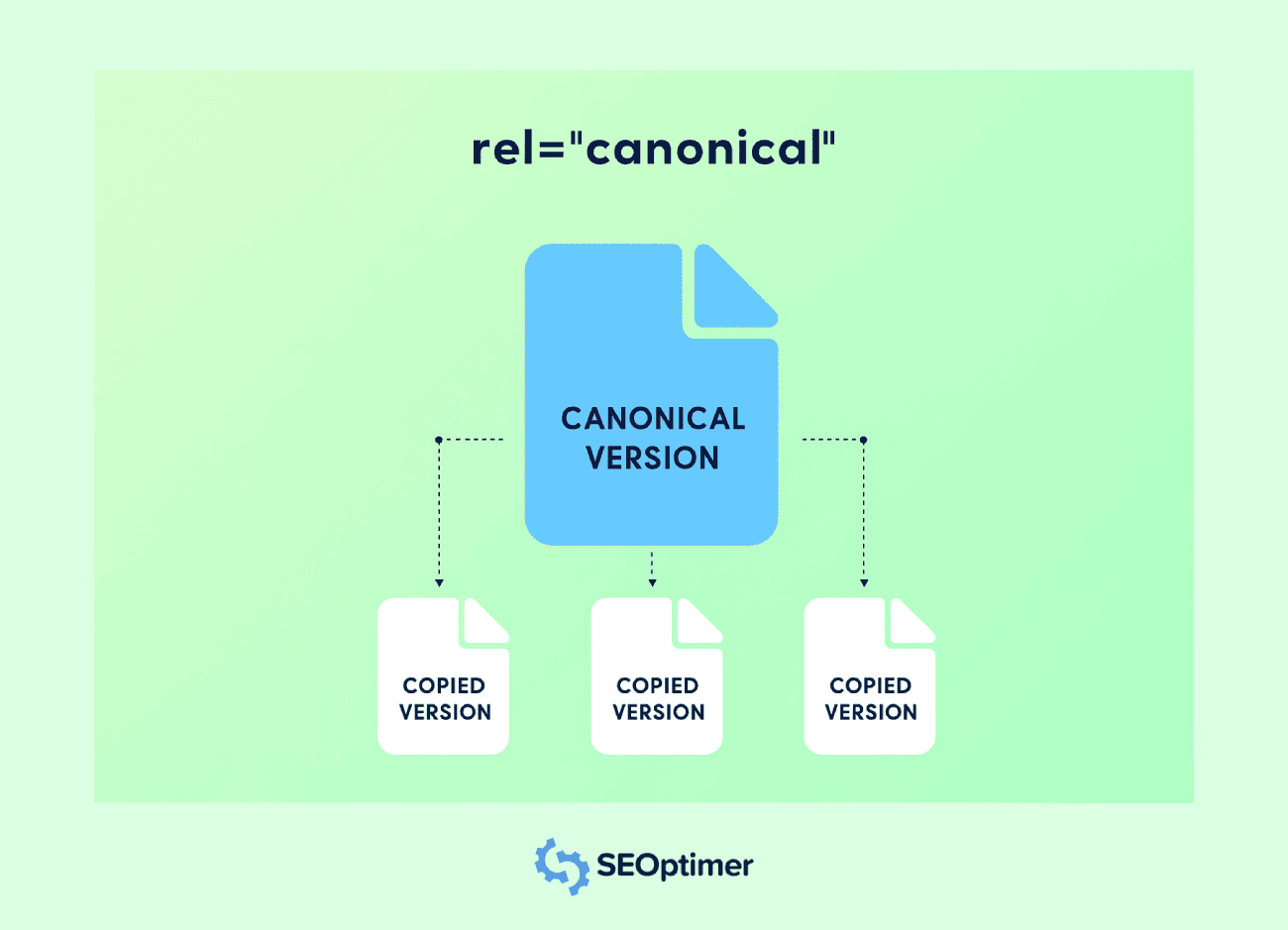

Configurar Tags Canônicas para Cada Visualização

Você deve definir uma tag canônica para cada rota em uma aplicação de página única para evitar problemas de conteúdo duplicado.

Na maioria das vezes, SPAs gerarão várias URLs acessíveis para o mesmo conteúdo.

Por exemplo, o mesmo conteúdo pode estar presente em URLs com diferentes "query strings", filtros ou parâmetros de rastreamento. As tags canônicas ajudam os mecanismos de busca a entender a versão preferida.

Cada rota deve incluir uma <link rel="canonical"> tag apontando para a URL original dessa visualização. Isso previne a diluição de "equidade de links" entre diferentes URLs que possuem o mesmo conteúdo.

Você deve injetar [tags] canônicas dinamicamente quando a rota mudar, especialmente se o aplicativo atualizar [metadados] no lado do cliente.

Use "ganchos" de roteamento ou funções de "middleware" para atribuir a "tag" correta em cada transição de página.

Evite apontar todas as rotas para a página inicial ou usar um valor canônico estático. Cada "visualização" única deve refletir seu próprio URL lógico para preservar a "relevância" e a precisão do "índice".

A implementação da "canonicalização" adequada suporta uma indexação mais clara, melhora a "autoridade" da página e previne a duplicação indesejada nos resultados de "pesquisa".

Tratar "404" e Outros [Códigos] de Status Corretamente

Você deve configurar "códigos de status" precisos para todas as visualizações em um aplicativo de página única para ajudar os mecanismos de busca a interpretar corretamente a estrutura do seu site.

Muitas SPAs servem um shell HTML padrão para cada solicitação, o que pode retornar um 200 OK mesmo para rotas "inexistentes".

Uma resposta adequada "404 Não Encontrado" deve ser retornada para URLs inválidos.

Use a lógica do servidor ou middleware no NodeJS para detectar "rotas" não correspondentes e enviar o código de status correto junto com uma página de [erro] personalizada.

Você também deve lidar com outras respostas como 301 ou 302 para "redirecionamento" e 500 para "erros de servidor".

Esses códigos de status informam os mecanismos de busca sobre como tratar cada solicitação e manter a integridade da sua cobertura de rastreamento e indexação.

Evite depender exclusivamente do tratamento de erros no lado do cliente. Crawlers podem não executar JavaScript, portanto, respostas de status incorretas podem prejudicar os sinais de otimização para mecanismos de busca e enganar a indexação.

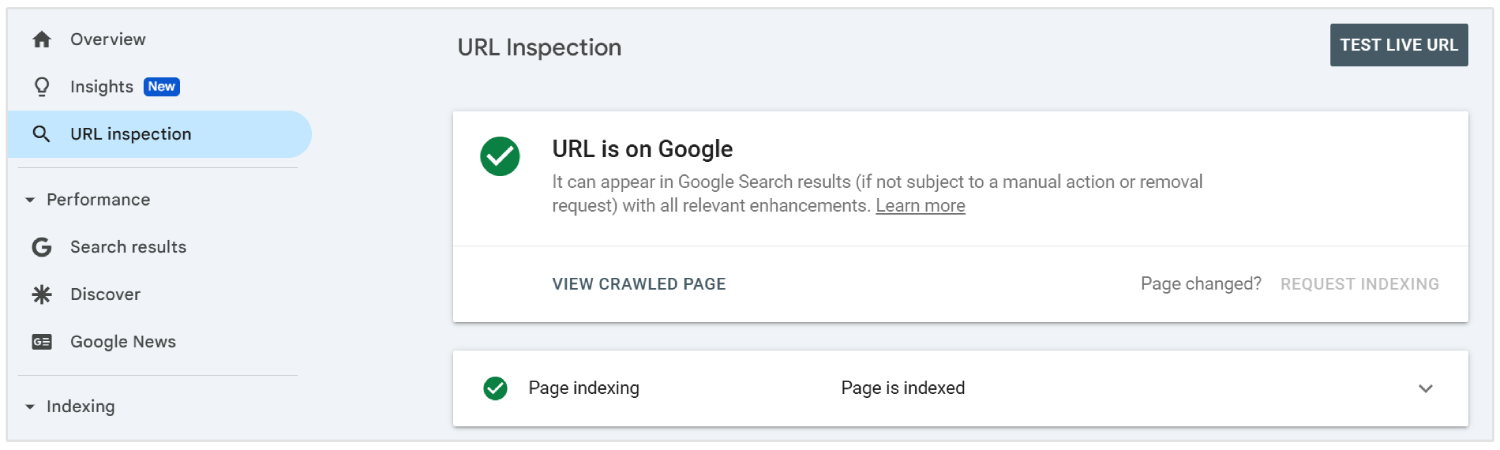

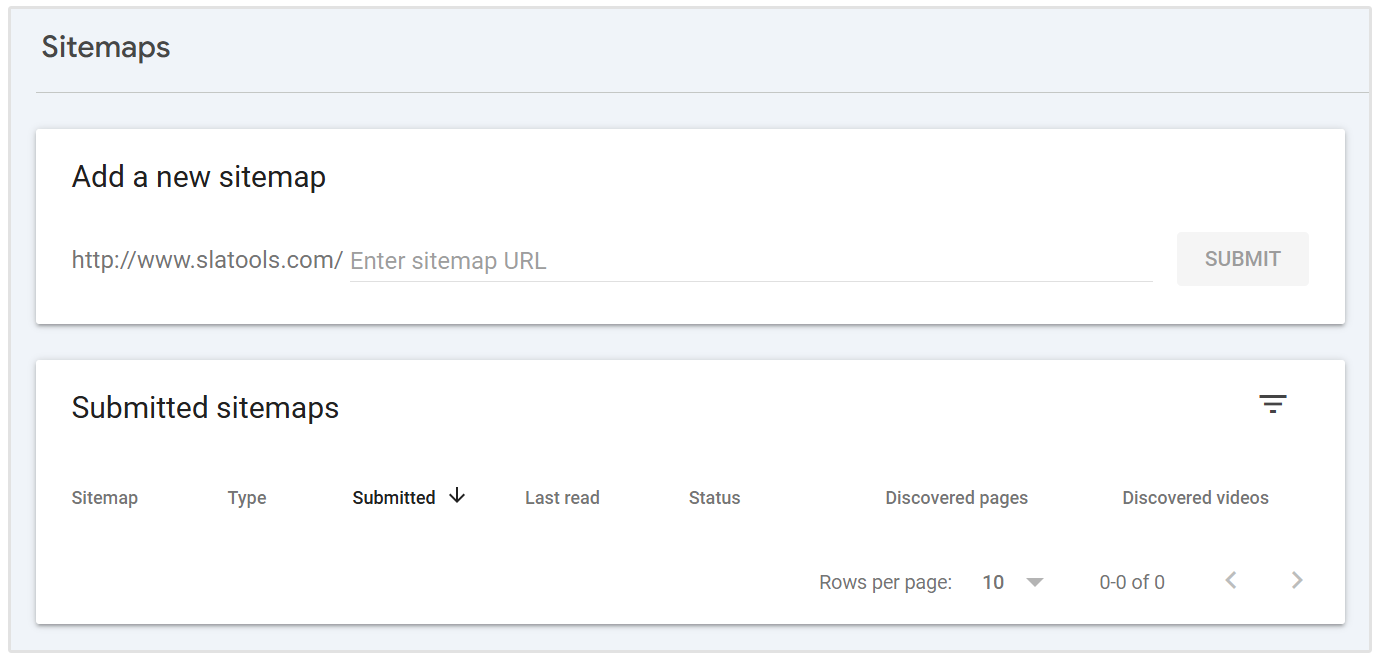

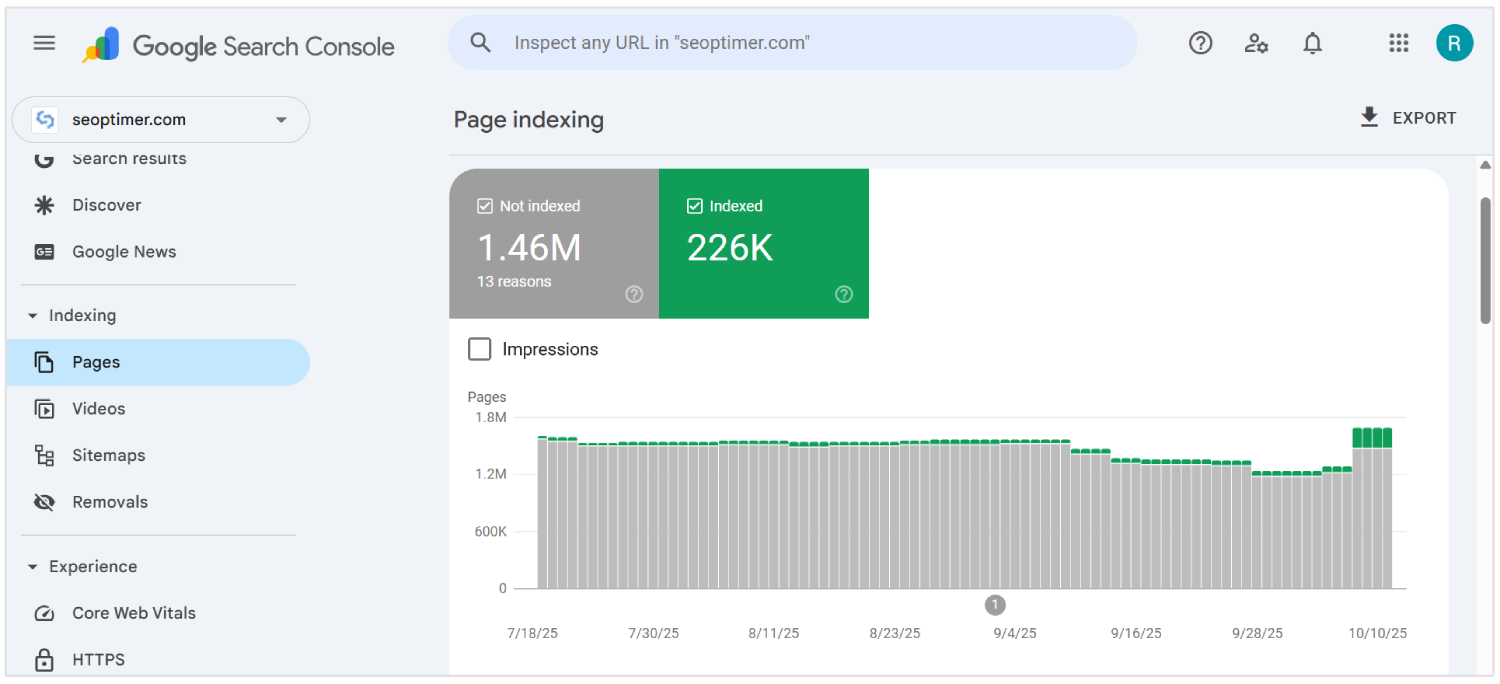

Enviar URLs Dinâmicas para o Google Search Console

Você deve enviar todos os URLs dinâmicos importantes de uma aplicação de página única para o Google Search Console usando a ferramenta de Inspeção de URL. Isso ajuda os bots dos mecanismos de busca a descobrir e indexar conteúdo que pode não aparecer em uma varredura tradicional.

Como as SPAs carregam "conteúdo" através de roteamento no lado do cliente, algumas páginas internas podem não ser encontradas por "rastreadores" sem [linkagem] direta.

Para garantir a visibilidade, liste esses URLs em um sitemap XML e envie-o através da interface do console.

Você deve atualizar o sitemap sempre que novas rotas forem adicionadas ou alteradas. Cada entrada deve refletir a URL final, limpa, que os usuários e rastreadores veem, excluindo "hashes" ou parâmetros desnecessários.

Enviar URLs dinâmicos dá ao Google um mapa claro da estrutura de sua aplicação e melhora as chances de "crawling" preciso e indexação mais rápida.

Habilitar "Lazy Loading" com [alternativas]

Você deve habilitar o lazy loading para melhorar o desempenho em SPAs adiando o carregamento de elementos "não essenciais" como imagens, vídeos ou seções "abaixo da dobra".

Isso ajuda a reduzir o tempo de carregamento inicial e aprimora a experiência do usuário em visualizações de desktop e dispositivos móveis.

Os "mecanismos de busca" podem não acionar "conteúdos" que carregam através do JavaScript, o que pode levar a uma indexação perdida.

Você deve fornecer alternativas como conteúdo de "placeholder" ou tags <noscript> para garantir que todos os elementos chave permaneçam visíveis para os rastreadores.

Use recursos nativos do navegador, como o atributo loading="lazy" ou gerencie o carregamento baseado em rolagem através de JavaScript. Você deve sempre confirmar a visibilidade usando ferramentas como o Google Search Console.

Evite atrasar "conteúdos" ou "links" importantes que contribuam para a visibilidade nas buscas. O uso adequado de "lazy loading" com alternativas confiáveis apoia uma velocidade de carregamento mais rápida e cobertura completa de "conteúdo".

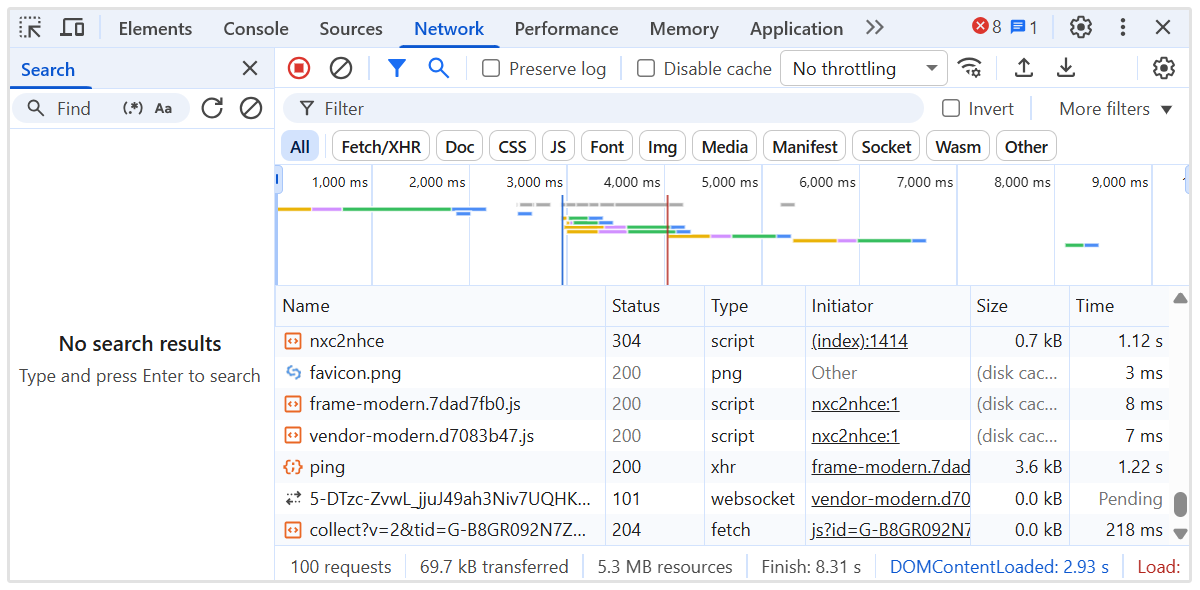

Adiar JavaScript Não Crítico

Você deve adiar o JavaScript não crítico para acelerar a renderização inicial da página e reduzir o bloqueio de conteúdo importante em aplicações de página única.

Scripts que não são essenciais para o conteúdo "above-the-fold" podem atrasar tanto a interação do usuário quanto a visibilidade do crawler.

Use os atributos defer ou async nas tags de script para evitar a execução desnecessária durante o carregamento da primeira página.

Coloque "scripts" [não essenciais] no final do documento ou carregue-os após o conteúdo principal ter sido renderizado.

Você deve identificar quais scripts afetam o layout, metadados ou lógica de roteamento, e separar esses de "analytics", widgets de chat, ou animações.

Ferramentas como Lighthouse e Chrome DevTools podem ajudar a auditar o comportamento do "script" e a sequência de carregamento.

Implementar "Linkagem" Interna entre Rotas SPA

Você deve criar uma estrutura de links internos clara entre todas as rotas em uma aplicação de página única para guiar os "crawlers" através do site.

Ao contrário dos sites tradicionais, os SPAs dependem da navegação no lado do cliente, o que pode impedir que os motores de busca descubram todas as páginas internas se os links não forem adicionados corretamente.

Use tags de âncora com atributos href adequados que reflitam o caminho real, não apenas funções JavaScript ou botões. Evite usar elementos como manipuladores onClick sem URLs significativas, pois estes são ignorados por rastreadores (na maioria das vezes).

Você deve garantir que todas as [páginas] importantes estejam [vinculadas] a outras partes do aplicativo, especialmente da página inicial e de páginas de alta autoridade. Isso ajuda a passar sinais de relevância e autoridade para uma [rastreamento] eficiente.

Mantenha uma hierarquia lógica com menus de navegação, "breadcrumbs" e links contextuais entre [visualizações] relacionadas. Use um texto âncora descritivo para reforçar os [tópicos] da página.

O "linking" interno melhora a profundidade de rastreamento, distribui autoridade e fortalece o desempenho geral de "search engine optimization" em todo o aplicativo.

Use um "Sitemap" que Reflete Todas as Rotas Importantes

Você deve gerar e enviar um sitemap que inclua todas as rotas [importantes] no aplicativo de página única.

Como os SPAs usam roteamento do lado do cliente, muitas "visões" internas podem não ser descobertas através da "rastreamento" tradicional.

Crie um sitemap XML que liste todas as rotas estáticas e dinâmicas destinadas à indexação. Inclua apenas URLs "limpas" e canônicas, sem parâmetros desnecessários, fragmentos ou dados de sessão.

Você deve atualizar o mapa do site sempre que novas rotas forem adicionadas, removidas ou alteradas. Ferramentas de automação podem regenerar o mapa do site durante cada implantação para mantê-lo preciso.

Envie o "sitemap" no Google Search Console para ajudar os mecanismos de busca a encontrar e priorizar [conteúdo] chave. Isso apoia a cobertura completa do índice e reforça a visibilidade em nível de rota.

Um sitemap bem mantido melhora a eficiência de rastreamento e garante que "visualizações críticas" recebam a atenção de que precisam.

Monitorar o Comportamento de Rastreamento com Logs do Servidor

Você deve analisar os registros do servidor para entender como os mecanismos de busca interagem com seu "Single Page Application".

Os logs revelam quais "rotas" estão sendo rastreadas, com que frequência são acessadas e se os "bots" encontram erros ou atrasos.

Revise os códigos de status HTTP, agentes do usuário e carimbos de data/hora para detectar "lacunas" de indexação ou ineficiências de "rastreamento".

Procure por sinais de [conteúdo perdido], acessos repetidos em páginas irrelevantes ou respostas falhas que possam prejudicar a visibilidade.

Você deve monitorar como o Googlebot navega por "rotas dinâmicas" e verificar se as "visualizações importantes" recebem a devida atenção de rastreamento. Combine dados de log com insights de ferramentas como o Google Search Console para verificar a cobertura de indexação.

Use ferramentas de análise de log do servidor ou exporte dados do seu ambiente de servidor NodeJS para [obter] visibilidade mais profunda.

Monitorar a atividade de bot em tempo real ajuda a identificar o desperdício de rastreamento, corrigir problemas de "descoberta" e otimizar o desempenho geral de SEO de SPA.

Resolver Problemas de Renderização com Conteúdo Dinâmico

Você deve resolver problemas de renderização em "single page applications" para garantir que o conteúdo dinâmico esteja totalmente visível para os mecanismos de busca.

O "conteúdo" que depende da execução do JavaScript pode falhar em aparecer durante a "crawling" se ele carregar muito tarde ou exigir interação do usuário.

Audite cada rota para confirmar que "texto importante", "links" e "títulos" estão disponíveis no resultado renderizado. Use ferramentas como Google’s URL Inspection Tool ou Lighthouse para detectar "conteúdo ausente" na renderização inicial.

Você deve aplicar técnicas como renderização no lado do servidor ou pré-renderização para entregar páginas totalmente construídas onde necessário.

Para "renderização" do lado do cliente, certifique-se de que os dados carreguem rapidamente e não dependam de "gatilhos" atrasados.

Evite injetar "informações críticas" após o rastreador já ter processado a página. Atrasos na renderização podem levar a indexação parcial ou exclusão dos resultados de pesquisa.

Corrigir "problemas de renderização" garante a visibilidade completa do "conteúdo chave", apoia uma melhor indexação e fortalece os resultados gerais de "otimização para mecanismos de busca" para SPAs.

Alinhar a Execução de JavaScript com as Capacidades do Crawler

Você deve estruturar a execução do JavaScript para corresponder aos limites de processamento dos rastreadores modernos, particularmente à fila de renderização e às restrições de recursos do Googlebot.

"Rastreadores" operam com um "orçamento de tempo" para cada URL. Portanto, cadeias de dependência excessivas, busca assíncrona de dados ou lógica de bloqueio de renderização podem resultar em indexação incompleta de [páginas] chave.

Priorize a renderização do conteúdo crítico durante a fase inicial de pintura. Evite camadas de hidratação aninhadas, mutações de DOM atrasadas ou uso excessivo de componentes somente para o cliente.

Substitua a injeção de conteúdo em tempo de execução por dados pré-buscados pelo servidor ou layouts esqueleto onde o HTML completo do servidor não for viável.

Você deve auditar o tempo de execução usando ferramentas como painel de Desempenho do Chrome DevTools e simular condições de rastreador com Puppeteer ou renderizadores NodeJS sem cabeça.

Acompanhe o Tempo para Interatividade (TTI), Maior Pintura de Conteúdo (LCP) e Tempo Total de Bloqueio (TBT) em condições sem cache.

Garanta que "metadata" específica de rota, "tags" canônicas e "schema" sejam montados de forma síncrona. Reduza a dependência de bibliotecas pesadas ou frameworks de roteamento em tempo de execução que atrasam a saída de renderização significativa.

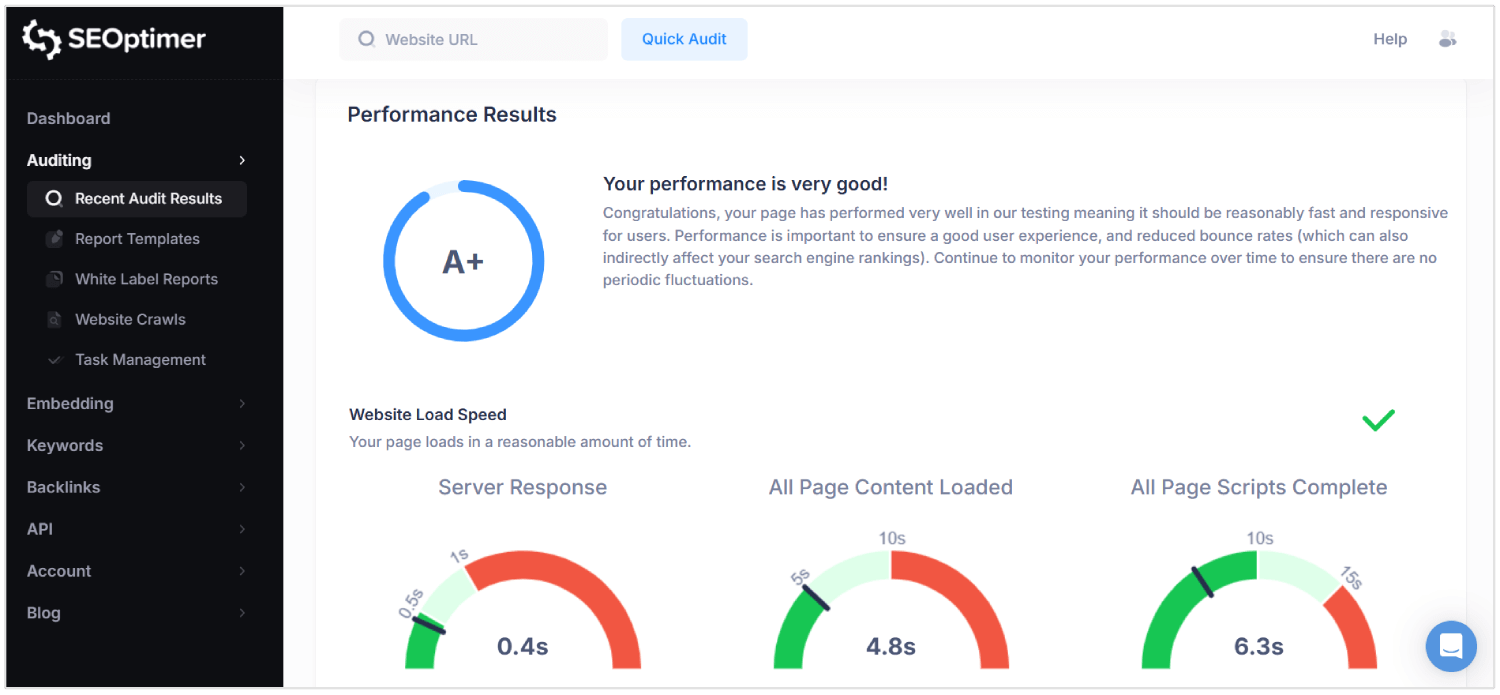

Audite o Desempenho de SEO com Ferramentas Especializadas

Você deve auditar seu desempenho de otimização para mecanismos de busca regularmente para detectar problemas de visibilidade em "single page applications".

Verificações padrão baseadas em navegador "não detectam" problemas "únicos" em ambientes com uso intensivo de JavaScript.

Usar ferramentas avançadas fornece visibilidade profunda de como as páginas são renderizadas, indexadas e pontuadas pelos mecanismos de busca.

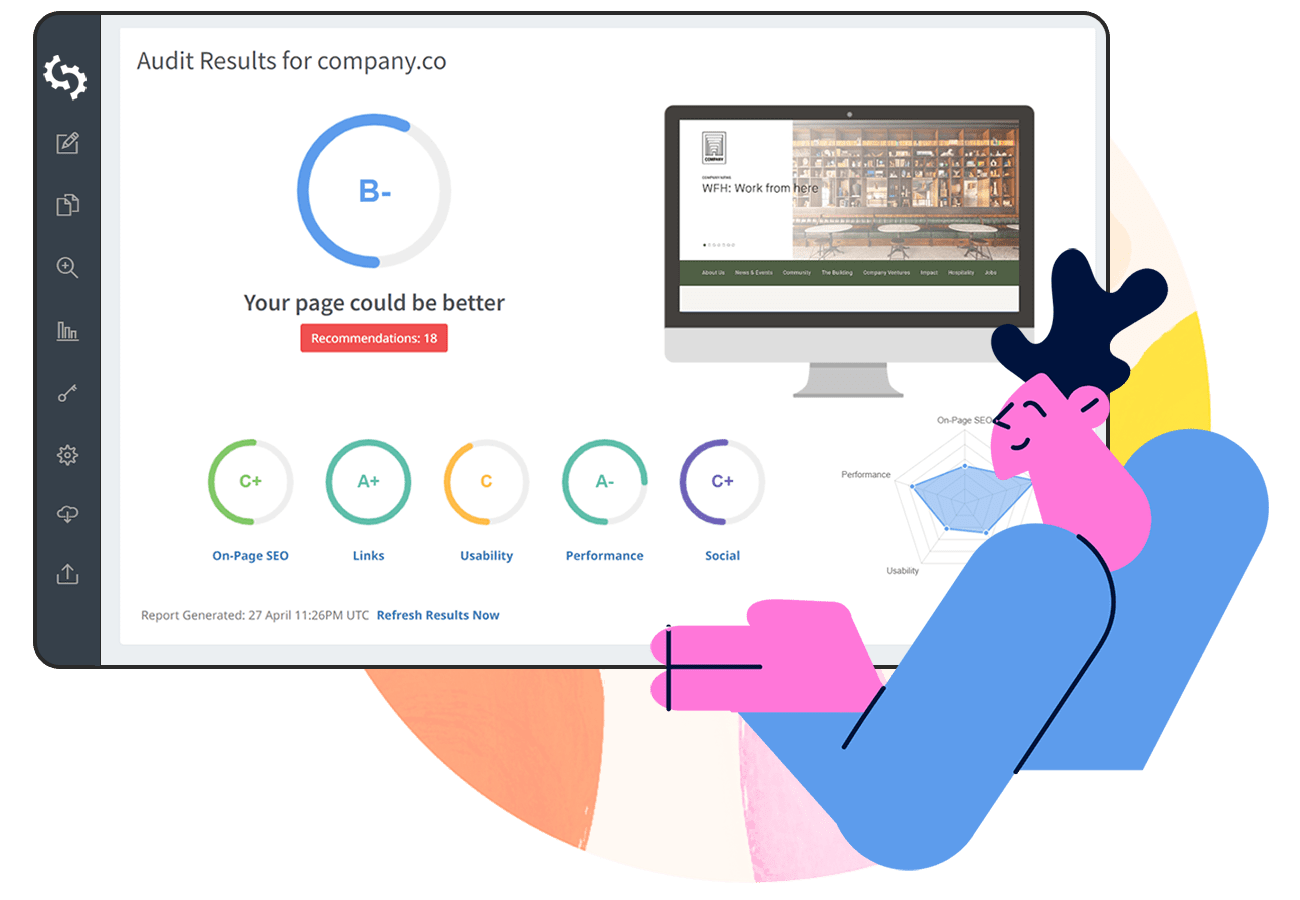

SEOptimer é uma dessas ferramentas que realiza auditorias abrangentes em camadas "técnicas", "on-page" e de "desempenho".

Ele analisa cada página para "qualidade" de metadados, "responsividade" móvel, estrutura de links internos e "relação" entre conteúdo e código.

Para SPAs, o SEOptimer ajuda a identificar elementos de "HyperText Markup Language" ausentes, tags canônicas mal configuradas e estruturas de cabeçalho fracas que afetam a [rastreamento].

Você deve executar auditorias do SEOptimer após implantar "atualizações" importantes ou lançar novas "rotas". A ferramenta sinaliza atrasos de "renderização", "links" quebrados e dependências de JavaScript que impedem o carregamento correto do conteúdo.

Combine o SEOptimer com ferramentas como o Google Search Console e analisadores de logs para validar [resultados] em condições reais de rastreamento.

As "auditorias" [regulares] garantem que a lógica de roteamento, a entrega de conteúdo e os comportamentos de renderização todos suportem o desempenho "SEO" [sustentado].

Por que "SEO" é desafiador para "SPAs"

O "SEO" é difícil para aplicativos de página única porque os "metadados", o conteúdo específico da rota e os códigos de status adequados podem ser perdidos ou mal interpretados pelos rastreadores.

Aqui estão os principais desafios de SEO para SPAs:

1. Renderização no [lado] do cliente

Os "mecanismos de busca" esperam que o conteúdo significativo esteja presente na resposta HTML inicial. As SPAs dependem do "JavaScript" para renderizar o conteúdo após o carregamento da página, o que atrasa a visibilidade.

Se um rastreador acessar a página antes de o "rendering" ser concluído, elementos-chave como texto e links podem não ser processados. Isso cria um risco de os mecanismos de busca indexarem páginas incompletas ou vazias.

Como resultado, "content [that users can see]" nunca chega aos resultados dos "search engine".

2. Limitações de "Crawling"

SPAs não expõem todas as páginas através de "links" estáticos tradicionais, tornando a "crawling" mais complexa.

Muitas páginas são acessíveis apenas através da navegação interna do lado do cliente, que os bots de busca podem não seguir.

Mesmo rastreadores modernos como o Googlebot renderizam JavaScript com atrasos e tempo de processamento limitado. Páginas que exigem múltiplos ciclos de renderização ou busca de dados aninhados podem exceder o "crawl budget".

"Visões importantes" podem ser completamente perdidas, enfraquecendo a "visibilidade do site" nos "resultados de pesquisa".

3. Manipulação Dinâmica de Metadados

Cada visualização em um SPA carece de metadados únicos a menos que configurada manualmente.

Sem "atualizações" dinâmicas para títulos, descrições e "tags canônicas", todos os URLs aparecem idênticos para os mecanismos de busca.

Isso leva a "erros" de indexação, "relevância" reduzida e "taxas" de cliques mais baixas.

Os "metadados" vinculados às alterações de URL devem ser injetados em tempo real usando bibliotecas ou lógica personalizada. A falha em gerenciar isso impede que o aplicativo seja classificado corretamente em diferentes consultas de pesquisa.

4. Estruturas de URL "Não Padrão"

SPAs podem usar URLs que dependem de fragmentos de hash ou manipulação do histórico do navegador. Esses formatos podem causar confusão para os mecanismos de busca que preferem caminhos "limpos" e [canônicos].

Se uma rota não tiver uma estrutura adequada, pode não ser indexada ou pode ser tratada como um "duplicado".

URLs "inconsistentes" também quebram "deep linking", que é "crítico" para a navegação do usuário e "crawl depth".

O desempenho de "SEO" sofre quando bots não conseguem interpretar ou acessar URLs reais e distintas.

5. Códigos de Status HTTP Incorretos

Ao contrário dos sites tradicionais, as SPAs respondem com 200 OK mesmo para "rotas" inexistentes.

Isso "engana" os motores de busca a indexarem páginas de erro ou conteúdo irrelevante.

Sem códigos corretos como 404 Não Encontrado ou 301 Redirecionamento, rastreadores não conseguem remover páginas desatualizadas ou seguir novos caminhos.

Os "bots" exigem sinais de status precisos para interpretar a estrutura do site e as mudanças de conteúdo.

As "SPAs" que [mishandle] essas respostas perdem o controle sobre como seu conteúdo aparece nos resultados de pesquisa.

6. Sem recarregamento de página durante a navegação

Em SPAs, as mudanças de rota acontecem dentro do navegador sem recarregar a página. Isso impede que os mecanismos de busca reconheçam eventos de navegação como novas páginas.

"Bots" podem "assumir" que o "usuário" ainda está na mesma página, o que limita a indexação de novas visualizações.

Ao contrário dos sites de várias páginas, as "SPAs" devem simular essas transições para que as ferramentas de "SEO" as detectem. Sem isso, o conteúdo específico da rota é ignorado ou classificado incorretamente.

7. Renderização Atrasada de Conteúdo

SPAs atrasam o conteúdo visível devido a múltiplas dependências de JavaScript e carregamento assíncrono.

Devido a isso, "search engine crawlers" podem processar a página antes que os dados essenciais apareçam.

"Tempos" de renderização longos podem resultar em "indexação parcial", "títulos" ausentes e "resumos de página" incompletos.

Se o conteúdo significativo não estiver pronto durante a varredura, os mecanismos de busca assumem que a página carece de valor ou podem considerar a página como "conteúdo [fraco]."

Isto, em última análise, reduz "classificações", "visibilidade" e "tráfego".

Conclusão

Acertar o SEO para "single page applications" não é simples.

Os "mecanismos de busca" precisam ver o conteúdo real imediatamente, não esperar que scripts o carreguem depois. Portanto, você deve enviar HTML adequado, tratando cada rota como uma página real e atualizando títulos e descrições conforme o usuário navega pelo aplicativo.

Você também precisa gerenciar "códigos de status", construir "links internos", adicionar "dados estruturados" e garantir que os mecanismos de busca possam rastrear todas as partes do site. Quando tudo está no lugar, sua aplicação de página única se torna mais fácil de indexar e mais fácil de ranquear.