Faire en sorte que votre application à page unique (SPA) soit découverte par les moteurs de recherche n'est pas une mince affaire. Le référencement pour les applications à page unique aide vos applications web à obtenir plus de vues organiques.

Les sites Web basés sur HTML sont plus faciles à accéder, explorer et indexer car ils fournissent un balisage structuré pour les "crawlers".

Par conséquent, avoir votre contenu dans des pages HTML peut mener à de meilleurs classements de recherche, et elles sont plus faciles à optimiser que les applications [à] page unique.

Les SPAs s'appuient fortement sur JavaScript pour réécrire dynamiquement le contenu en fonction des actions d'un visiteur sur le site (pensez au "texte" extensible ou aux boîtes "pop-up").

Par conséquent, cela rend difficile pour les Googlebots d'indexer le contenu de la page car il n'exécute pas le contenu JavaScript côté client.

Dans cet article, je vais discuter des véritables défis de l'utilisation des SPAs et partager le processus complet de réalisation du SEO pour les applications monopage afin d'obtenir un meilleur classement dans les recherches.

Points Clés

- Le SEO pour les applications monopage est essentiel car les SPAs pilotées par JavaScript cachent souvent le contenu clé aux robots d'indexation.

- Utilisez le "rendu côté serveur" (SSR) ou le "pré-rendu" pour fournir aux robots des versions HTML entièrement rendues de vos pages.

- Les titres dynamiques, les [méta-descriptions] et les balises canoniques sont cruciaux pour le SEO des applications monopage afin de prévenir le [contenu dupliqué] et de maintenir la pertinence à travers les routes.

- Combinez les liens internes, les URL propres, les sitemaps XML et les codes d'état HTTP corrects pour aider les moteurs de recherche à découvrir et indexer toutes les routes clés au sein de votre SPA.

Qu'est-ce que le SEO pour les applications monopage (SPA) ?

L'optimisation des moteurs de recherche pour les applications à page unique fait référence au processus de rendre les SPAs, construits avec des cadres JavaScript tels que React.js, Angular.js ou Vue.js, accessibles et indexables par les moteurs de recherche.

Le SEO pour les applications à page unique inclut :

- Rendu côté serveur ou [pré-rendu]

- [Balises] de titre, [méta descriptions], et optimisation des données structurées

- Optimisation des URL et des balises canoniques

- Optimisation du [maillage interne]

- Création et soumission de [sitemaps]

- [Netlinking]

Google, Bing, Baidu, DuckDuckGo, et d'autres moteurs de recherche trouvent qu'il est difficile d'explorer et d'indexer le contenu JavaScript puisque les SPAs chargent le contenu de manière dynamique côté client.

Par conséquent, SPA SEO consiste en des stratégies et des meilleures pratiques pour améliorer la "découvrabilité" et la présence sur le web des applications à [page] unique dans les moteurs de recherche.

Exemples de "Single Page Applications"

Voici les meilleurs exemples de SPAs :

Gmail

Gmail est un exemple type de SPA. Lorsque vous vous connectez, l'ensemble de "l'interface utilisateur", y compris votre "boîte de réception", vos "dossiers" et le "chat", est chargé une fois.

À partir de ce moment-là, parcourir les e-mails, ouvrir des fils de discussion ou rédiger de nouveaux messages ne nécessite pas un rechargement complet de la page.

JavaScript gère la [navigation] et les [changements] de contenu en arrière-plan, rendant l'[expérience] rapide et fluide.

Google utilise des requêtes asynchrones pour récupérer uniquement les données nécessaires, réduisant ainsi la latence et améliorant l'expérience utilisateur.

Google Maps

Google Maps offre des fonctionnalités interactives riches telles que le "déplacement", le "zoom" et la "recherche" de [lieux], le tout sur la même page.

Il ne se recharge pas lorsque vous demandez de "nouvelles" directions ou que vous passez de la vue satellite à la vue carte.

Au lieu de cela, les données sont récupérées via AJAX, et les tuiles de la carte ou les composants de l'interface utilisateur se mettent à jour dynamiquement. Cela rend Google Maps extrêmement réactif et utilisable, même avec des connexions plus lentes.

Bien que pas à 100% SPA, de grandes parties de Facebook utilisent l'architecture SPA.

Lorsque les utilisateurs défilent dans leur fil d'actualités, ouvrent des publications, réagissent ou commentent, toutes les mises à jour se produisent sans rechargement de la page.

Même lors du passage entre les pages comme "Messages", "Notifications", et "Marketplace", le site utilise le routage côté client avec des frameworks JavaScript (comme React) pour rendre dynamiquement le contenu, ce qui réduit les appels au serveur et améliore la vitesse de chargement.

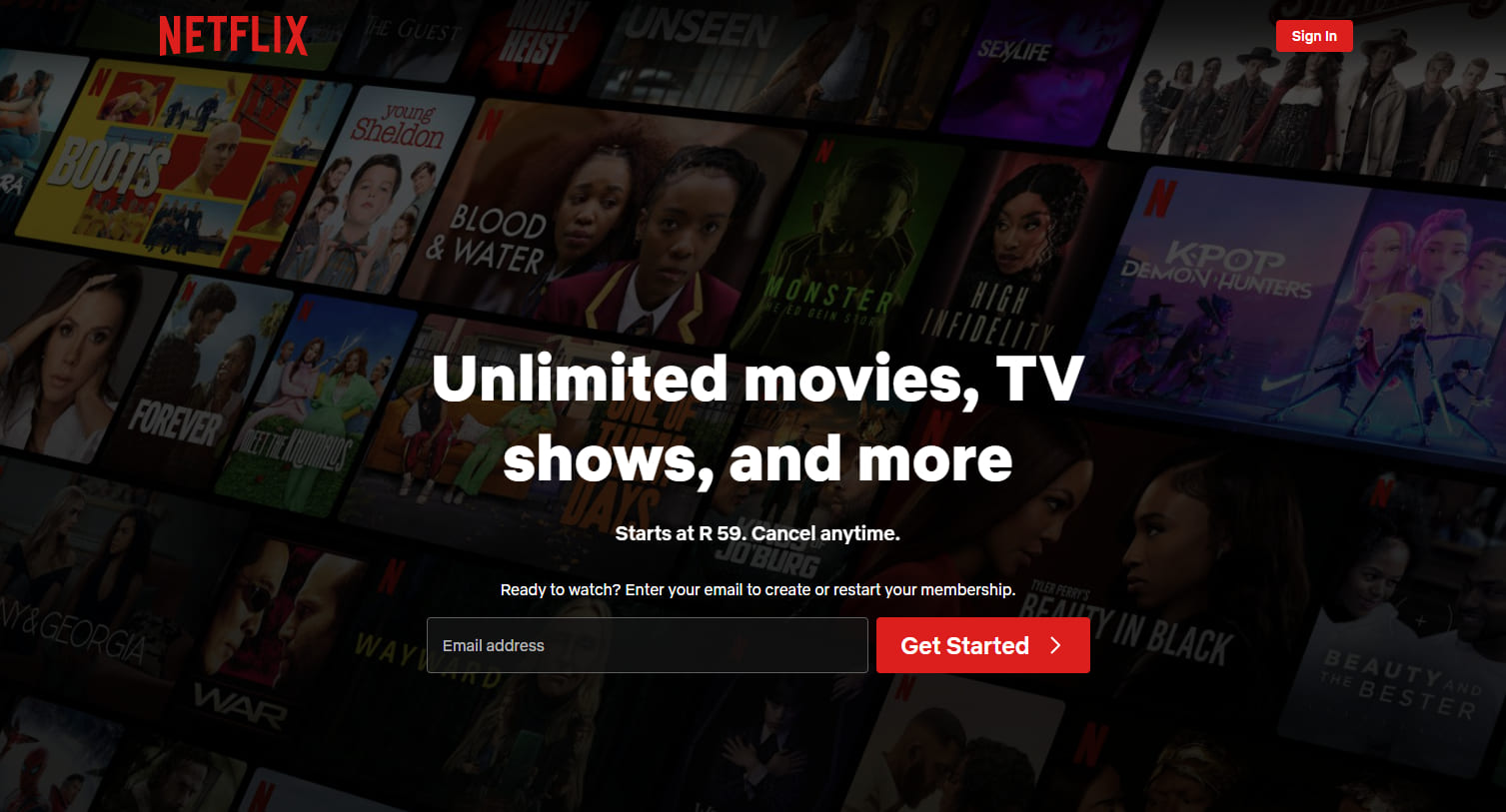

Netflix

L'interface web de Netflix est une autre SPA de haut niveau. Lorsque vous parcourez des suggestions de films ou d'émissions télévisées, les bandes-annonces se lancent automatiquement et les détails du contenu apparaissent immédiatement sans rechargement.

Cliquer sur un titre ouvre une superposition modale ou une nouvelle vue tout en conservant l'interface principale intacte.

Le routage, les "recommandations", et les "changements de profil utilisateur" sont gérés par JavaScript, offrant une expérience cohérente avec des temps d'attente réduits.

Une "Single Page Application" est-elle [bonne] pour le SEO ?

Oui, une "single page application" est bonne pour le SEO si vous connaissez les bonnes astuces d'optimisation pour les SPAs.

Les moteurs de recherche comme Google peuvent "rendre" JavaScript, mais ils peuvent retarder l'exploration ou ignorer le contenu qui nécessite une [interaction] utilisateur.

Pour éviter cela, vous pouvez utiliser le "rendu côté serveur", la "génération de site statique", le "routage d'URL propre" et les "mises à jour dynamiques des métadonnées".

Les outils comme Next.js, Nuxt.js, React Helmet et Vue Meta aident à faire tout ce [travail].

Avec la bonne configuration, une SPA peut se classer tout aussi bien que n'importe quel site traditionnel. Cependant, sans ajustements SEO appropriés, les moteurs de recherche pourraient manquer beaucoup de ce que vous avez construit.

Lecture Connexe : Comment effectuer le SEO pour le contenu dynamique

Comment faire du SEO pour les "Single Page Applications"

Voici les meilleures solutions de SEO pour les applications web à page unique :

Utiliser le "Server-Side Rendering" (SSR)

Les applications [single page] s'appuient sur JavaScript pour charger le contenu de manière dynamique.

Cependant, les moteurs de recherche s'attendent à un HTML serveur complet dans la réponse HTTP pour accéder, explorer et indexer le contenu.

Par conséquent, vous devriez mettre en œuvre le rendu côté serveur pour "rendre" les pages sur le serveur avant de les envoyer au "navigateur".

Dans le rendu côté serveur, le navigateur demande des fichiers HTML, et le serveur récupère toutes les données. Il garantit que tout le contenu est immédiatement visible et [explorable].

Mettre en cache les pages fréquemment consultées pour réduire les temps de chargement et servir le contenu plus rapidement. Évitez le rendu côté client pour les éléments clés, car les moteurs de recherche peuvent ne pas traiter les vues "lourdes en JavaScript".

Mettre en œuvre le pré-rendu pour les "routes" statiques

Vous devriez pré-rendre les routes qui montrent le même contenu à chaque visiteur. Cela vous permet de générer du HTML au moment de la construction et élimine le besoin de rendu à l'exécution.

En conséquence, les moteurs de recherche peuvent accéder à la page instantanément.

Les outils de génération statique des frameworks comme Next.js ou Nuxt.js peuvent vous aider à créer des fichiers statiques pour des routes comme les [pages d'atterrissage], [blogs] ou [aperçus de produits].

Vous devriez servir ces pages pré-rendues via un Réseau de Diffusion de Contenu ou un serveur web pour améliorer la vitesse de chargement et la visibilité. Évitez d'appliquer le pré-rendu aux vues avec des données "en temps réel" ou spécifiques à l'utilisateur.

Ajouter une sortie HyperText Markup Language propre et explorée

Vous devez générer une sortie HyperText Markup Language bien structurée que les moteurs de recherche peuvent facilement interpréter.

Un balisage propre aide les robots à comprendre la mise en page de la page, la hiérarchie et les éléments clés sans s'appuyer sur l'exécution de JavaScript.

Évitez d'injecter du contenu dynamiquement après le chargement de la page. Au lieu de cela, assurez-vous que le texte important, les titres, et les liens apparaissent directement dans le code source.

Quand vous travaillez sur le SEO pour une application à page unique, la chose la plus importante à se rappeler est que Google ne voit pas toujours votre page de la même manière que les gens. Parce qu'elles chargent du contenu avec JavaScript, parfois le robot d'indexation obtient juste une page blanche. Alors assurez-vous que ce que vous voulez que Google lise apparaît réellement dans le html.

- Ciara Edmondson, Responsable SEO & Contenu chez Max Web Solutions

Utilisez des balises sémantiques comme <header>, <main>, <article>, et <footer> pour fournir une structure claire.

Vous devez également minimiser les styles en ligne et l'encombrement des scripts qui pourraient obscurcir le contenu significatif.

Gardez le document lisible et léger pour un "crawling" plus rapide et un meilleur [indexing].

Utilisez le "rendu côté serveur" ou le "pré-rendu" pour produire du HTML statique pour chaque route. Cela garantit que les robots d'exploration accèdent au contenu complet de la page lors de la demande initiale.

Exposer des "instantanés statiques" pour les "crawlers"

Vous devriez exposer des instantanés statiques pour garantir que les robots d'exploration puissent accéder au contenu complet, surtout lorsque le rendu côté client retarde la sortie de la page.

Un "instantané" statique est une version entièrement rendue de la page générée à l'avance et servie spécifiquement aux bots.

Cette tactique est utile lorsque le "server-side rendering" ou le "pre-rendering" n'est pas envisageable dans l'ensemble de l'application.

Les instantanés offrent un chemin alternatif pour que les crawleurs accèdent au langage de balisage hypertexte structuré sans exécuter JavaScript.

Vous devez configurer le serveur pour détecter les agents utilisateurs comme Googlebot et fournir des "instantanés" pré-construits pour ces requêtes.

Les outils comme Rendertron, Prerender.io, ou des "rendeurs" NodeJS personnalisés sans tête peuvent aider à générer et livrer des "instantanés" de manière fiable.

Assurez-vous que chaque instantané reflète le contenu et la structure complets de la page, y compris les titres, les métadonnées, les liens et le balisage de schéma.

Safira de Somar Digital, une agence basée en Nouvelle-Zélande, recommande que toutes les SPAs devraient utiliser le "balisage de schéma" pour leur SEO.

Je recommande d'utiliser le balisage de schéma de données structurées pour les "SPAs". Intégrez des balisages de schéma pertinents tels que [organisation], [page Web], [liste de fil d'Ariane], [FAQ], etc.

J'ai remarqué que parfois le balisage de schéma peut ne pas apparaître dans le code source ou même dans le test des résultats enrichis de Google, mais si vous testez le schéma à l'aide du validateur de balisage de schéma, vous verrez les balisages de schéma ajoutés dans les résultats. Cela se produit parce que les [SPAs] qui injectent le [Schema] (via [JavaScript]) ne l'ont pas disponible lors du chargement initial. Mais Google est capable de lire le [JavaScript] car il est sans interface graphique.

- Safira Mumtaz, Spécialiste "SEO/SEM" chez Somar Digital

Vous devriez également surveiller la couverture de l'index pour confirmer que les crawlers traitent les instantanés comme prévu.

Servir des "instantanés" statiques améliore la visibilité pour les pages avec une logique de rendu complexe, aidant à maintenir une indexation et une valeur SEO cohérentes.

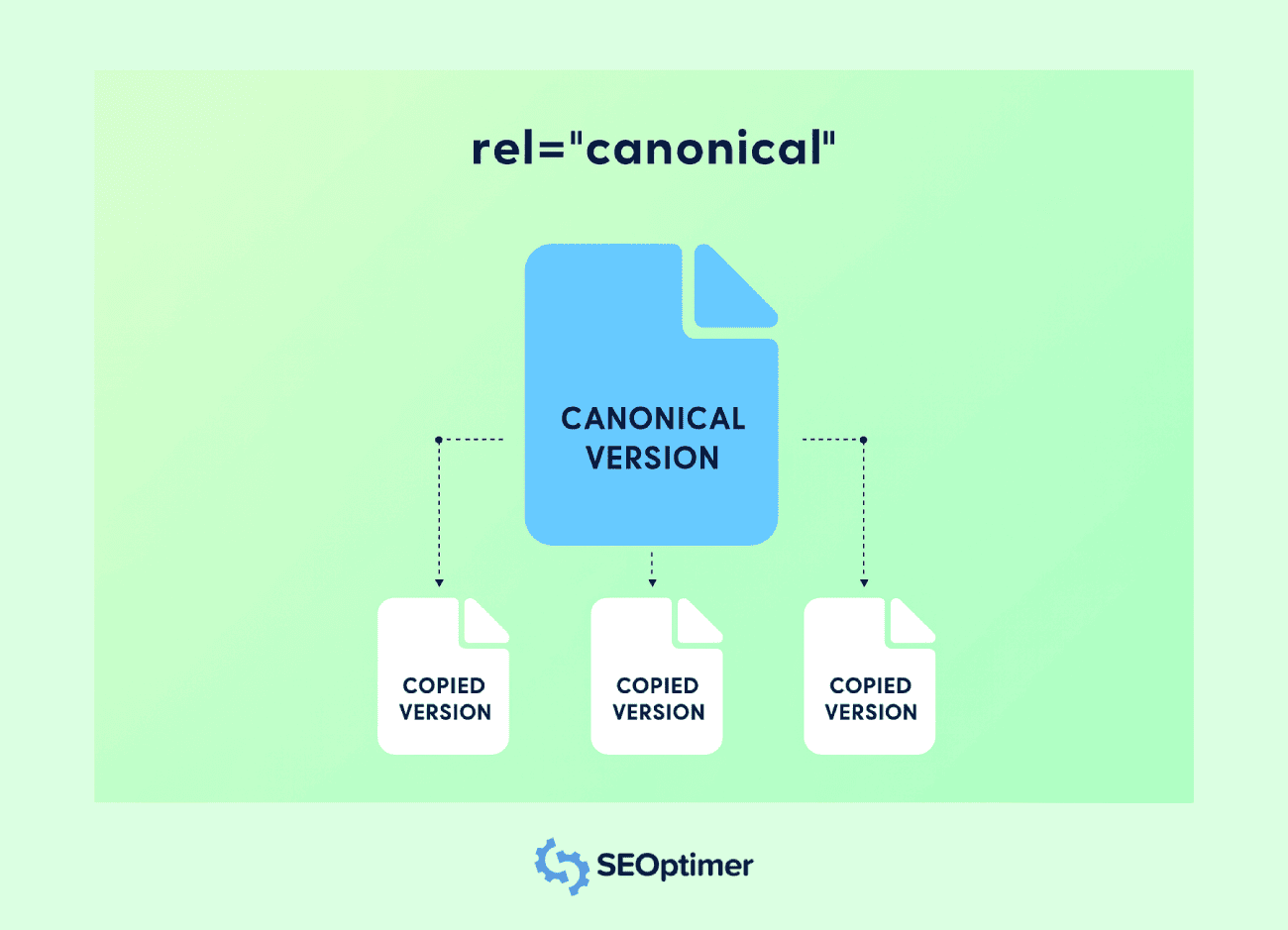

Configurer les balises canoniques pour chaque vue

Vous devriez définir une balise canonique pour chaque route dans une application à page unique afin d'éviter les problèmes de contenu dupliqué.

La plupart du temps, les SPA généreront plusieurs URL accessibles pour le même contenu.

Par exemple, le même contenu peut être présent dans des URL avec différentes chaînes de requête, filtres ou paramètres de suivi. Les balises canoniques aident les moteurs de recherche à comprendre la version "préférée".

Chaque itinéraire doit inclure une balise <link rel="canonical"> pointant vers l'URL d'origine pour cette vue. Cela empêchedilution de "link equity"parmi les différentes URL ayant le même contenu.

Vous devriez injecter des balises canoniques de manière dynamique lorsque la route change, surtout si l'application met à jour les métadonnées côté client.

Utilisez des "hooks" de routage ou des fonctions de "middleware" pour attribuer le [tag] correct à chaque transition de page.

Évitez de pointer toutes les routes vers la page d'accueil ou d'utiliser une valeur canonique statique. Chaque vue unique doit refléter son propre URL logique pour préserver la pertinence et l'exactitude de l'index.

La mise en œuvre d'une "canonicalisation" appropriée soutient un [indexage] plus clair, améliore l'autorité de la page et prévient la duplication non désirée dans les résultats de recherche.

Gérer correctement le code 404 et les autres codes d'état

Vous devez configurer des codes d'état précis pour toutes les vues dans une application à page unique afin d'aider les moteurs de recherche à interpréter correctement la structure de votre site.

De nombreux SPA servent une coquille HTML par défaut pour chaque requête, ce qui peut renvoyer un 200 OK même pour les itinéraires [non-existants].

Une réponse appropriée "404 Non Trouvé" doit être retournée pour les URL invalides.

Utilisez la logique serveur ou le middleware dans NodeJS pour détecter les [itinéraires] non correspondants et envoyer le code de statut correct ainsi qu'une page d'erreur personnalisée.

Vous devez également gérer d'autres réponses comme 301 ou 302 pour [redirection] et 500 pour [erreurs du serveur].

Ces codes d'état informent les moteurs de recherche sur la façon de traiter chaque demande et de maintenir l'intégrité de votre couverture de crawl et d'index.

Évitez de vous fier uniquement à la gestion des erreurs côté client. Les crawlers peuvent ne pas exécuter JavaScript, donc des réponses d'état incorrectes peuvent nuire aux signaux d'optimisation pour les moteurs de recherche et induire en erreur l'indexation.

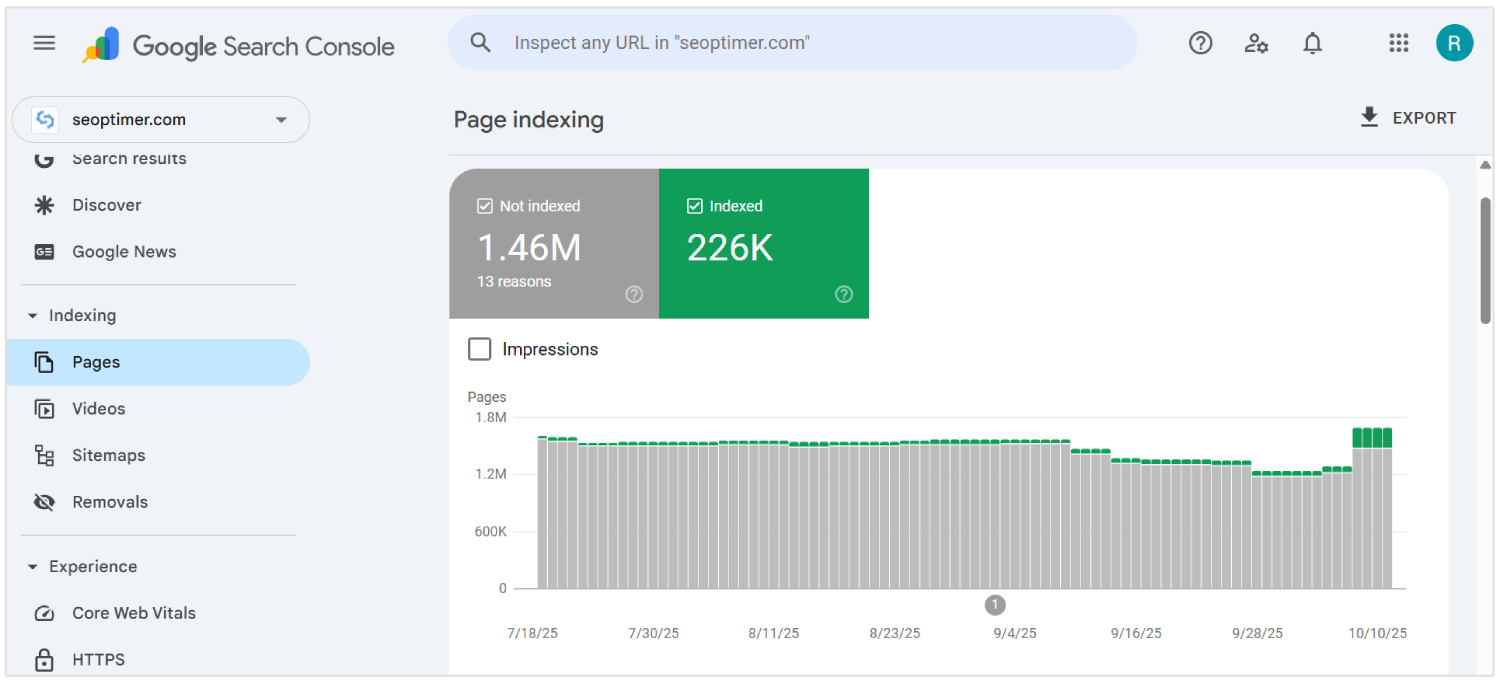

Soumettre des URL dynamiques à Google Search Console

Vous devriez soumettre toutes les URL dynamiques importantes d'une [single page application] à Google Search Console en utilisant l'[URL Inspection Tool]. Cela aide les robots des moteurs de recherche à découvrir et indexer le contenu qui peut ne pas apparaître dans une exploration traditionnelle.

Comme les SPAs chargent du contenu via le routage côté client, certaines pages internes [peuvent] ne pas être trouvées par les crawleurs sans lien direct.

Pour garantir la visibilité, listez ces URL dans un sitemap XML et soumettez-le via l'interface de la console.

Vous devriez mettre à jour le plan du site chaque fois que de nouvelles routes sont ajoutées ou modifiées. Chaque entrée doit refléter l'URL finale et propre que les utilisateurs et les robots voient, en excluant les hashtags ou les paramètres inutiles.

La soumission d'URL dynamiques donne à Google une carte claire de la structure de votre application et améliore les chances d'un [crawling] précis et d'une indexation plus rapide.

Activer le chargement différé avec des solutions de secours

Vous devriez activer le chargement paresseux pour améliorer les performances dans les SPAs en reportant le chargement des éléments "non essentiels" tels que les images, vidéos ou sections situées "en dessous de la ligne de flottaison".

Il aide à réduire le temps de chargement initial et améliore l'expérience utilisateur sur les vues de bureau et mobiles.

Les moteurs de recherche peuvent ne pas déclencher le contenu qui se charge via JavaScript, ce qui peut entraîner un [manque] d'indexation.

Vous devriez fournir des solutions de rechange comme le contenu de "remplissage" ou les balises <noscript> pour vous assurer que tous les éléments clés restent visibles pour les "explorateurs".

Utilisez les fonctionnalités natives du navigateur telles que l'attribut loading="lazy" ou gérez le chargement basé sur le défilement via JavaScript. Vous devez toujours confirmer la visibilité en utilisant des outils comme Google Search Console.

Évitez de retarder le contenu important ou les liens qui contribuent à la visibilité dans les recherches. Une utilisation appropriée du "lazy loading" avec des solutions de secours fiables soutient une vitesse de chargement plus rapide et une couverture complète du contenu.

Différer le JavaScript non critique

Vous devriez différer le JavaScript non critique pour accélérer le rendu initial de la page et réduire le blocage du contenu important dans les applications monopage.

Les scripts qui ne sont pas essentiels pour le contenu "au-dessus de la ligne de flottaison" peuvent retarder à la fois l'interaction utilisateur et la visibilité par les moteurs de recherche.

Utilisez les attributs defer ou async dans les balises script pour éviter une exécution inutile lors du chargement de la première page.

Placez les scripts "non essentiels" à la fin du document ou chargez-les après que le "contenu principal" a été rendu.

Vous devez identifier quels scripts affectent la mise en page, les métadonnées ou la logique de routage, et les séparer de l'analyse, des "widgets" de chat ou des animations.

Des outils comme Lighthouse et Chrome DevTools peuvent aider à auditer le comportement des scripts et la séquence de chargement.

Mettre en œuvre le [lien] interne entre les itinéraires SPA

Vous devriez créer une structure de liens internes claire entre toutes les routes dans une application à page unique pour guider les robots d'indexation à travers le site.

Contrairement aux sites web traditionnels, les SPAs reposent sur la navigation côté client, ce qui peut empêcher les moteurs de recherche de découvrir toutes les pages internes si les liens ne sont pas ajoutés correctement.

Utilisez des balises d'ancrage avec des attributs href appropriés qui reflètent le chemin réel, pas seulement des fonctions JavaScript ou des boutons. Évitez d'utiliser des éléments comme les gestionnaires onClick sans URL significatives, car ceux-ci sont ignorés par les crawlers (la plupart du temps).

Vous devez vous assurer que chaque page importante est liée à partir d'autres parties de l'application, en particulier depuis la page d'accueil et les pages à haute autorité. Cela aide à transmettre des signaux de pertinence et d'autorité pour un "crawling" efficace.

Maintenez une hiérarchie logique avec des menus de navigation, des "breadcrumbs" et des liens contextuels entre les vues connexes. Utilisez un texte d'ancrage descriptif pour renforcer les sujets de la page.

Le "maillage interne" améliore la profondeur d'exploration, distribue l'autorité et renforce la performance globale de l'optimisation pour les moteurs de recherche sur l'ensemble de l'application.

Utilisez un "sitemap" qui reflète toutes les [routes] importantes

Vous devriez générer et soumettre un sitemap qui inclut chaque route importante dans l'application [single page].

Étant donné que les SPAs utilisent le routage côté client, de nombreuses [vues] internes peuvent ne pas être découvertes par le biais du [crawling] traditionnel.

Créer un plan de site XML qui répertorie toutes les routes statiques et dynamiques destinées à l'indexation. Inclure uniquement des URL canoniques, "propres" sans paramètres, fragments ou données de session inutiles.

Vous devez mettre à jour le plan du site chaque fois que de nouvelles routes sont ajoutées, supprimées ou modifiées. Les outils d'automatisation peuvent régénérer le plan du site lors de chaque déploiement pour le maintenir précis.

Soumettez le sitemap dans Google Search Console pour aider les moteurs de recherche à trouver et à prioriser le contenu clé. Cela soutient une couverture d'index complète et renforce la visibilité au niveau des routes.

Un sitemap bien entretenu améliore l'efficacité de l'exploration et garantit que les [vues] "critiques" reçoivent l'attention dont elles ont besoin.

Surveiller le comportement d'exploration avec les journaux du serveur

Vous devriez analyser les journaux du serveur pour comprendre comment les moteurs de recherche interagissent avec votre "Single Page Application".

Les journaux révèlent quelles "routes" sont explorées, à quelle fréquence elles sont consultées, et si les "bots" rencontrent des erreurs ou des retards.

Examinez les codes d'état HTTP, les agents utilisateurs et les horodatages pour détecter les lacunes d'indexation ou les inefficacités de crawl.

Cherchez des signes de "contenu manqué", des visites répétées sur des pages "non pertinentes", ou des "réponses échouées" qui pourraient nuire à la visibilité.

Vous devriez suivre comment Googlebot navigue à travers les routes dynamiques et vérifier que les vues [importantes] reçoivent une attention d'exploration. Combinez les données de logs avec des [informations] d'outils comme Google Search Console pour vérifier la couverture d'indexation.

Utilisez des outils d'analyse de journaux de serveur ou exportez des données depuis votre environnement serveur NodeJS pour une visibilité plus approfondie.

La surveillance de l'activité des bots en temps réel aide à identifier le "gaspillage d'exploration", à résoudre les problèmes de "découvrabilité" et à optimiser les performances globales du SEO des SPA.

Résoudre les problèmes de rendu avec le [contenu dynamique]

Vous devez résoudre les problèmes de rendu dans les applications à page unique pour vous assurer que le contenu dynamique est entièrement visible par les moteurs de recherche.

Le "contenu" qui dépend de l'exécution de JavaScript peut ne pas apparaître lors de l'exploration s'il se charge trop tard ou nécessite une interaction de l'utilisateur.

Auditez chaque itinéraire pour confirmer que le texte important, les liens et les titres sont disponibles dans le rendu. Utilisez des outils comme l’outil d’inspection d’URL de Google ou Lighthouse pour détecter le contenu manquant du rendu initial.

Vous devriez appliquer des techniques telles que le "rendu côté serveur" ou le "pré-rendu" pour livrer des pages entièrement construites là où c'est nécessaire.

Pour le rendu côté client, assurez-vous que les données se chargent rapidement et ne dépendent pas de "déclencheurs" retardés.

Évitez d'injecter des "informations critiques" après que le [crawler] a déjà traité la page. Les retards dans le rendu peuvent entraîner une indexation partielle ou une exclusion des résultats de recherche.

La correction des [problèmes] de rendu [garantit] une visibilité complète du [contenu clé], [soutient] un meilleur indexage et renforce les résultats globaux de l'optimisation pour les moteurs de recherche pour les SPAs.

Aligner l'exécution de JavaScript avec les capacités du crawler

Vous devez structurer l'exécution de JavaScript pour correspondre aux limites de traitement des robots d'exploration modernes, en particulier la file d'attente de rendu et les contraintes de ressources de Googlebot.

Les "crawlers" fonctionnent avec un budget de temps pour chaque URL. Par conséquent, des chaînes de dépendance excessives, une récupération de données asynchrone ou une logique de blocage du rendu peuvent entraîner une indexation incomplète des pages clés.

Prioriser le rendu du contenu du "chemin critique" pendant la phase de "peinture initiale". Éviter les couches d'hydratation imbriquées, les mutations du DOM retardées ou l'utilisation excessive de composants uniquement client.

Remplacez "l'injection de contenu" à l'exécution par des "données préchargées" par le serveur ou des "mises en page squelettes" lorsque le HTML complet du serveur n'est pas réalisable.

Vous devriez auditer le [timing] d'exécution en utilisant des outils comme le panneau Performance de Chrome DevTools et simuler les conditions du "crawler" avec Puppeteer ou des moteurs de rendu NodeJS sans tête.

Suivre le "Time to Interactive" (TTI), le "Largest Contentful Paint" (LCP) et le "Total Blocking Time" (TBT) dans des conditions de non-mise en cache.

Assurez-vous que les métadonnées spécifiques à l'itinéraire, les balises canoniques et le schéma sont montés de manière synchrone. Réduisez la dépendance aux bibliothèques lourdes ou aux frameworks de routage en temps réel qui retardent la sortie de rendu significative.

Auditez la "performance SEO" avec des "outils spécialisés"

Vous devriez auditer régulièrement vos performances en matière d'optimisation pour les moteurs de recherche afin de détecter les problèmes de visibilité dans les "applications à page unique".

Les vérifications standard basées sur le navigateur manquent des problèmes uniques aux environnements "lourds en JavaScript".

L'utilisation d'outils avancés offre une [visibilité] approfondie sur la manière dont les pages sont [rendu], [indexé] et [noté] par les moteurs de recherche.

SEOptimer est un tel outil qui effectue des audits complets sur les couches techniques, "on-page", et de performance.

Il analyse chaque page pour la qualité des métadonnées, la réactivité mobile, la structure de lien interne, et le ratio "contenu-à-code".

Pour les SPAs, SEOptimer aide à identifier les éléments [manquants] de [HyperText Markup Language], les balises canoniques mal configurées et les structures d'en-tête faibles qui affectent la [crawlability].

Vous devez exécuter des audits SEOptimer après avoir déployé des mises à jour majeures ou lancé de nouvelles routes. L'outil signale les "retards de rendu", les "liens brisés" et les "dépendances JavaScript" qui empêchent le contenu de se charger correctement.

Combinez SEOptimer avec des outils comme Google Search Console et les analyseurs de journaux pour valider les résultats dans des conditions de [crawl] réelles.

Des audits réguliers garantissent que la logique de routage, la diffusion de contenu et les comportements de rendu [soutiennent] tous une performance SEO [durable].

Pourquoi le SEO est [difficile] pour les SPAs

Le référencement est difficile pour les applications à page unique parce que les métadonnées, le contenu spécifique aux "itinéraires", et les [codes] d'état appropriés peuvent être manqués ou mal compris par les robots d'indexation.

Voici les principaux défis SEO pour les SPAs :

1. Rendu Côté Client

Les moteurs de recherche s'attendent à ce que du contenu significatif soit présent dans la réponse HTML initiale. Les SPAs [reposent] sur JavaScript pour "rendre" le contenu après le chargement de la page, ce qui retarde la visibilité.

Si un robot d'exploration accède à la page avant que le rendu ne soit terminé, des éléments clés comme le "texte" et les "liens" peuvent ne pas être traités. Cela crée un risque que les moteurs de recherche indexent des pages incomplètes ou vides.

En conséquence, le contenu que les utilisateurs peuvent voir n'atteint jamais les résultats des moteurs de recherche.

2. Limitations du crawling

Les "SPAs" n'exposent pas toutes les pages via des liens statiques traditionnels, rendant le "crawling" plus complexe.

Beaucoup de pages ne sont accessibles qu'à travers la navigation interne côté client, que les robots de recherche peuvent ne pas suivre.

Même les robots d'exploration modernes comme Googlebot rendent JavaScript avec des retards et un temps de traitement limité. Les pages qui nécessitent plusieurs cycles de rendu ou une récupération de données imbriquée peuvent dépasser le budget d'exploration.

Les "vues importantes" peuvent être complètement [manquées], affaiblissant la visibilité du site dans les résultats de recherche.

3. Gestion Dynamique des Métadonnées

Chaque vue dans une SPA manque de métadonnées uniques à moins d'être configurée manuellement.

Sans mises à jour dynamiques des titres, descriptions et balises canoniques, toutes les URL apparaissent identiques aux moteurs de recherche.

Cela entraîne des erreurs d'indexation, une pertinence réduite et des taux de clics inférieurs.

Les "métadonnées" liées aux changements d'URL doivent être injectées en temps réel en utilisant des bibliothèques ou une logique personnalisée. Le non-respect de cette gestion empêche l'application de se classer correctement dans les différentes [requêtes] de recherche.

4. Structures d'URL "non standards"

Les SPAs peuvent utiliser des URL qui dépendent de fragments de hachage ou de la manipulation de l'historique du navigateur. Ces formats peuvent causer de la confusion pour les moteurs de recherche qui préfèrent des chemins "propres" et canoniques.

Si un itinéraire manque d'une structure appropriée, il peut ne pas être indexé ou peut être traité comme un doublon.

Les URL "incohérentes" brisent également le "deep linking", qui est essentiel pour la navigation des utilisateurs et la profondeur d'exploration.

Les performances du SEO souffrent lorsque les robots ne peuvent pas interpréter ou accéder à de véritables URL distinctes.

5. Codes d'état HTTP incorrects

Contrairement aux sites traditionnels, les SPA répondent avec 200 OK même pour les routes inexistantes.

Cela induit en erreur les moteurs de recherche en indexant des pages d'erreur ou du contenu non pertinent.

Sans les codes corrects comme 404 [Non trouvé] ou 301 [Redirection], les "crawlers" ne peuvent pas supprimer les pages obsolètes ou suivre de nouveaux chemins.

Les "bots" nécessitent des signaux de statut précis pour interpréter la structure du site et les changements de contenu.

Les "SPAs" qui [gèrent mal] ces [réponses] perdent le contrôle sur la façon dont leur contenu apparaît dans les résultats de recherche.

6. Pas de rechargement de page pendant la navigation

Dans les SPAs, les changements de route se produisent dans le navigateur sans recharger la page. Cela empêche les moteurs de recherche de reconnaître les événements de navigation comme de nouvelles pages.

Les "bots" peuvent supposer que l'utilisateur est toujours sur la même page, ce qui limite l'indexation de nouvelles vues.

Contrairement aux sites multi-pages, les SPA doivent simuler ces transitions pour que les outils de SEO puissent les détecter. Sans cela, le contenu spécifique à la "route" est ignoré ou mal classé.

7. Rendu [retardé] du contenu

Les "SPAs" [retardent] le contenu visible en raison de multiples dépendances JavaScript et du chargement asynchrone.

En raison de cela, les robots d'exploration des moteurs de recherche peuvent traiter la page avant que les données "essentielles" n'apparaissent.

Les "temps de rendu" longs peuvent entraîner une indexation partielle, des "titres manquants", et des résumés de page incomplets.

Si le contenu significatif n'est pas prêt lors de l'exploration, les moteurs de recherche supposent que la page manque de valeur ou peuvent considérer la page comme du "contenu mince."

Cela réduit finalement les "classements", la "visibilité" et le "trafic".

Conclusion

Obtenir le SEO correct pour les "applications à page unique" n'est pas simple.

Les moteurs de recherche doivent voir le contenu réel immédiatement, sans attendre que les scripts le chargent après coup. Par conséquent, vous devez envoyer un HTML correct, traiter chaque route comme une [vraie] page et mettre à jour les titres et descriptions au fur et à mesure que l'utilisateur navigue dans l'application.

Vous devez également gérer les codes d'état, créer des liens internes, ajouter des données structurées et vous assurer que les moteurs de recherche peuvent explorer chaque partie du site. Lorsque tout est en place, votre application à page unique devient plus facile à indexer et plus facile à classer.