Far scoprire la tua applicazione a pagina singola (SPA) dai motori di ricerca non è un'impresa facile. La SEO per le applicazioni a pagina singola aiuta le tue applicazioni web ad ottenere più visualizzazioni organiche.

I siti web basati su HTML sono più facili da accedere, scansionare e indicizzare perché forniscono un markup strutturato per i crawler.

Pertanto, avere il proprio contenuto in pagine HTML può portare a migliori classifiche di ricerca e sono più facili da ottimizzare rispetto alle applicazioni a pagina singola.

Le SPAs si basano fortemente su JavaScript per riscrivere dinamicamente il contenuto in base alle azioni del visitatore sul sito (pensa a "testo espandibile" o "finestre pop-up").

Pertanto, rende difficile per i Googlebot indicizzare il contenuto della pagina in quanto non esegue contenuti JavaScript lato client.

In questo articolo, discuterò le vere sfide dell'utilizzo delle SPA e condividerò il processo completo di fare SEO per le app a pagina singola per ottenere migliori posizionamenti nei motori di ricerca.

Conclusioni Chiave

- La SEO per le applicazioni a pagina singola è essenziale perché le SPA guidate da JavaScript spesso nascondono i contenuti chiave ai crawler.

- Utilizza il rendering lato server (SSR) o il pre-rendering per fornire ai crawler versioni HTML completamente renderizzate delle tue pagine.

- Titoli dinamici, meta descrizioni e tag canonici sono cruciali per la SEO delle applicazioni a pagina singola per prevenire contenuti duplicati e mantenere la rilevanza attraverso le rotte.

- Combina link interni, URL puliti, sitemap XML e codici di stato HTTP corretti per aiutare i motori di ricerca a scoprire e indicizzare tutte le rotte chiave all'interno della tua SPA.

Cos'è la SEO per le Single Page Applications (SPA)?

L'ottimizzazione per i motori di ricerca per le applicazioni a pagina singola si riferisce al processo di rendere le SPA, costruite con framework JavaScript come React.js, Angular.js o Vue.js, accessibili e indicizzabili dai motori di ricerca.

SEO per applicazioni a pagina singola include:

- Rendering lato server o "pre-rendering"

- Ottimizzazione di tag del titolo, meta descrizioni e dati strutturati

- Ottimizzazione di URL e tag canonici

- Ottimizzazione del collegamento interno

- Creazione e invio della mappa del sito

- "Link building"

Google, Bing, Baidu, DuckDuckGo e altri motori di ricerca trovano difficile eseguire la scansione e indicizzare il contenuto JavaScript poiché le SPA "caricano contenuti dinamicamente" sul lato client.

Pertanto, "SPA SEO" consiste in strategie e migliori pratiche per migliorare la reperibilità e la presenza sul web delle "single page apps" nei motori di ricerca.

Esempi di "Single Page Applications"

Ecco i principali esempi di SPA:

Gmail

Gmail è un esempio da manuale di una SPA. Quando accedi, l'intera interfaccia utente, inclusi la tua "posta in arrivo", le "cartelle" e la "chat", viene caricata una volta sola.

Da quel momento in poi, consultare le email, aprire i thread o comporre nuovi messaggi non richiede un ricaricamento completo della pagina.

JavaScript gestisce il routing e i cambiamenti di contenuto dietro le quinte, rendendo l'esperienza veloce e senza interruzioni.

Google utilizza richieste asincrone per recuperare solo i dati richiesti, riducendo la latenza e migliorando l'esperienza utente.

Google Maps

Google Maps offre ricche funzionalità interattive come lo "scorrimento", lo "zoom" e la [ricerca] di [posizioni], tutto all'interno della stessa pagina.

Non si ricarica quando richiedi nuove "indicazioni" o [passi] dalla vista satellitare a quella della mappa.

Invece, i dati vengono recuperati tramite AJAX e le tessere della mappa o i componenti dell'interfaccia utente si aggiornano dinamicamente. Questo fa sì che Google Maps sembri estremamente reattivo e utilizzabile, anche su connessioni più lente.

Anche se non al 100% SPA, ampie porzioni di Facebook utilizzano l'architettura SPA.

Quando gli utenti scorrono il loro feed di notizie, aprono post, reagiscono o commentano, tutti gli aggiornamenti avvengono senza un ricaricamento della pagina.

Anche quando si passa tra pagine come Messaggi, Notifiche e Marketplace, il sito utilizza il routing lato client con framework JavaScript (come React) per rendere dinamicamente i contenuti, il che riduce le chiamate al server e migliora la velocità di caricamento.

Netflix

L'interfaccia web di Netflix è un'altra SPA di alto profilo. Mentre navighi tra i suggerimenti di film o programmi TV, i trailer si riproducono automaticamente e i dettagli dei contenuti appaiono immediatamente senza ricaricare.

Cliccare un titolo apre una sovrapposizione modale o una nuova vista mantenendo intatta l'interfaccia principale.

Il "routing", le "raccomandazioni" e le modifiche al profilo utente sono gestiti da JavaScript, offrendo un'esperienza coerente con tempi di attesa ridotti.

Una "Single Page Application" è buona per la SEO?

Sì, una "single page application" è buona per la SEO se conosci i giusti suggerimenti di ottimizzazione per le SPA.

I motori di ricerca come Google possono eseguire il rendering di JavaScript, ma potrebbero ritardare la scansione o saltare i contenuti che richiedono l'interazione dell'utente.

Per evitare ciò, puoi utilizzare il rendering lato server, la generazione di siti statici, il routing degli URL puliti e gli aggiornamenti dinamici dei metadati.

Strumenti come Next.js, Nuxt.js, React Helmet e Vue Meta aiutano a fare tutto questo lavoro.

Con la giusta configurazione, una SPA può posizionarsi altrettanto bene di qualsiasi sito tradizionale. Tuttavia, senza adeguate regolazioni SEO, i motori di ricerca potrebbero perdere molto di ciò che hai costruito.

Letture Correlate: Come Eseguire SEO per Contenuti Dinamici

Come fare SEO per le "Single Page Applications"

Ecco le migliori soluzioni SEO per le applicazioni web a pagina singola:

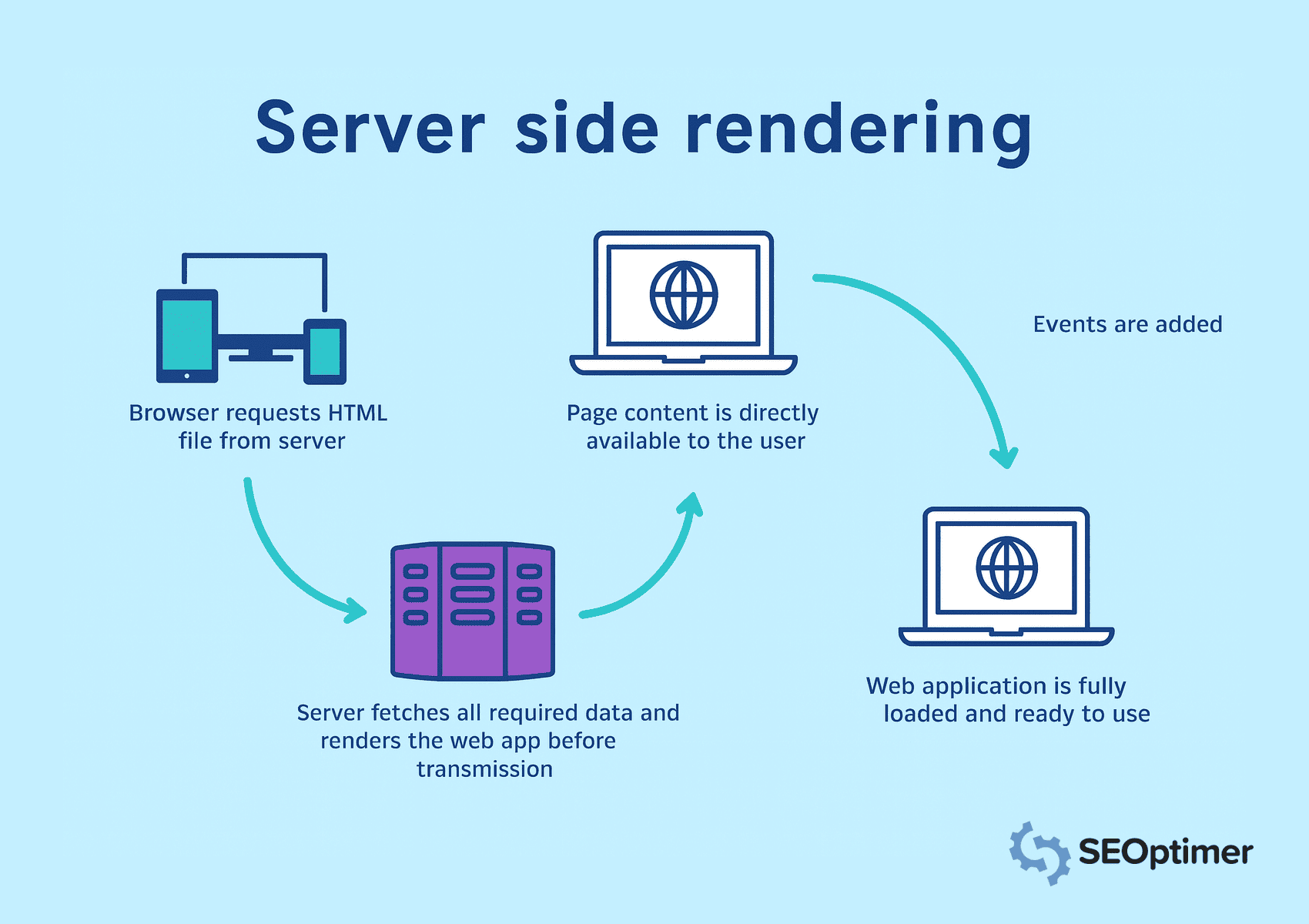

Utilizzare il "Server-Side Rendering" (SSR)

Le "single page applications" si basano su JavaScript per caricare i contenuti in modo dinamico.

Tuttavia, i motori di ricerca si aspettano HTML completo del server nella risposta HTTP per accedere, [esplorare] e indicizzare il contenuto.

Pertanto, dovresti implementare il rendering lato server per "renderizzare" le pagine sul server prima di inviarle al browser.

In "rendering lato server", il browser richiede file HTML, e il server recupera tutti i dati. Garantisce che tutto il contenuto sia immediatamente visibile e "indicizzabile".

Memorizza nella cache le pagine consultate frequentemente per ridurre i tempi di caricamento e fornire contenuti più rapidamente. Evita il rendering lato client per gli elementi chiave, poiché i motori di ricerca potrebbero non riuscire a elaborare le visualizzazioni pesanti in JavaScript.

Implementare il Pre-Rendering per le Rotte Statiche

Dovresti pre-renderizzare le rotte che mostrano lo stesso contenuto a ogni visitatore. Ti permette di generare HTML al momento della build e rimuove la necessità di rendering a runtime.

Di conseguenza, i motori di ricerca possono accedere alla pagina istantaneamente.

Gli strumenti di generazione statica dei framework come Next.js o Nuxt.js possono aiutarti a creare file statici per rotte come "pagine di destinazione", "blog" o "panoramiche dei prodotti".

Dovresti servire queste pagine pre-renderizzate attraverso una Content Delivery Network o un server web per migliorare la velocità di caricamento e la visibilità. Evita di applicare il pre-rendering alle visualizzazioni con dati "in tempo reale" o specifici per l'utente.

Aggiungi un output in "HyperText Markup Language" pulito e navigabile

Dovresti generare un output di HyperText Markup Language ben strutturato che i motori di ricerca possano interpretare facilmente.

Il markup "pulito" aiuta i bot a comprendere il layout della pagina, la gerarchia e gli elementi chiave senza fare affidamento sull'esecuzione di JavaScript.

Evita di iniettare contenuti dinamicamente dopo il caricamento della pagina. Invece, assicurati che il testo importante, intestazioni e link compaiano direttamente nel codice sorgente.

Quando lavori su SEO per una "single page app" la cosa più importante da ricordare è che Google non vede sempre la tua pagina come fanno le persone. Poiché caricano contenuti con JavaScript, a volte il crawler ottiene solo una pagina vuota. Quindi assicurati che quello che vuoi che Google legga compaia effettivamente nell'html.

- Ciara Edmondson, SEO & "Content Manager" presso Max Web Solutions

Usa tag semantici come <header>, <main>, <article> e <footer> per fornire una struttura chiara.

Dovresti anche ridurre al minimo gli stili inline e il disordine degli script che potrebbero oscurare i contenuti significativi.

Mantieni il documento leggibile e leggero per una scansione più veloce e un'indicizzazione migliore.

Usa il rendering lato server o il pre-rendering per produrre HTML statico per ogni percorso. Garantisce che i crawler accedano al contenuto completo della pagina nella richiesta iniziale.

Esporre "Istantanee Statiche" per i "Crawler"

Si dovrebbe esporre "istantanee statiche" per garantire che i crawler possano accedere al contenuto completo, specialmente quando il rendering lato client ritarda l'output della pagina.

Un'istantanea statica è una versione completamente renderizzata della pagina generata in anticipo e servita specificamente ai bot.

Questa tattica è utile quando il rendering lato server o il pre-rendering non è fattibile in tutta l'applicazione.

I "snapshot" forniscono un percorso alternativo per i crawler per accedere al linguaggio di markup ipertestuale strutturato senza eseguire JavaScript.

Si dovrebbe configurare il server per rilevare agenti utente come Googlebot e servire istantanee pre-costruite per quelle richieste.

Strumenti come Rendertron, Prerender.io o renderer NodeJS senza testa personalizzati possono aiutare a generare e consegnare [istantanee] in modo affidabile.

Assicurati che ogni istantanea rifletta il contenuto e la struttura completi della pagina, inclusi titoli, metadati, link e markup schema.

Safira di Somar Digital, un'agenzia con sede in Nuova Zelanda, raccomanda che tutte le "SPA" dovrebbero utilizzare il "schema markup" per la loro SEO.

Consiglio di utilizzare il markup schema dei dati strutturati per le SPA. Integrare marcatori di schema rilevanti come "organizzazione", "pagina web", "elenco breadcrumb", "FAQ", ecc.

Ho notato che a volte il markup dello schema potrebbe non apparire nel codice sorgente o anche nel Test dei Risultati Ricchi di Google, ma se si testa lo schema utilizzando il validatore di markup dello schema, si vedranno i markup dello schema aggiunti nei risultati. Questo accade perché le SPA che iniettano lo Schema (tramite JavaScript) non lo hanno disponibile al caricamento iniziale. Ma Google è in grado di leggere il JavaScript poiché è senza testa.

- Safira Mumtaz, Specialista SEO/SEM presso Somar Digital

Dovresti anche monitorare la copertura dell'indice per confermare che i crawler stiano elaborando gli snapshot come previsto.

Servire "istantanee statiche" migliora la visibilità per pagine con logica di rendering complessa, aiutando a mantenere un "indicizzazione" e un valore SEO coerenti.

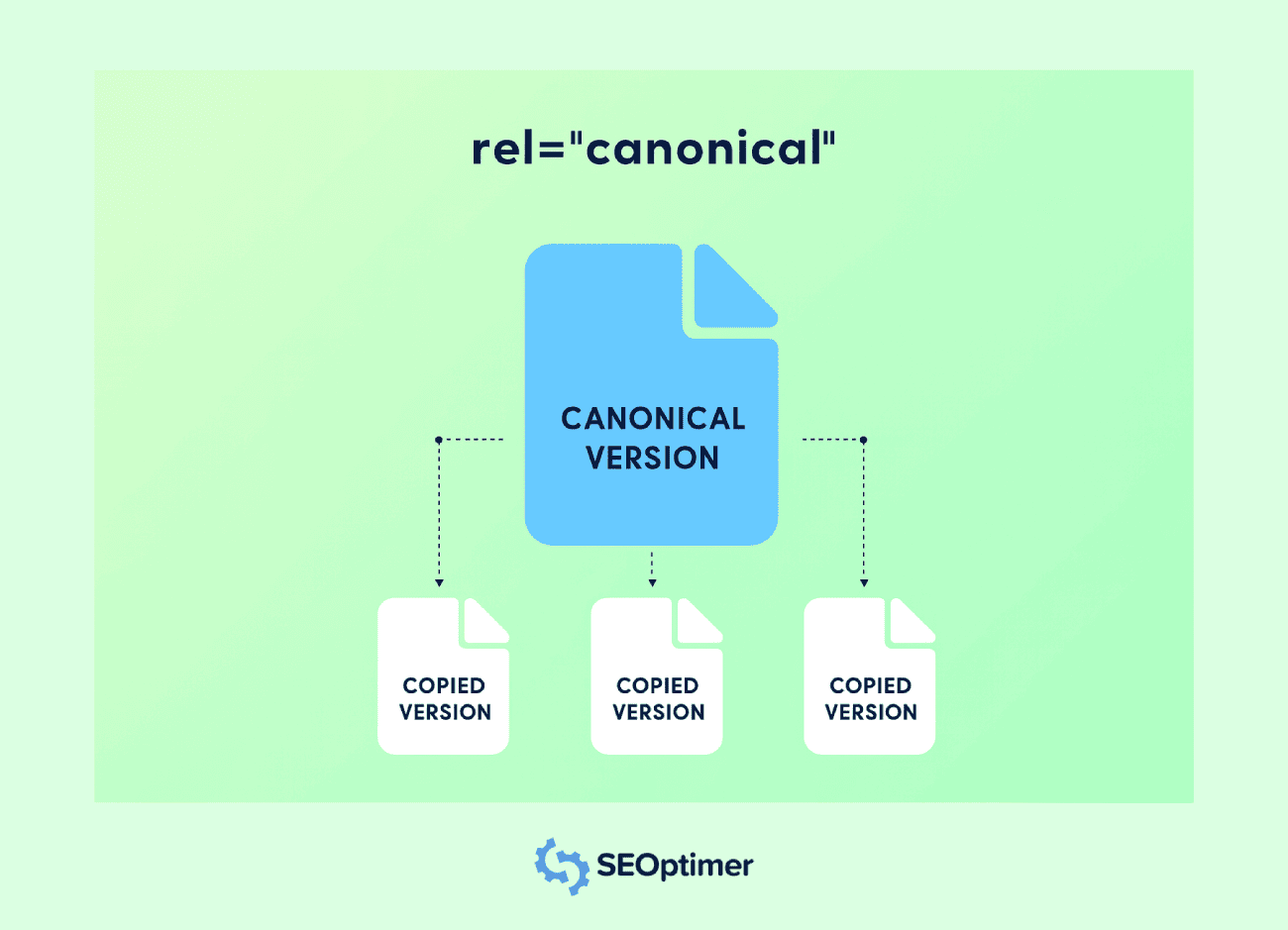

Imposta i tag canonici per ogni vista

Dovresti impostare un tag canonico per ogni percorso in un'applicazione a pagina singola per evitare problemi di contenuti duplicati.

La maggior parte delle volte, le SPA genereranno più URL accessibili per lo stesso contenuto.

Ad esempio, lo stesso contenuto può essere presente in URL con diverse stringhe di query, filtri o parametri di tracciamento. I tag canonici aiutano i motori di ricerca a comprendere la versione preferita.

Ogni percorso dovrebbe includere un tag <link rel="canonical"> che punta all'URL originale per quella vista. Previene la diluizione dell'equità dei link tra diversi URL con lo stesso contenuto.

Dovresti iniettare i tag canonici dinamicamente quando il percorso cambia, specialmente se l'applicazione aggiorna i metadati sul lato client.

Usa "routing hooks" o funzioni "middleware" per assegnare il tag corretto a ogni transizione di pagina.

Evita di puntare tutte le rotte alla homepage o di utilizzare un valore canonico statico. Ogni vista unica dovrebbe riflettere il proprio URL logico per preservare la rilevanza e l'accuratezza dell'indice.

L'implementazione della corretta "canonicalizzazione" supporta un'indicizzazione più chiara, migliora l'autorità della pagina e previene la duplicazione indesiderata nei risultati di ricerca.

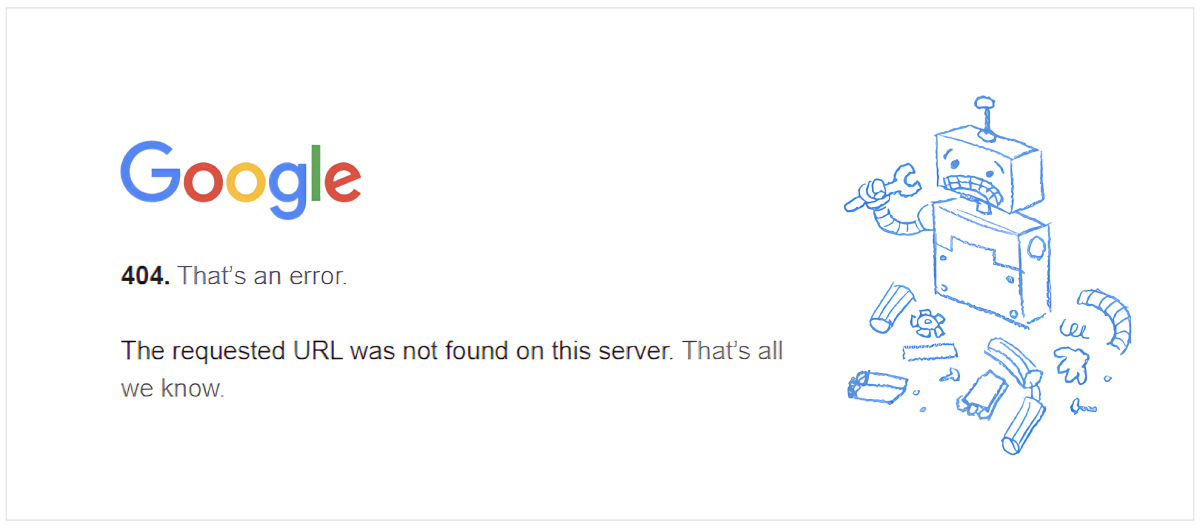

Gestire correttamente i codici di stato 404 e altri

Dovresti configurare codici di stato accurati per tutte le viste in un'applicazione a pagina singola per aiutare i motori di ricerca a interpretare correttamente la struttura del tuo sito.

Molte SPA servono un guscio HTML predefinito per ogni richiesta, il quale può restituire un 200 OK anche per [percorsi] inesistenti.

Una corretta risposta 404 Not Found dovrebbe essere restituita per URL non validi.

Utilizzare la logica del server o il middleware in NodeJS per rilevare le rotte non corrispondenti e inviare il codice di stato corretto insieme a una pagina di errore personalizzata.

Dovresti anche gestire altre risposte come 301 o 302 per il reindirizzamento e 500 per errori del server.

Questi codici di stato informano i motori di ricerca su come trattare ogni richiesta e mantenere l'integrità della tua copertura di scansione e indicizzazione.

Evita di fare affidamento esclusivamente sulla gestione degli errori lato client. I crawler potrebbero non eseguire JavaScript, quindi risposte di stato errate possono danneggiare i segnali di ottimizzazione per i motori di ricerca e fuorviare l'indicizzazione.

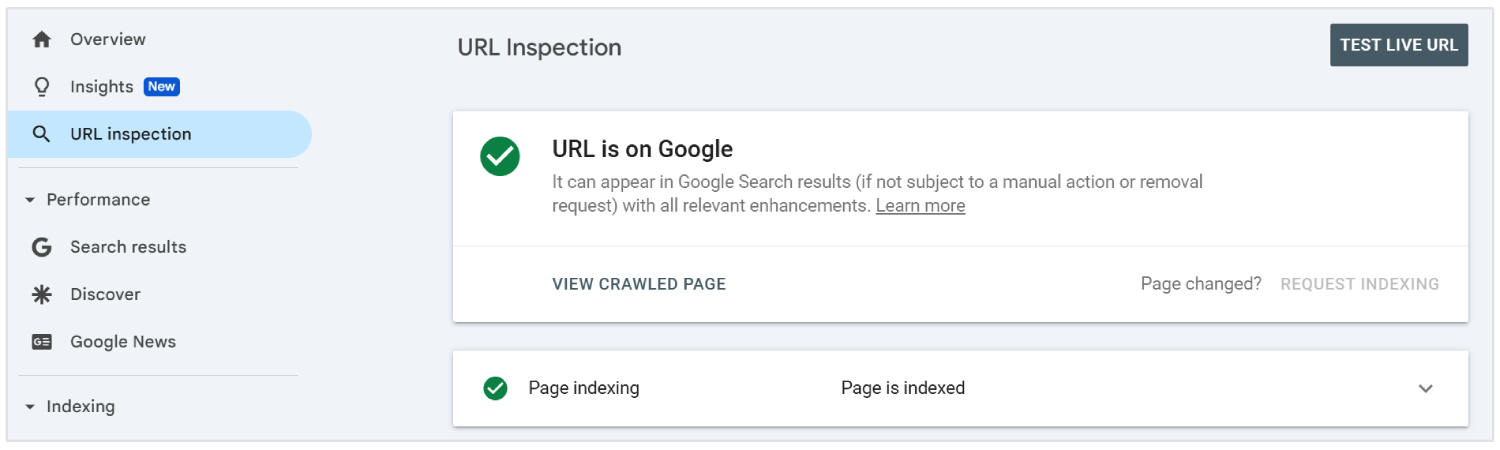

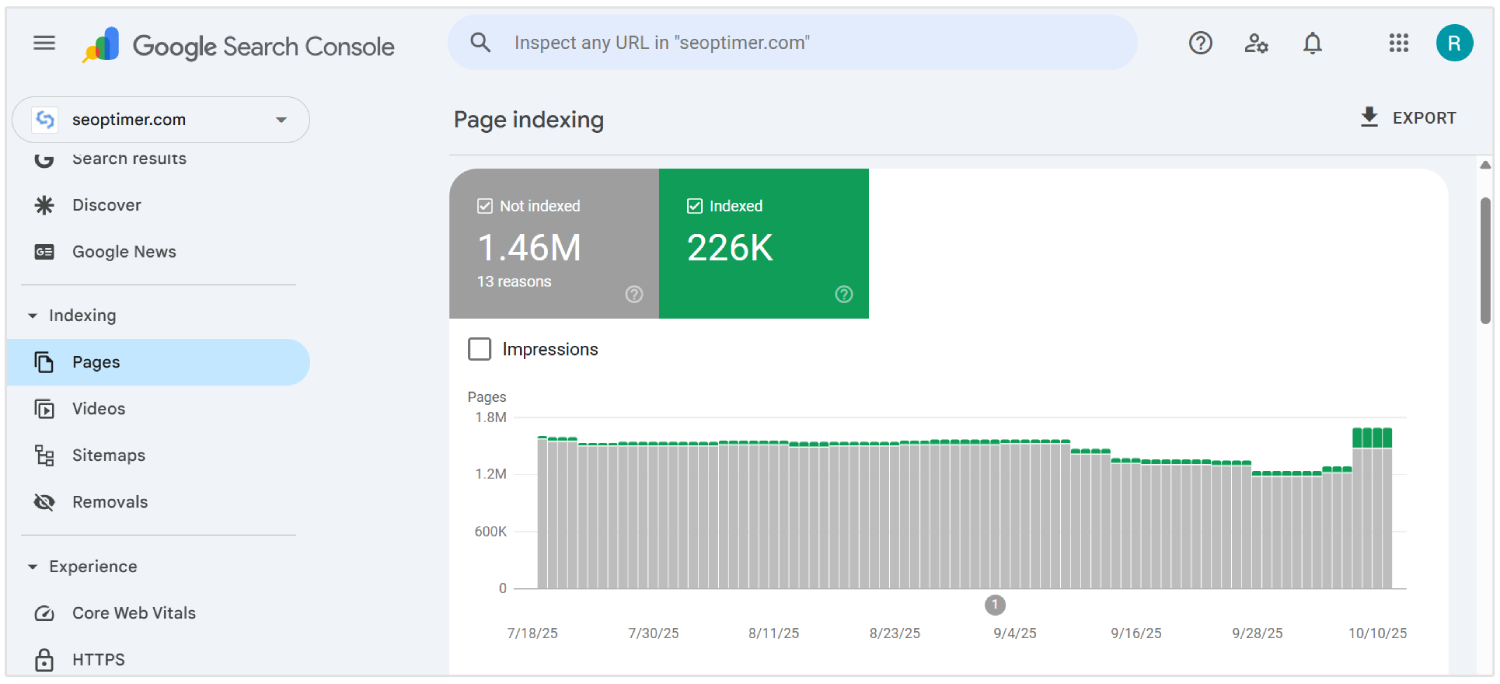

Invia URL dinamici a Google Search Console

È necessario inviare tutti gli URL dinamici importanti da un'applicazione a pagina singola a Google Search Console utilizzando lo Strumento di Ispezione degli URL. Aiuta i bot dei motori di ricerca a scoprire e indicizzare contenuti che potrebbero non apparire in una scansione tradizionale.

Poiché le SPAs caricano contenuti tramite il routing lato client, alcune pagine interne potrebbero non essere trovate dai crawler senza collegamenti diretti.

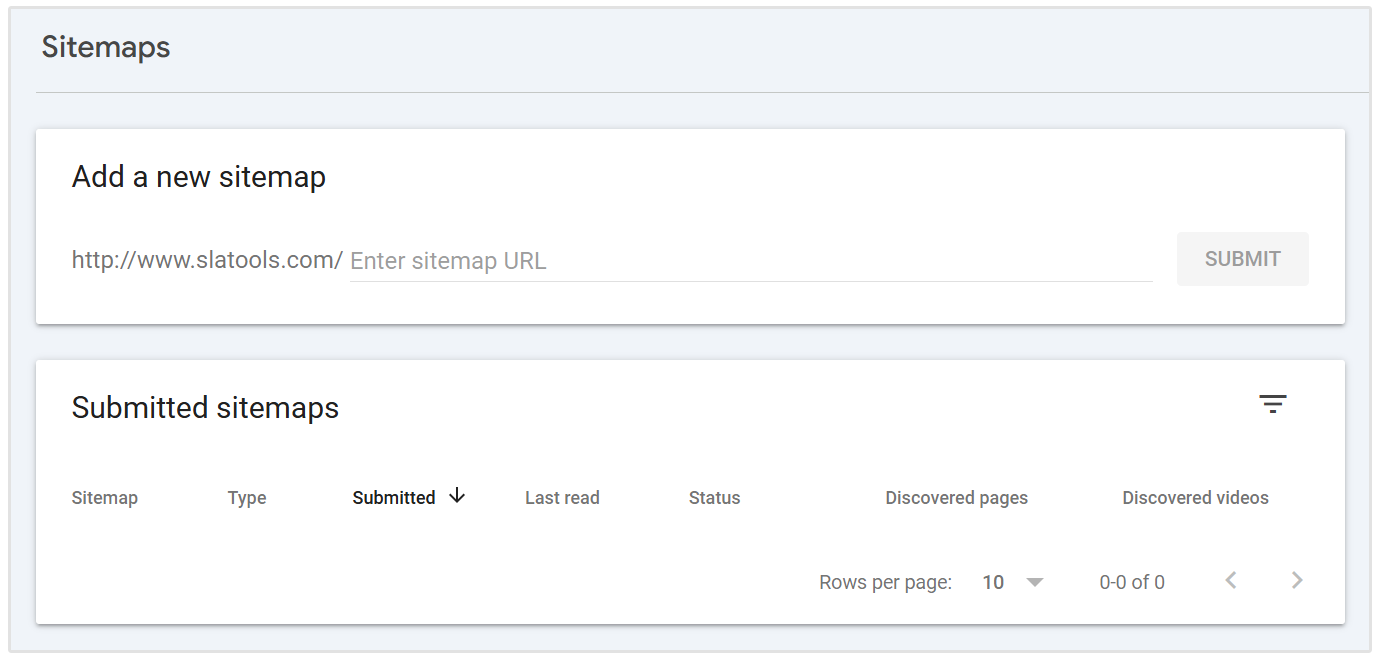

Per garantire la visibilità, elenca questi URL in una sitemap XML e inviala tramite l'interfaccia della console.

Dovresti aggiornare la mappa del sito ogni volta che vengono aggiunti o modificati nuovi percorsi. Ogni voce deve riflettere l'URL finale e pulito che gli utenti e i crawler vedono, escludendo [hash] o parametri non necessari.

Inviare URL dinamici offre a Google una mappa chiara della struttura della tua applicazione e migliora le possibilità di una scansione accurata e un'indicizzazione più rapida.

Abilita il "Lazy Loading" con [Fallbacks]

Dovresti abilitare il lazy loading per migliorare le prestazioni nelle SPA posticipando il caricamento di elementi non essenziali come "immagini", "video" o sezioni [sotto la piega].

Aiuta a ridurre il tempo di caricamento iniziale e migliora l'esperienza utente su visualizzazioni desktop e mobile.

I motori di ricerca potrebbero non attivare il contenuto che si carica tramite JavaScript, il che può portare a un'indicizzazione mancata.

Dovresti fornire alternative come contenuto "segnaposto" o tag <noscript> per garantire che tutti gli elementi chiave rimangano visibili ai crawler.

Usa le funzionalità native del browser come l'attributo loading="lazy" o gestisci il caricamento basato sullo scroll tramite JavaScript. Dovresti sempre confermare la visibilità utilizzando strumenti come Google Search Console.

Evita di ritardare contenuti importanti o collegamenti che contribuiscono alla visibilità sui motori di ricerca. L'uso corretto del "lazy loading" con fallback affidabili supporta una velocità di caricamento più rapida e una copertura completa dei contenuti.

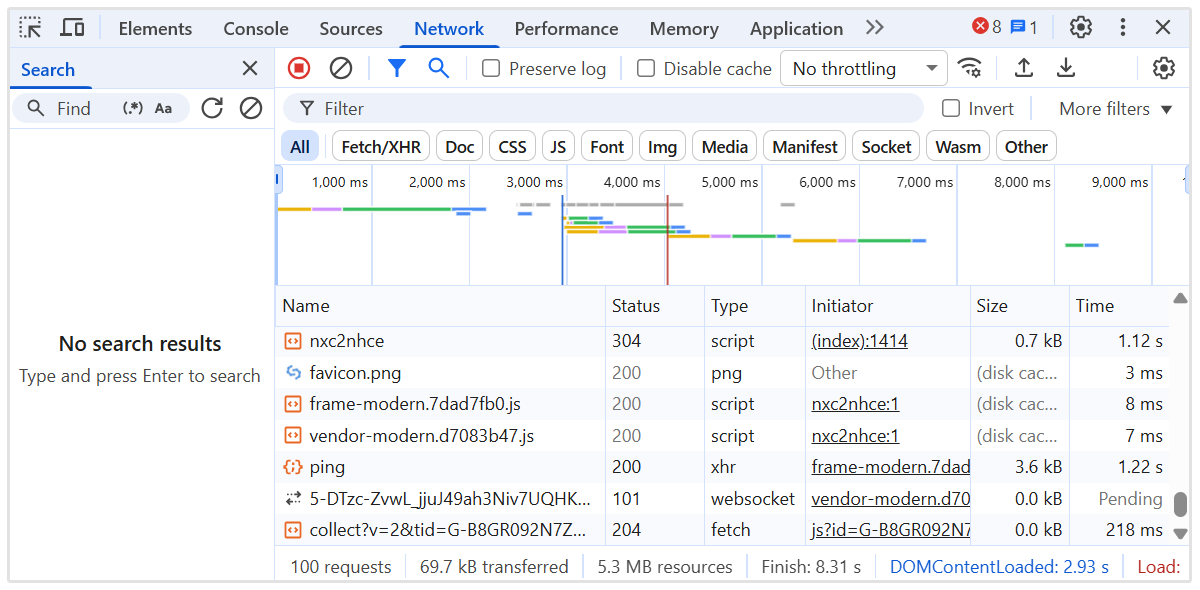

Rimanda JavaScript Non-Critico

Dovresti rinviare il JavaScript non critico per velocizzare il rendering iniziale della pagina e ridurre il blocco del contenuto importante nelle applicazioni a pagina singola.

Gli script che non sono essenziali per il contenuto "above-the-fold" possono ritardare sia l'interazione dell'utente che la visibilità del crawler.

Utilizzare gli attributi defer o async nei tag script per prevenire un'esecuzione non necessaria durante il primo caricamento della pagina.

Posiziona gli script "non essenziali" alla fine del documento o caricali dopo che il contenuto "principale" è stato reso.

Si dovrebbe identificare quali script influenzano il layout, i metadati o la logica di instradamento e separarli da "analytics", "chat widgets" o "animations".

Strumenti come Lighthouse e Chrome DevTools possono aiutare a verificare il comportamento degli script e la sequenza di caricamento.

Implementare il Collegamento Interno tra le Rotte SPA

Dovresti creare una chiara struttura di collegamenti interni tra tutte le rotte in un'applicazione a pagina singola per guidare i crawler attraverso il sito.

A differenza dei siti web tradizionali, le SPA si basano sulla navigazione lato client, che può impedire ai motori di ricerca di scoprire tutte le pagine interne se i link non vengono aggiunti correttamente.

Usa tag di ancoraggio con attributi href appropriati che riflettono il percorso effettivo, non solo funzioni JavaScript o pulsanti. Evita di utilizzare elementi come gestori onClick senza URL significativi, poiché questi sono ignorati dai crawler (la maggior parte delle volte).

Si dovrebbe garantire che ogni pagina importante sia collegata da altre parti dell'applicazione, specialmente dalla homepage e dalle pagine di alta autorità. Aiuta a trasmettere segnali di rilevanza e autorità per un'efficiente scansione.

Mantieni una gerarchia logica con menu di navigazione, breadcrumb e collegamenti contestuali tra viste correlate. Usa testo di ancoraggio descrittivo per rafforzare gli argomenti delle pagine.

Il "collegamento interno" migliora la profondità di scansione, distribuisce l'autorità e rafforza le prestazioni complessive di "ottimizzazione per i motori di ricerca" in tutta l'applicazione.

Utilizzare una mappa del sito che rifletta tutte le "rotte" importanti

Dovresti generare e inviare una sitemap che includa ogni "route" importante nell'applicazione a pagina singola.

Poiché le SPA utilizzano il routing lato client, molte viste interne potrebbero non essere individuabili tramite la scansione tradizionale.

Crea una sitemap XML che elenchi tutti i percorsi statici e dinamici destinati all'indicizzazione. Includi solo URL puliti e canonici senza parametri, frammenti o dati di sessione non necessari.

Si dovrebbe aggiornare la mappa del sito ogni volta che nuove rotte vengono aggiunte, rimosse o modificate. Gli strumenti di automazione possono rigenerare la mappa del sito durante ogni distribuzione per mantenerla accurata.

Invia la "sitemap" in Google Search Console per aiutare i motori di ricerca a trovare e dare priorità ai contenuti chiave. Questo supporta una copertura completa dell'indice e rafforza la visibilità a livello di percorso.

Una "sitemap" ben mantenuta migliora l'efficienza di scansione e garantisce che le visualizzazioni critiche ricevano l'attenzione di cui hanno bisogno.

Monitora il Comportamento di Scansione con i Log del Server

Dovresti analizzare i log del server per capire come i motori di ricerca interagiscono con la tua [Single Page Application].

I registri rivelano quali percorsi vengono scansionati, con quale frequenza vengono accessi e se i bot incontrano errori o ritardi.

Rivedi i codici di stato HTTP, gli user agent e i timestamp per rilevare "lacune" di indicizzazione o "inefficienze" di scansione.

Cerca segni di contenuti "mancati", accessi ripetuti su pagine irrilevanti, o risposte non riuscite che potrebbero danneggiare la visibilità.

Dovresti monitorare come Googlebot naviga attraverso i percorsi dinamici e verificare che le "viste" importanti ricevano attenzione di scansione. Combina i dati di log con le informazioni da strumenti come Google Search Console per verificare la copertura dell'indicizzazione.

Usa strumenti di analisi dei log del server o esporta i dati dal tuo ambiente server NodeJS per una [visibilità] più approfondita.

Monitorare l'attività dei bot in tempo reale aiuta a identificare lo "spreco di scansione", risolvere i problemi di "scopribilità" e ottimizzare le prestazioni complessive della SEO delle SPA.

Risolvere i problemi di rendering con contenuti dinamici

Si dovrebbe risolvere i problemi di rendering nelle applicazioni a pagina singola per garantire che il contenuto dinamico sia completamente visibile ai motori di ricerca.

Il contenuto che dipende dall'esecuzione di JavaScript potrebbe non apparire durante la scansione se viene caricato troppo tardi o richiede l'interazione dell'utente.

Verifica ogni percorso per confermare che il "testo importante", i "link" e le "intestazioni" siano disponibili nel risultato reso. Utilizza strumenti come Google’s URL Inspection Tool o Lighthouse per rilevare contenuti mancanti dal rendering iniziale.

Dovresti applicare tecniche come il "server-side rendering" o il "pre-rendering" per fornire pagine completamente costruite dove necessario.

Per il rendering lato client, assicurati che i dati vengano caricati rapidamente e non dipendano da [trigger] ritardati.

Evita di iniettare informazioni "critiche" dopo che il crawler ha già elaborato la pagina. I ritardi nel rendering possono portare a un'indicizzazione parziale o all'esclusione dai risultati di ricerca.

Risolvere i problemi di rendering garantisce la completa visibilità dei contenuti chiave, supporta un migliore indicizzazione e rafforza i risultati complessivi dell'ottimizzazione per i motori di ricerca per le SPA.

Allinea l'esecuzione di JavaScript con le capacità del crawler

Dovresti strutturare l'esecuzione di JavaScript per adattarsi ai limiti di elaborazione dei crawler moderni, in particolare la coda di rendering e i vincoli di risorse di Googlebot.

I crawler operano con un budget di tempo per ogni URL. Pertanto, "catene di dipendenza" eccessive, "recupero dati asincrono" o logica di blocco del rendering possono portare a un'indicizzazione incompleta delle pagine chiave.

Dare priorità al rendering del contenuto del percorso critico durante la fase di "initial paint". Evitare livelli di idratazione nidificati, mutazioni DOM ritardate o uso eccessivo di componenti solo client.

Sostituisci l'iniezione di contenuti in fase di esecuzione con dati prefetchati dal server o layout scheletro dove l'HTML completo del server non è fattibile.

Dovresti controllare il tempo di esecuzione utilizzando strumenti come il pannello Prestazioni di Chrome DevTools e simulare le condizioni del "crawler" con Puppeteer o renderizzatori NodeJS senza testa.

Traccia il Tempo per l'interattività (TTI), Largest Contentful Paint (LCP) e il Tempo totale di blocco (TBT) in condizioni di "nessuna cache".

Assicurati che i metadati specifici per il percorso, i tag canonici e lo schema siano montati in modo sincrono. Riduci la dipendenza da librerie pesanti o framework di routing runtime che ritardano l'output di rendering significativo.

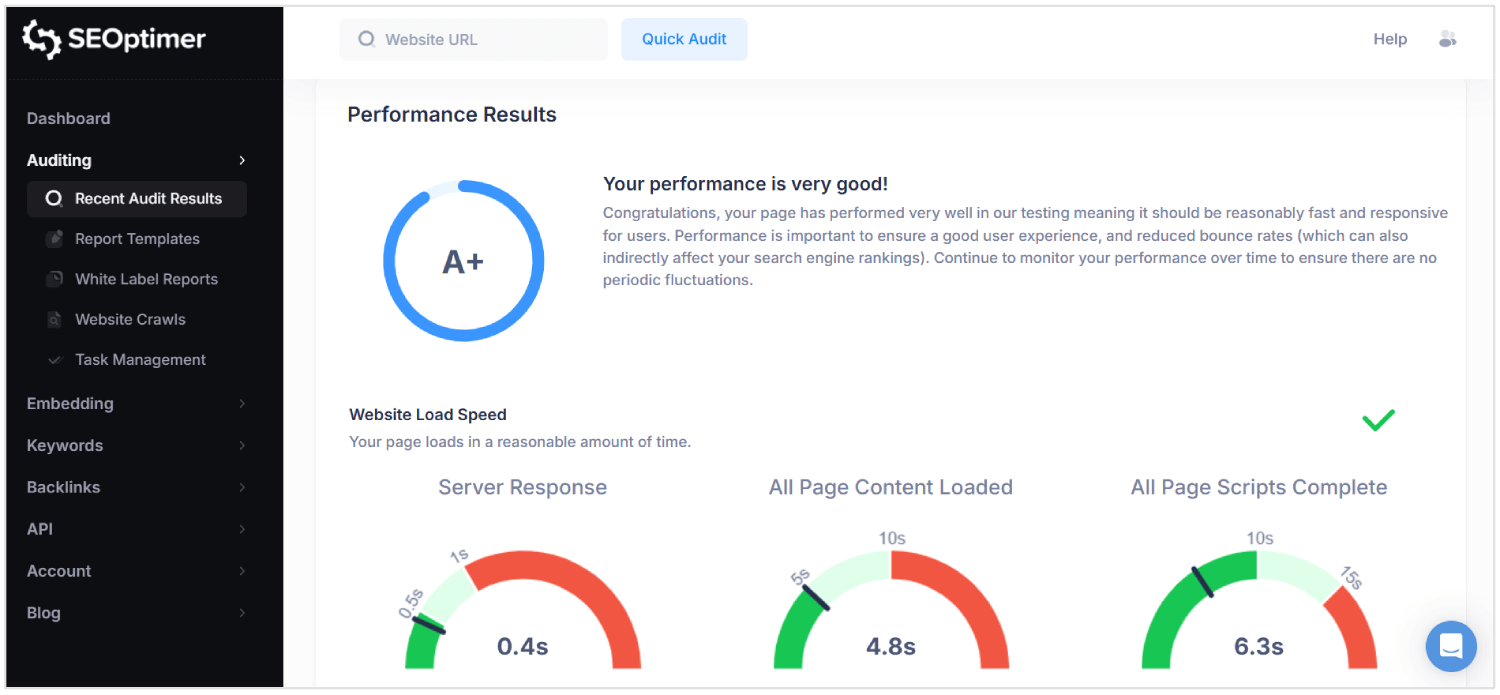

Verifica le Prestazioni SEO con Strumenti Specializzati

Dovresti controllare regolarmente le tue prestazioni di ottimizzazione per i motori di ricerca per rilevare problemi di visibilità nelle applicazioni a pagina singola.

I controlli standard basati su browser non rilevano problemi unici degli ambienti pesanti di JavaScript.

Utilizzando strumenti avanzati si ottiene una visibilità approfondita su come le pagine vengono renderizzate, indicizzate e valutate dai motori di ricerca.

SEOptimer è uno di questi strumenti che esegue audit completi su livelli tecnici, on-page e di prestazioni.

Scansiona ogni pagina per la qualità dei metadati, la reattività mobile, la struttura dei collegamenti interni e il rapporto contenuto-codice.

Per le SPA, SEOptimer aiuta a identificare elementi HyperText Markup Language mancanti, tag canonici configurati in modo errato e strutture di intestazione deboli che influenzano la "crawlability".

Dovresti eseguire gli audit di SEOptimer dopo aver implementato aggiornamenti importanti o lanciato nuove rotte. Lo strumento segnala ritardi di rendering, collegamenti interrotti e dipendenze JavaScript che impediscono il caricamento corretto del contenuto.

Combina SEOptimer con strumenti come Google Search Console e analizzatori di log per [validate] i risultati in condizioni reali di scansione.

Il "controllo" regolare assicura che la logica di "routing", la "content delivery" e i comportamenti di "rendering" supportino tutti una prestazione SEO sostenuta.

Perché la SEO è [sfidante] per le SPA

La "SEO" è difficile per le applicazioni a pagina singola perché i metadati, il contenuto specifico del percorso e i codici di stato corretti possono essere trascurati o fraintesi dai crawler.

Ecco le principali sfide SEO per le SPA:

1. Rendering Lato Client

I motori di ricerca si aspettano che il contenuto significativo sia presente nella risposta HTML iniziale. Le SPAs si affidano a JavaScript per "visualizzare" il contenuto dopo il caricamento della pagina, il che ritarda la visibilità.

Se un crawler accede alla pagina prima che il rendering sia completato, elementi chiave come "testo" e "link" potrebbero non essere elaborati. Questo crea un rischio che i motori di ricerca indicizzino pagine incomplete o vuote.

Di conseguenza, il contenuto che gli utenti possono vedere non raggiunge mai i risultati dei motori di ricerca.

2. Limitazioni del "Crawling"

Le SPA non espongono tutte le pagine attraverso collegamenti statici tradizionali, rendendo la scansione più complessa.

Molte pagine sono accessibili solo tramite la navigazione interna lato client, che i bot di ricerca potrebbero non seguire.

Anche i crawler moderni come Googlebot eseguono il rendering di JavaScript con ritardi e tempo di elaborazione limitato. Le pagine che richiedono più cicli di rendering o "nested data fetching" possono superare il budget di scansione.

Le "opinioni importanti" [possono] essere completamente perse, indebolendo la visibilità del sito nei risultati di ricerca.

3. Gestione Dinamica dei Metadati

Ogni vista in un SPA manca di metadati unici a meno che non sia configurata manualmente.

Senza aggiornamenti dinamici a titoli, descrizioni e tag canonici, tutti gli URL appaiono identici ai motori di ricerca.

Questo porta a errori di indicizzazione, ridotta rilevanza e tassi di clic inferiori.

I "metadata" legati ai cambiamenti degli URL devono essere iniettati in tempo reale utilizzando librerie o logica personalizzata. La mancata gestione di questo blocca l'applicazione dal posizionarsi correttamente tra le diverse [query] di ricerca.

4. Strutture URL "non standard"

Le SPA possono utilizzare URL che dipendono da frammenti di hash o dalla manipolazione della cronologia del browser. Questi formati possono causare confusione ai motori di ricerca che preferiscono percorsi "puliti" e canonici.

Se un percorso manca di una [struttura] adeguata, potrebbe non essere indicizzato o potrebbe essere trattato come un duplicato.

URL incoerenti interrompono anche il deep linking, che è fondamentale per la navigazione dell'utente e la profondità di scansione.

Le prestazioni SEO ne risentono quando i bot non possono interpretare o accedere a URL reali e distinti.

5. Codici di stato HTTP "errati"

A differenza dei siti tradizionali, le SPA rispondono con 200 OK anche per percorsi inesistenti.

Questo induce i motori di ricerca a indicizzare le pagine di errore o contenuti irrilevanti.

Senza i codici corretti come 404 Not Found o 301 Redirect, i crawler non possono rimuovere le pagine [obsolete] o seguire nuovi percorsi.

I "bot" richiedono segnali di stato accurati per interpretare la struttura del sito e le modifiche ai contenuti.

Le "SPA" che gestiscono male queste risposte perdono il controllo su come il loro contenuto appare nei risultati di ricerca.

6. Nessun Ricaricamento della Pagina Durante la Navigazione

Nei SPA, i cambiamenti di percorso avvengono all'interno del browser senza ricaricare la pagina. Questo impedisce ai motori di ricerca di riconoscere gli eventi di navigazione come nuove pagine.

I bot potrebbero presumere che l'utente sia ancora sulla stessa pagina, il che limita l'indicizzazione di nuove visualizzazioni.

A differenza dei siti multi-pagina, le SPA devono simulare queste transizioni affinché gli strumenti SEO le rilevino. Senza questo, il contenuto specifico del percorso viene trascurato o classificato erroneamente.

7. Rendering Ritardato del Contenuto

Le "SPAs" ritardano il contenuto visibile a causa di più dipendenze JavaScript e del caricamento asincrono.

A causa di ciò, i crawler dei motori di ricerca potrebbero elaborare la pagina prima che appaiano i dati essenziali.

I lunghi tempi di rendering possono portare a un'indicizzazione parziale, titoli mancanti e riassunti della pagina incompleti.

Se il contenuto significativo non è pronto durante la scansione, i motori di ricerca presumono che la pagina manchi di valore o potrebbero considerare la pagina come "contenuto scarso."

Ciò riduce alla fine i "rankings", la visibilità e il traffico.

Conclusione

Fare bene la SEO per le "single page applications" non è semplice.

I motori di ricerca devono vedere "contenuti" reali immediatamente, non aspettare che gli script li carichino dopo. Pertanto, dovresti inviare un corretto HTML, trattando ogni percorso come una vera pagina e aggiornando titoli e descrizioni mentre l'utente si sposta nell'app.

Devi anche gestire i codici di stato, costruire collegamenti interni, aggiungere dati strutturati e assicurarti che i motori di ricerca possano eseguire la scansione di ogni parte del sito. Quando tutto è al suo posto, la tua "single page application" diventa più facile da indicizzare e più facile da classificare.