Es ist keine leichte Aufgabe, Ihre Single-Page-App (SPA) von Suchmaschinen entdecken zu lassen. SEO für Single-Page-Anwendungen hilft Ihren Webanwendungen, mehr organische Aufrufe [zu erhalten].

HTML-basierte Websites sind leichter zugänglich, durchsuchbar und indexierbar, weil sie eine strukturierte Markierung für Crawler bereitstellen.

Daher kann das Vorhandensein Ihrer Inhalte in HTML-Seiten zu besseren Suchrankings führen, und sie sind leichter zu optimieren als "Single Page Apps".

SPAs verlassen sich stark auf JavaScript, um Inhalte dynamisch basierend auf den [Aktionen] eines Besuchers auf der [Website] neu zu schreiben (denken Sie an "erweiterbaren Text" oder "Pop-up-Boxen").

Daher wird es für Googlebots schwierig, den Inhalt der Seite zu indexieren, da sie keine clientseitigen JavaScript-Inhalte ausführen.

In diesem Artikel werde ich die echten Herausforderungen bei der Verwendung von SPAs [besprechen] und den vollständigen Prozess der Durchführung von SEO für [Single Page Apps] [teilen], um bessere Suchrankings zu erzielen.

Wichtige Erkenntnisse

- SEO für "Single Page Applications" ist wichtig, weil JavaScript-gesteuerte SPAs oft wichtige Inhalte vor Crawlern verbergen.

- Verwenden Sie "Server-Side Rendering (SSR)" oder "Pre-Rendering", um Crawlern vollständig gerenderte HTML-Versionen Ihrer Seiten bereitzustellen.

- Dynamische Titel, Meta-Beschreibungen und kanonische Tags sind entscheidend für die "Single Page Application SEO", um doppelte Inhalte zu verhindern und die Relevanz über Routen hinweg zu erhalten.

- Kombinieren Sie interne Links, saubere URLs, XML-Sitemaps und korrekte HTTP-Statuscodes, um Suchmaschinen dabei zu helfen, alle wichtigen Routen innerhalb Ihrer SPA zu entdecken und zu indexieren.

Was ist SEO für Single Page Applications (SPA)?

Suchmaschinenoptimierung für "Single Page Apps" bezieht sich auf den Prozess, SPAs, die mit JavaScript-Frameworks wie React.js, Angular.js oder Vue.js erstellt wurden, für Suchmaschinen zugänglich und indexierbar zu machen.

SEO für "Single Page Apps" [einschließen]:

- "Server-seitiges Rendering" oder "Pre-Rendering"

- "Title-Tags", "Meta-Beschreibungen" und [strukturierte] "Datenoptimierung"

- "URL"- und "Canonical-Tag-Optimierung"

- Interne [Link-Optimierung]

- Sitemap-Erstellung und -Einreichung

- [Linkaufbau]

Google, Bing, Baidu, DuckDuckGo, und andere Suchmaschinen finden es "herausfordernd", JavaScript-Inhalte zu durchsuchen und zu indexieren, da SPAs Inhalte dynamisch auf der Client-Seite laden.

Daher besteht SPA-SEO aus Strategien und bewährten Verfahren, um die Auffindbarkeit und Webpräsenz von "Single Page Apps" in Suchmaschinen zu verbessern.

Beispiele für "Single Page Applications"

Hier sind die besten Beispiele für SPAs:

Gmail

Gmail ist ein Lehrbuchbeispiel für eine SPA. Wenn Sie sich anmelden, wird die gesamte Benutzeroberfläche, einschließlich Ihres Posteingangs, Ihrer Ordner und des Chats, einmal geladen.

Von diesem Punkt an erfordert das Durchsuchen von E-Mails, das Öffnen von Threads oder das Verfassen neuer Nachrichten kein vollständiges Neuladen der Seite mehr.

JavaScript "verwalten" das Routing und die Inhaltsänderungen im Hintergrund, wodurch die "Erfahrung" schnell und nahtlos "wird".

Google verwendet asynchrone Anfragen, um nur die benötigten Daten abzurufen, wodurch die Latenzzeit verringert und die Benutzererfahrung verbessert wird.

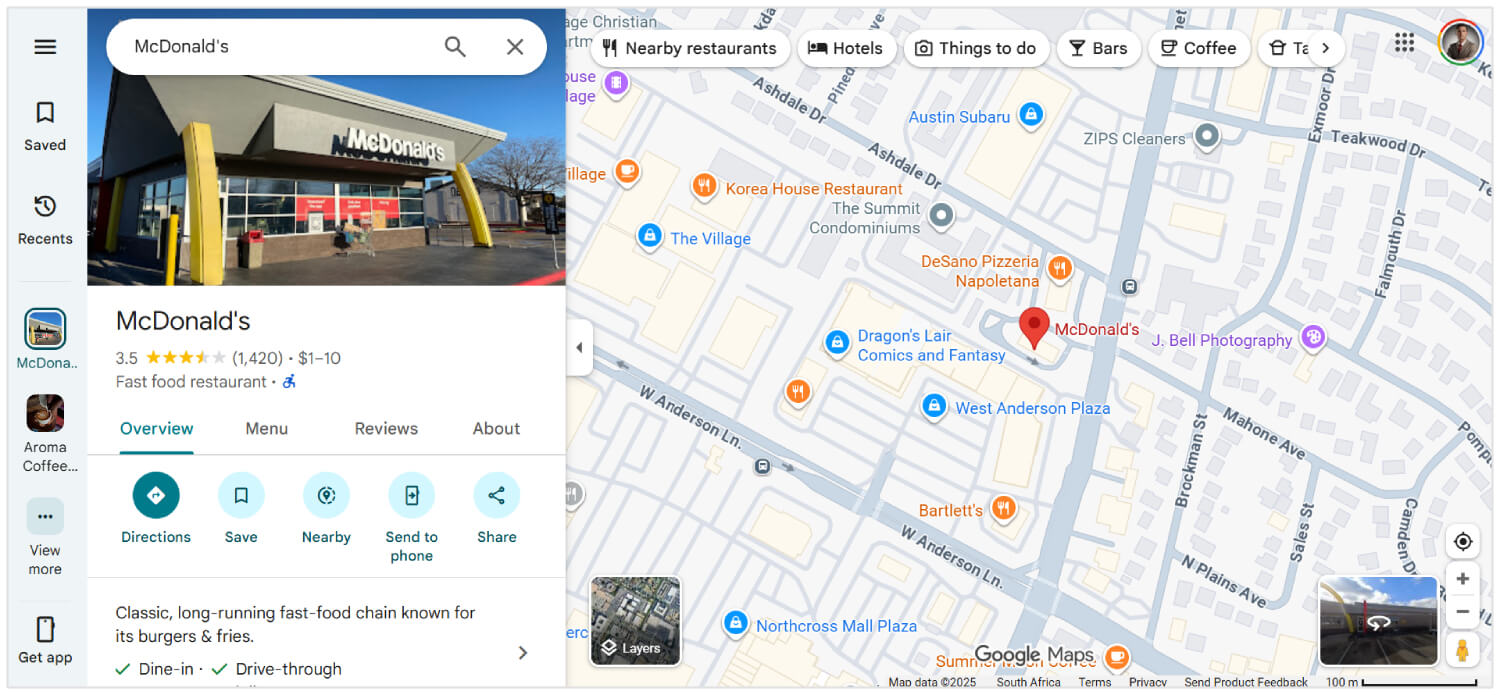

Google Maps

Google Maps bietet umfangreiche interaktive Funktionen wie "Schwenken", "Zoomen" und "Suchen von Standorten", alles auf derselben Seite.

Es wird nicht neu geladen, wenn Sie neue [Richtungen] anfordern oder zwischen [Satelliten-] und [Kartenansichten] wechseln.

Stattdessen werden Daten über AJAX abgerufen, und die Kartenelemente oder UI-Komponenten [aktualisieren] sich dynamisch. Dies lässt Google Maps äußerst reaktionsschnell und benutzerfreundlich erscheinen, selbst bei langsameren Verbindungen.

Obwohl nicht 100% SPA, verwenden große Teile von Facebook die SPA-Architektur.

Wenn Benutzer durch ihren Newsfeed scrollen, Beiträge öffnen, reagieren oder kommentieren, erfolgen alle Updates ohne ein Neuladen der Seite.

Selbst beim Wechsel zwischen Seiten wie "Nachrichten", "Benachrichtigungen" und "Marktplatz" verwendet die Seite clientseitiges Routing mit JavaScript-Frameworks (wie React), um Inhalte dynamisch zu rendern, was Serveraufrufe reduziert und die Ladegeschwindigkeit verbessert.

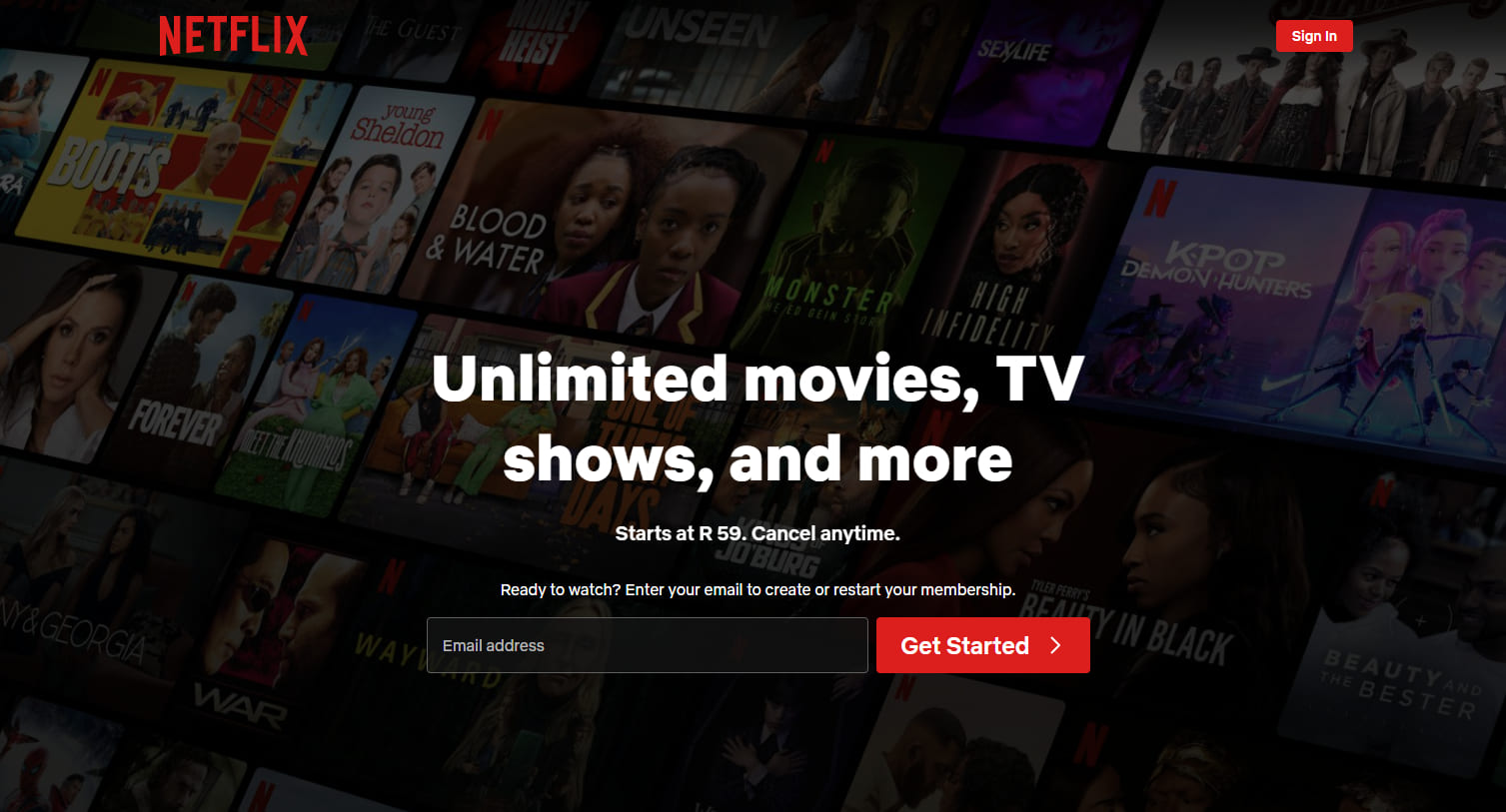

Netflix

Die Weboberfläche von Netflix ist eine weitere hochkarätige SPA. Während Sie durch Film- oder TV-Show-Vorschläge [blättern], spielen Trailer automatisch ab, und Inhaltsdetails [erscheinen] sofort, ohne neu zu laden.

Durch Klicken auf einen Titel wird ein modales Overlay oder eine neue Ansicht geöffnet, während die Kernschnittstelle intakt bleibt.

Die "Routing", "Empfehlungen" und Änderungen am "Benutzerprofil" werden von JavaScript verwaltet, was ein konsistentes Erlebnis mit niedrigen Wartezeiten liefert.

Ist eine Single Page Application gut für SEO?

Ja, eine "Single Page Application" ist gut für "SEO", wenn Sie die richtigen Optimierungstipps für "SPAs" kennen.

Suchmaschinen wie Google können JavaScript "rendern", aber sie können das Crawlen verzögern oder Inhalte überspringen, die [Benutzerinteraktion] erfordern.

Um das zu vermeiden, können Sie "serverseitiges Rendering", "statische Seitengenerierung", saubere URL-Routing und dynamische Metadatenaktualisierungen verwenden.

Werkzeuge wie Next.js, Nuxt.js, React Helmet und Vue Meta helfen dabei, all das [umzusetzen].

Mit der richtigen Einrichtung kann eine SPA genauso gut ranken wie jede traditionelle Website. Ohne [richtige] SEO-Anpassungen könnten Suchmaschinen jedoch viel von dem verpassen, was Sie aufgebaut haben.

Verwandte Lektüre: Wie man SEO für dynamische Inhalte durchführt

Wie man SEO für "Single Page Applications" macht

Hier sind die besten SEO-Lösungen für "Single Page Web Apps":

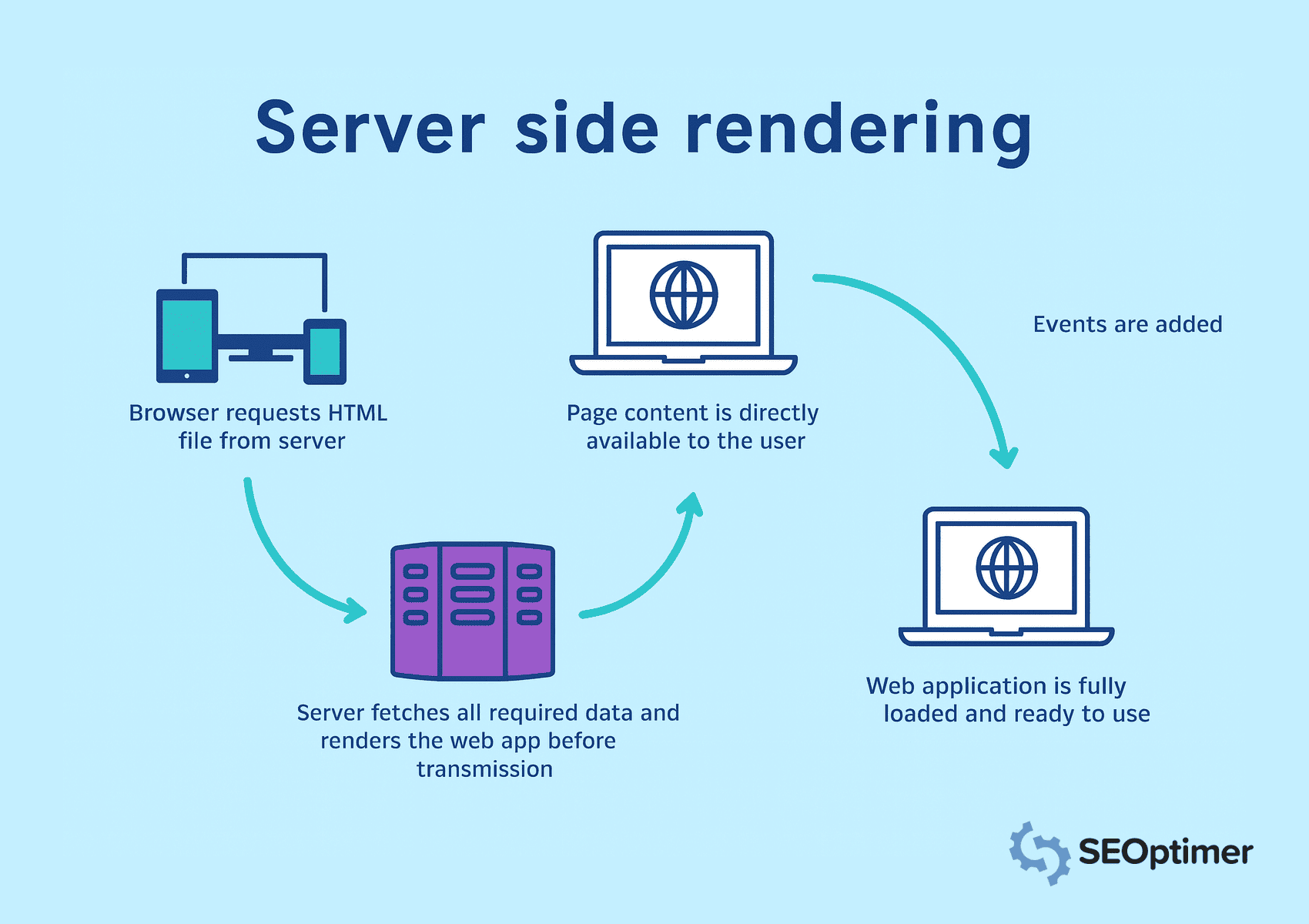

Verwenden Sie "Server-Side Rendering" (SSR)

"Single-Page-Anwendungen" verlassen sich auf JavaScript, um Inhalte dynamisch zu laden.

Jedoch erwarten Suchmaschinen vollständiges Server-HTML in der HTTP-Antwort, um auf Inhalte zuzugreifen, sie zu durchsuchen und zu indexieren.

Deshalb sollten Sie serverseitiges Rendering implementieren, um Seiten auf dem Server zu rendern, bevor Sie sie an den Browser senden.

In Server-seitiges Rendering, fordert der Browser HTML-Dateien an, und der Server ruft alle Daten ab. Es stellt sicher, dass alle Inhalte sofort sichtbar und durchsuchbar sind.

Speichern Sie häufig aufgerufene Seiten im Cache, um die Ladezeiten zu verkürzen und Inhalte schneller bereitzustellen. Vermeiden Sie die clientseitige Darstellung für [Schlüsselelemente], da Suchmaschinen möglicherweise "JavaScript"-lastige Ansichten nicht verarbeiten können.

Implementieren Sie "Pre-Rendering" für [statische Routen]

Sie sollten Routen vorab rendern, die jedem Besucher denselben Inhalt zeigen. Es ermöglicht Ihnen, HTML zur Build-Zeit zu generieren und beseitigt die Notwendigkeit für das Rendern zur Laufzeit.

Als Ergebnis können Suchmaschinen auf die Seite "sofort" zugreifen.

Tools zur "statischen Generierung" aus Frameworks wie Next.js oder Nuxt.js können Ihnen helfen, "statische Dateien" für Routen wie [Landingpages], [Blogs] oder [Produktübersichten] zu erstellen.

Sie sollten diese vorgerenderten Seiten über ein Content Delivery Network oder Webserver bereitstellen, um die Ladegeschwindigkeit und Sichtbarkeit zu verbessern. Vermeiden Sie es, Vorab-Rendering auf Ansichten mit "Echtzeit-" oder benutzerspezifischen Daten anzuwenden.

Fügen Sie sauberen und durchsuchbaren HyperText Markup Language-Ausgabe hinzu

Sie sollten gut strukturierte HyperText Markup Language-Ausgabe erzeugen, die Suchmaschinen leicht interpretieren können.

Sauberes Markup hilft Bots, das Seitenlayout, die Hierarchie und Schlüsselelemente zu verstehen, ohne sich auf die Ausführung von JavaScript zu verlassen.

Vermeiden Sie das dynamische Einfügen von Inhalten nach dem Laden der Seite. Stellen Sie stattdessen sicher, dass wichtiger Text, "Überschriften", und Links direkt im Quellcode erscheinen.

Wenn Sie an der "SEO" für eine [einzelne] Seite App arbeiten, ist das Wichtigste zu beachten, dass Google Ihre Seite nicht immer so sieht, wie es Menschen tun. Da sie Inhalte mit "JavaScript" laden, erhält der Crawler manchmal nur eine leere Seite. Stellen Sie also sicher, dass das, was Google lesen soll, tatsächlich im html erscheint.

- Ciara Edmondson, SEO & "Content Manager" bei Max Web Solutions

Verwenden Sie semantische Tags wie <header>, <main>, <article> und <footer>, um eine klare Struktur bereitzustellen.

Sie sollten auch minimieren Inline-Stileund Skript-Unordnung, die den [bedeutungsvollen] Inhalt [verschleiern] könnte.

Halten Sie das Dokument lesbar und leichtgewichtig für schnelleres Crawlen und bessere Indexierung.

Verwenden Sie serverseitiges Rendering oder Vorab-Rendering, um statisches HTML für jede Route zu erzeugen. Es garantiert, dass Crawler auf den vollständigen Seiteninhalt bei der anfänglichen Anfrage zugreifen.

Statische "Snapshots" für "Crawler" freigeben

Sie sollten statische Schnappschüsse bereitstellen, um sicherzustellen, dass Crawler auf vollständige Inhalte zugreifen können, insbesondere wenn die clientseitige Darstellung die Seitenausgabe verzögert.

Ein statischer Snapshot ist eine vollständig gerenderte Version der Seite, die im Voraus erstellt und speziell für Bots bereitgestellt wird.

Diese Taktik ist nützlich, wenn serverseitiges Rendering oder Vor-Rendering nicht für die gesamte Anwendung machbar ist.

Snapshots bieten einen alternativen [Pfad] für Crawler, um auf strukturierte HyperText Markup Language zuzugreifen, ohne JavaScript auszuführen.

Sie sollten den Server so konfigurieren, dass er User Agents wie Googlebot erkennt und vorgefertigte Schnappschüsse für diese Anfragen bereitstellt.

Tools wie Rendertron, Prerender.io oder benutzerdefinierte "headless NodeJS"-Renderer können helfen, [Schnappschüsse] zuverlässig zu erstellen und zu liefern.

Stellen Sie sicher, dass jede Momentaufnahme den vollständigen Inhalt und die Struktur der Seite widerspiegelt, einschließlich "Titel", "Metadaten", "Links" und "Schema-Markup".

Safira von Somar Digital, einer Agentur mit Sitz in Neuseeland, empfiehlt, dass alle SPAs "Schema-Markup" für ihr [SEO] verwenden sollten.

Ich empfehle die Verwendung von "Structured data schema markup" für SPAs. Integrieren Sie relevante "schema markups" wie [Organisation], [Webseite], [Breadcrumb-Liste], [FAQ] usw.

Ich habe bemerkt, dass manchmal "Schema-Markup" möglicherweise nicht im Quellcode oder sogar im Google Rich Results Test angezeigt wird, aber wenn Sie das Schema mit dem "Schema Markup Validator" testen, werden Sie hinzugefügte Schema-Markups in den Ergebnissen sehen. Dies passiert, weil SPAs, die das Schema (über JavaScript) einfügen, dies beim ersten Laden nicht verfügbar haben. Aber Google kann das JavaScript lesen, da es [headless] ist.

- Safira Mumtaz, SEO/SEM Spezialistin bei Somar Digital

Sie sollten auch die Indexabdeckung überwachen, um zu bestätigen, dass Crawler "Snapshots" wie beabsichtigt verarbeiten.

Das Bereitstellen statischer Schnappschüsse verbessert die Sichtbarkeit für Seiten mit komplexer Rendering-Logik, was dazu beiträgt, einen konsistenten [Indexierungs-] und SEO-Wert zu erhalten.

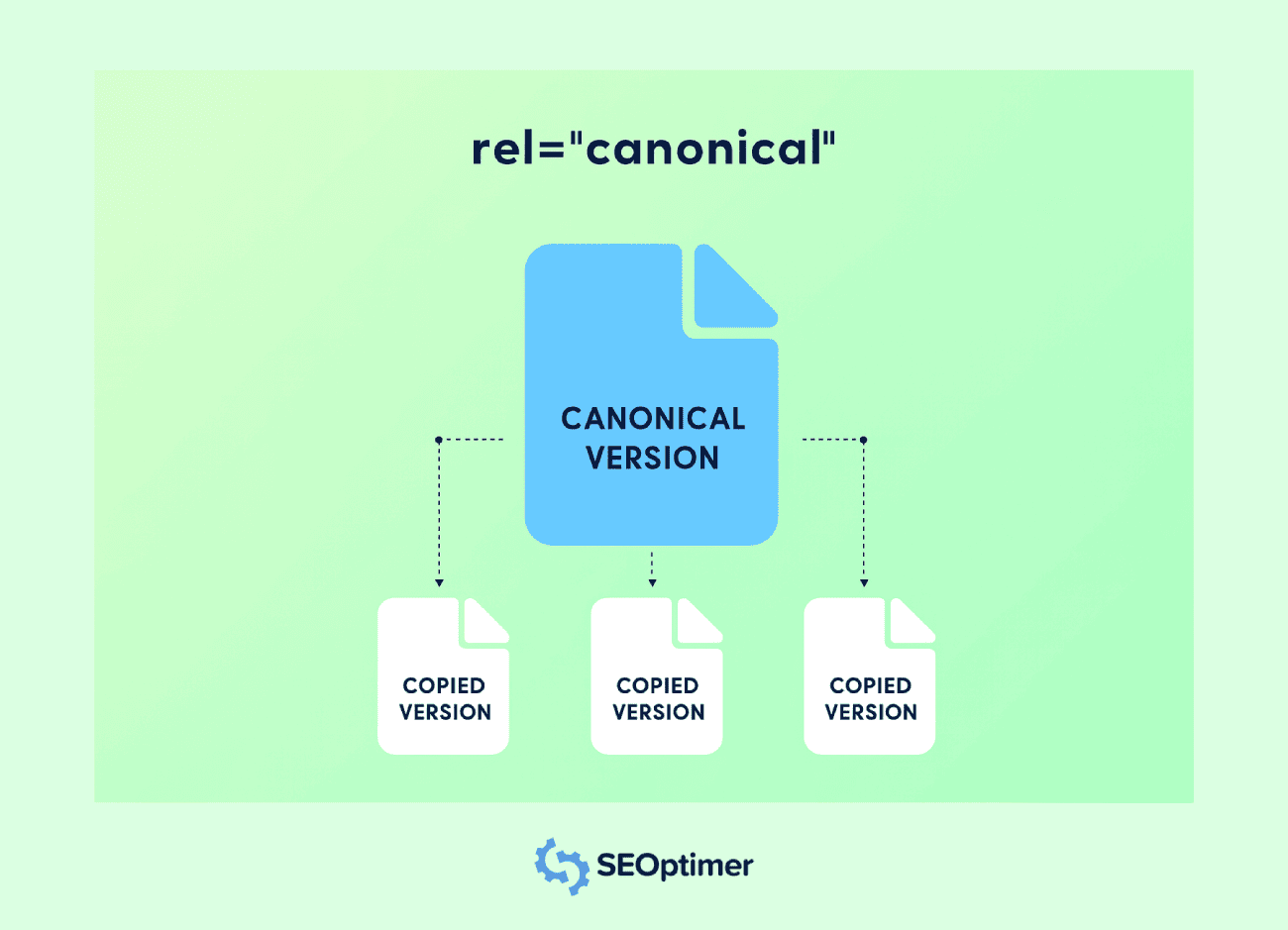

Einrichten von "Canonical Tags" für jede Ansicht

Sie sollten für jede Route in einer Single-Page-Anwendung ein kanonisches Tag festlegen, um Probleme mit doppeltem Inhalt zu vermeiden.

Die meiste Zeit werden SPAs mehrere zugängliche URLs für denselben [Inhalt] generieren.

Zum Beispiel kann derselbe Inhalt in URLs mit unterschiedlichen "query strings", "filters" oder "tracking parameters" vorhanden sein. "Canonical tags" helfen Suchmaschinen, die bevorzugte Version zu verstehen.

Jede Route sollte ein <link rel="canonical">-Tag enthalten, das auf die Original-URL für diese Ansicht verweist. Es verhindert „Link Equity Dilution“ unter verschiedenen URLs mit demselben Inhalt.

Sie sollten kanonische Tags dynamisch einfügen, wenn sich die Route ändert, insbesondere wenn die Anwendung Metadaten auf der Clientseite aktualisiert.

Verwenden Sie Routing-Hooks oder Middleware-Funktionen, um das richtige "Tag" bei jedem Seitenwechsel zuzuweisen.

Vermeiden Sie es, alle Routen auf die Homepage zu verweisen oder einen statischen kanonischen Wert zu verwenden. Jede einzigartige Ansicht sollte ihre eigene logische URL widerspiegeln, um Relevanz und Indexgenauigkeit [zu bewahren].

Die Implementierung einer ordnungsgemäßen "Kanonisierung" unterstützt eine klarere Indizierung, verbessert die Seitenautorität und verhindert unerwünschte "Duplizierung" in Suchergebnissen.

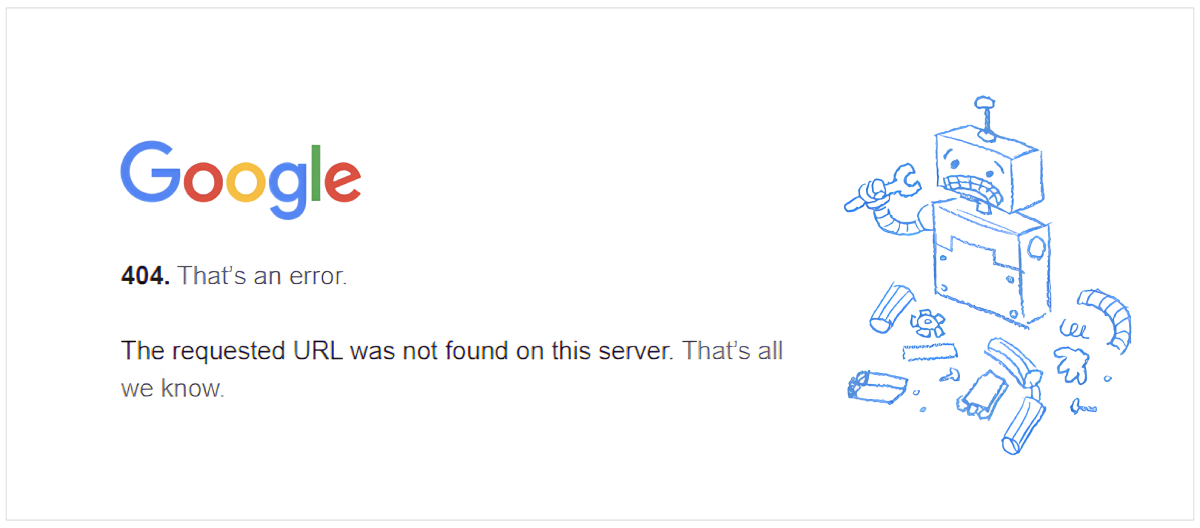

404 und andere Statuscodes korrekt "behandeln"

Sie sollten genaue Statuscodes für alle Ansichten in einer "Single Page Application" konfigurieren, um Suchmaschinen zu helfen, die [Struktur] Ihrer [Website] richtig zu interpretieren.

Viele SPAs liefern für jede Anfrage eine Standard-HTML-Hülle, die auch für nicht vorhandene "Routen" ein 200 OK zurückgeben kann.

Eine korrekte 404 Not Found-Antwort sollte für ungültige URLs zurückgegeben werden.

Verwenden Sie "Serverlogik" oder "Middleware" in NodeJS, um nicht übereinstimmende [Routen] zu erkennen und den richtigen Statuscode zusammen mit einer benutzerdefinierten Fehlerseite zu senden.

Sie sollten auch andere Antworten wie 301 oder 302 für "Weiterleitung" und 500 für "Serverfehler" behandeln.

Diese Statuscodes informieren Suchmaschinen, wie jede Anfrage behandelt werden soll und die Integrität Ihrer [Durchforstungs-] und Indexabdeckung aufrechterhalten wird.

Vermeiden Sie es, sich ausschließlich auf die Fehlerbehandlung auf der Client-Seite zu verlassen. Crawler führen möglicherweise kein JavaScript aus, daher können falsche Statusantworten Suchmaschinenoptimierungssignale beeinträchtigen und die Indexierung irreführen.

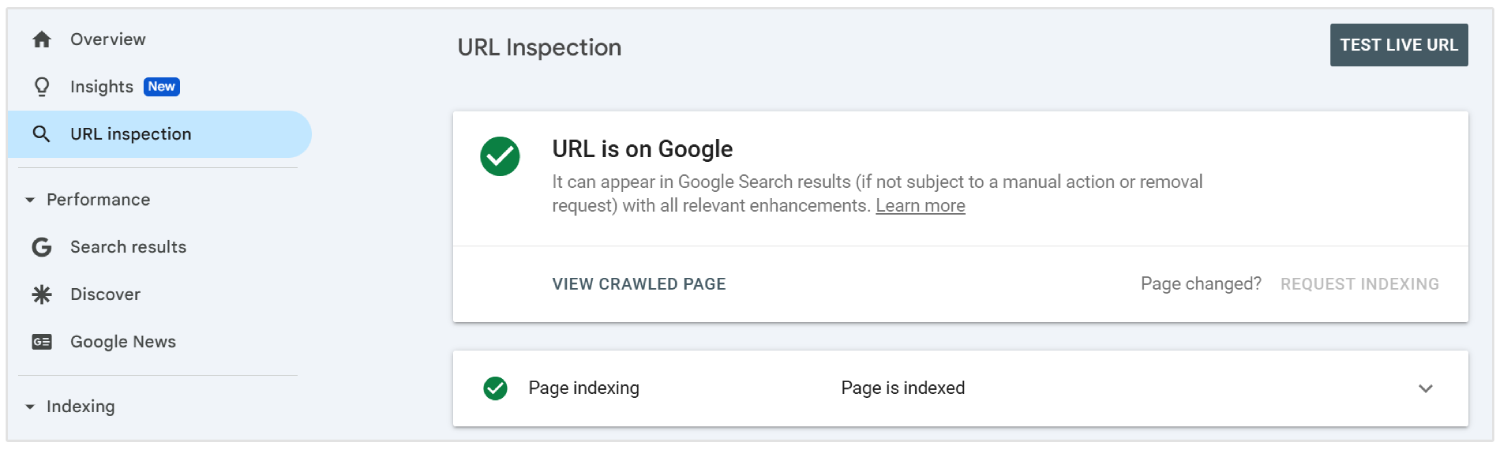

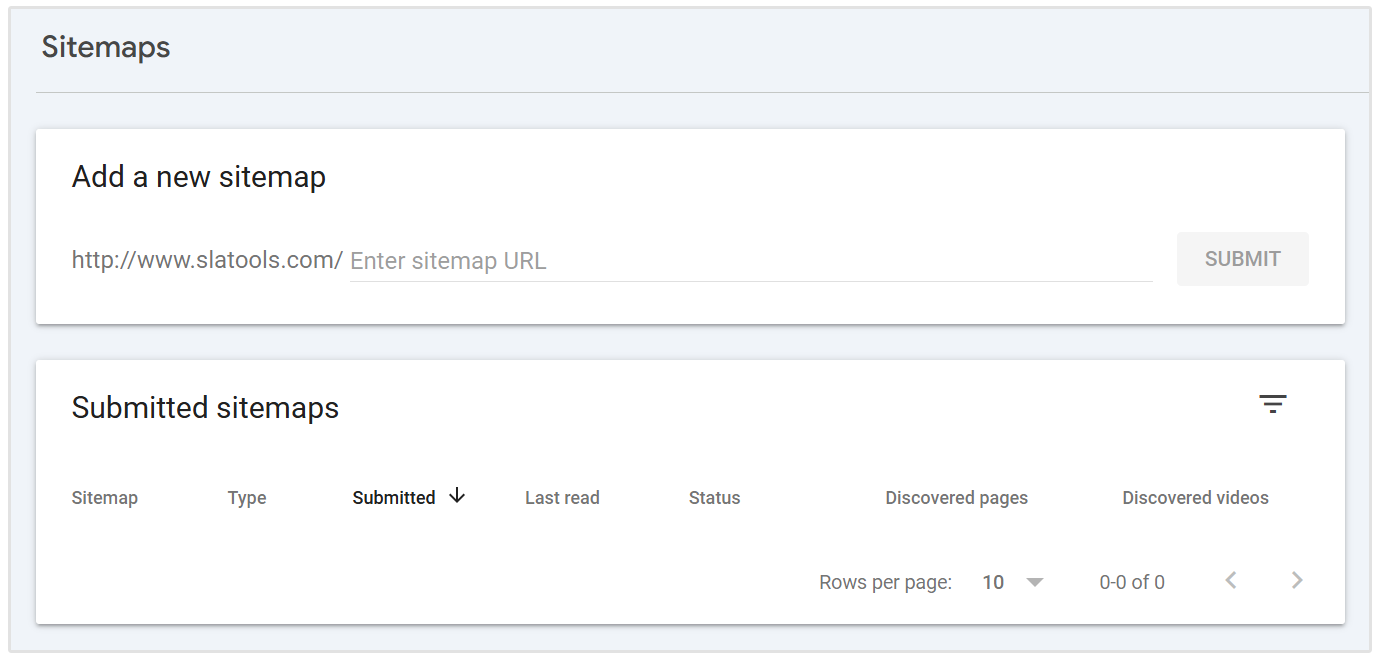

Übermitteln Sie dynamische URLs an die Google Search Console

Sie sollten alle wichtigen dynamischen URLs von einer Single-Page-Anwendung mit dem URL-Prüftool in die Google Search Console einreichen. Es hilft Suchmaschinen-Bots, Inhalte zu entdecken und zu indexieren, die bei einem traditionellen Crawl möglicherweise nicht erscheinen.

Da SPAs Inhalte über clientseitiges Routing laden, können einige interne Seiten von Crawlern ohne direkte Verlinkung [möglicherweise] nicht gefunden werden.

Um die Sichtbarkeit zu gewährleisten, listen Sie diese URLs in einer XML-Sitemap auf und reichen Sie sie über die Konsolenoberfläche ein.

Sie sollten die Sitemap aktualisieren, wann immer neue Routen [hinzugefügt] oder [geändert] werden. Jeder Eintrag muss die endgültige, saubere URL widerspiegeln, die Benutzer und Crawler sehen, ohne Hashes oder unnötige Parameter.

Das Einreichen dynamischer URLs gibt Google eine klare Karte der Struktur Ihrer Anwendung und verbessert die Chancen auf genaues Crawlen und schnellere Indexierung.

Aktivieren Sie "Lazy Loading" mit [Fallbacks]

Sie sollten "Lazy Loading" aktivieren, um die Leistung in SPAs zu verbessern, indem das Laden von nicht wesentlichen Elementen wie Bildern, Videos oder Bereichen unterhalb der Falz verzögert wird.

Es hilft, die anfängliche Ladezeit zu reduzieren und verbessert die Benutzererfahrung auf Desktop- und mobilen Ansichten.

Suchmaschinen können Inhalte, die über JavaScript geladen werden, möglicherweise nicht auslösen, was zu verpasstem [Indexing] führen kann.

Sie sollten Fallbacks wie "Platzhalter-Inhalte" oder <noscript>-Tags bereitstellen, um sicherzustellen, dass alle "Schlüsselelemente" für Crawler sichtbar bleiben.

Verwenden Sie native Browserfunktionen wie das Attribut loading="lazy" oder verwalten Sie das scrollbasierte Laden durch JavaScript. Sie sollten die Sichtbarkeit immer mit Tools wie Google Search Console bestätigen.

Vermeiden Sie es, wichtige Inhalte oder Links zu verzögern, die zur Sichtbarkeit in der Suche beitragen. Der richtige Einsatz von "Lazy Loading" mit zuverlässigen Fallbacks unterstützt eine schnellere Ladegeschwindigkeit und eine vollständige Inhaltsabdeckung.

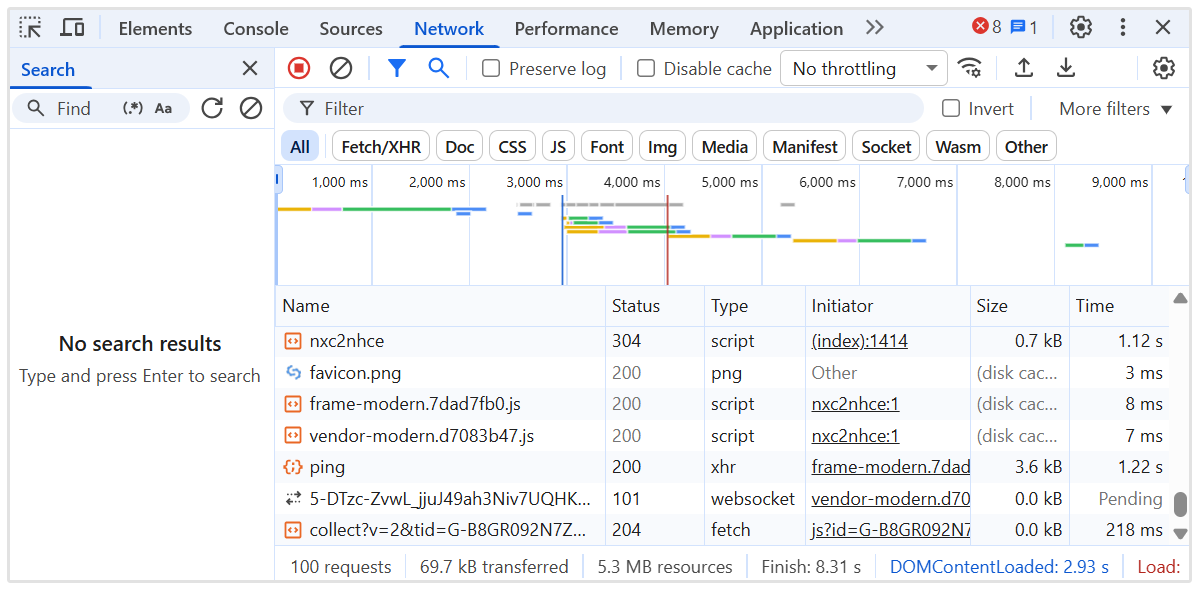

Aufschub von nicht-kritischem JavaScript

Sie sollten nicht-kritisches JavaScript aufschieben, um das anfängliche Seiten-Rendering zu beschleunigen und die Blockierung wichtiger Inhalte in "Single Page Applications" zu reduzieren.

Skripte, die nicht "essenziell" für den "above-the-fold"-Inhalt sind, können sowohl die Benutzerinteraktion als auch die Sichtbarkeit für Crawler verzögern.

Verwenden Sie die Attribute defer oder async in script-Tags, um unnötige Ausführung während des ersten Seitenladens zu verhindern.

Platzieren Sie nicht essenzielle Skripte am Ende des Dokuments oder laden Sie sie, nachdem der Kerninhalt gerendert wurde.

Sie sollten [identifizieren], welche Skripte das Layout, die Metadaten oder die Routing-Logik [beeinflussen], und diese von Analysen, Chat-Widgets oder Animationen [trennen].

Tools wie Lighthouse und Chrome DevTools können helfen, das Verhalten von Skripten und die Ladefolge zu [überprüfen].

Interne Verlinkung zwischen SPA-Routen implementieren

Sie sollten eine klare interne Verlinkungsstruktur zwischen allen Routen in einer Single-Page-Anwendung erstellen, um "Crawler" durch die Seite zu führen.

Im Gegensatz zu herkömmlichen Websites verlassen sich SPAs auf die "clientseitige" Navigation, was verhindern kann, dass Suchmaschinen alle internen Seiten entdecken, wenn Links nicht korrekt hinzugefügt werden.

Verwenden Sie Anker-Tags mit richtigen href-Attributen, die den tatsächlichen Pfad widerspiegeln, nicht nur JavaScript-Funktionen oder -Buttons. Vermeiden Sie die Verwendung von Elementen wie onClick-Handlern ohne sinnvolle URLs, da diese von Crawlern (meistens) ignoriert werden.

Sie sollten sicherstellen, dass jede wichtige Seite von anderen Teilen der Anwendung verlinkt ist, insbesondere von der Homepage und von Seiten mit hoher Autorität. Es hilft, Relevanz- und Autoritätssignale für effizientes Crawlen zu übermitteln.

Behalten Sie eine logische Hierarchie mit Navigationsmenüs, "Breadcrumbs" und kontextuellen Links zwischen [verwandten] Ansichten bei. Verwenden Sie beschreibenden Ankertext, um Seitenthemen zu verstärken.

Interne Verlinkung verbessert die Crawltiefe, verteilt Autorität und stärkt die Gesamtleistung der Suchmaschinenoptimierung in der gesamten Anwendung.

Verwenden Sie eine Sitemap, die alle wichtigen [Routen] widerspiegelt

Sie sollten eine Sitemap erstellen und einreichen, die jede wichtige Route in der "Single Page Application" enthält.

Da SPAs clientseitiges Routing verwenden, sind viele interne Ansichten möglicherweise nicht durch traditionelles Crawling "auffindbar".

Erstellen Sie eine XML-Sitemap, die alle statischen und dynamischen Routen auflistet, die zur [Indexierung] vorgesehen sind. [Einschließen] Sie nur saubere, kanonische URLs ohne unnötige Parameter, Fragmente oder Sitzungsdaten.

Sie sollten die "Sitemap" aktualisieren, wann immer neue Routen hinzugefügt, entfernt oder geändert werden. Automatisierungstools können die "Sitemap" bei jeder Bereitstellung neu generieren, um sie genau zu halten.

Reichen Sie die "Sitemap" in der Google Search Console ein, um Suchmaschinen zu helfen, wichtige Inhalte zu finden und zu priorisieren. Dies unterstützt eine vollständige Indexabdeckung und verstärkt die Sichtbarkeit auf Routenebene.

Ein gut gepflegter "Sitemap" verbessert die Crawling-Effizienz und stellt sicher, dass wichtige Ansichten die Aufmerksamkeit erhalten, die sie benötigen.

Überwachen Sie das Crawl-Verhalten mit Serverprotokollen

Sie sollten Serverprotokolle analysieren, um zu verstehen, wie Suchmaschinen mit Ihrer "Single Page Application" interagieren.

Protokolle zeigen, welche Routen "gecrawlt" werden, wie häufig sie aufgerufen werden und ob Bots auf [Fehler] oder Verzögerungen stoßen.

Überprüfen Sie HTTP-Statuscodes, Benutzeragenten und Zeitstempel, um [Indexierungs]lücken oder [Crawl]-Ineffizienzen zu erkennen.

Suchen Sie nach Anzeichen für "verpassten" Inhalt, wiederholte Zugriffe auf irrelevante Seiten oder fehlgeschlagene Antworten, die die Sichtbarkeit beeinträchtigen könnten.

Sie sollten verfolgen, wie Googlebot durch dynamische Routen navigiert und überprüfen, ob wichtige Ansichten "Crawl"-Aufmerksamkeit erhalten. Kombinieren Sie Protokolldaten mit Einblicken aus Tools wie Google Search Console, um die "Indexierungsabdeckung" zu überprüfen.

Verwenden Sie "Serverprotokoll"-Analysetools oder exportieren Sie Daten aus Ihrer NodeJS-Serverumgebung für tiefere Einblicke.

Die Überwachung der Echtzeit-Bot-Aktivität hilft, "crawl waste" zu identifizieren, Entdeckbarkeitsprobleme zu beheben und die Gesamtleistung der SPA-SEO zu optimieren.

Beheben Sie Renderprobleme mit dynamischem Inhalt

Sie sollten "Rendering-Probleme" in "Single-Page-Anwendungen" beheben, um sicherzustellen, dass dynamische Inhalte für Suchmaschinen vollständig sichtbar sind.

Inhalt, der von der Ausführung von JavaScript abhängt, [kann] während des Crawlens nicht erscheinen, wenn er zu spät geladen wird oder eine Benutzerinteraktion [erfordert].

Prüfen Sie jede Route, um zu bestätigen, dass "wichtiger Text", Links und "Überschriften" in der gerenderten Ausgabe verfügbar sind. Verwenden Sie Tools wie Googles URL Inspection Tool oder Lighthouse, um [Inhalte] zu erkennen, die im anfänglichen Rendern fehlen.

Sie sollten Techniken wie "serverseitiges Rendering" oder "Pre-Rendering" anwenden, um vollständig erstellte Seiten bereitzustellen, wo sie benötigt werden.

Für die "clientseitige" [Rendering], stellen Sie sicher, dass Daten schnell geladen werden und nicht auf verzögerte Auslöser angewiesen sind.

Vermeiden Sie es, kritische Informationen nach der Verarbeitung der Seite durch den Crawler hinzuzufügen. Verzögerungen bei der Darstellung können zu einer [teilweisen] Indexierung oder einem Ausschluss aus den Suchergebnissen führen.

Das [Beheben] von Renderproblemen [gewährleistet] die vollständige Sichtbarkeit wichtiger Inhalte, [unterstützt] eine bessere Indexierung und [stärkt] die gesamten Suchmaschinenoptimierungsergebnisse für SPAs.

JavaScript-Ausführung mit Crawler-Fähigkeiten [abgleichen]

Sie sollten die Ausführung von JavaScript so strukturieren, dass sie den Verarbeitungsgrenzen moderner Crawler entspricht, insbesondere der Rendering-Warteschlange und den Ressourcenbeschränkungen von Googlebot.

Crawler arbeiten mit einem Zeitbudget für jede URL. Daher können übermäßige Abhängigkeitsketten, asynchrones Datenabrufen oder renderblockierende Logik zu einer unvollständigen Indexierung von "Schlüsselseiten" führen.

Priorisieren Sie das Rendering von "kritischem Pfadinhalt" während der [initialen] "Paint-Phase". Vermeiden Sie verschachtelte Hydratationsschichten, verzögerte DOM-Mutationen oder übermäßige Verwendung von clientseitigen Komponenten.

Ersetze "Laufzeitinhaltsinjektion" durch serverseitig vorgeladene Daten oder "Skelettlayouts", wo vollständiges Server-HTML nicht machbar ist.

Sie sollten die Ausführungszeit mit Tools wie dem Performance-Panel von Chrome DevTools überwachen und Crawler-Bedingungen mit Puppeteer oder Headless-NodeJS-Renderern simulieren.

Verfolgen Sie die Zeit bis zur Interaktivität (TTI), das größte inhaltsvolle Rendering (LCP) und die gesamte Blockierungszeit (TBT) unter [keinen] Cache-Bedingungen.

Stellen Sie sicher, dass routenspezifische Metadaten, kanonische Tags und Schema synchron eingebunden werden. Reduzieren Sie die Abhängigkeit von "schweren Bibliotheken" oder Laufzeit-Routing-Frameworks, die die [bedeutsame] Rendering-Ausgabe verzögern.

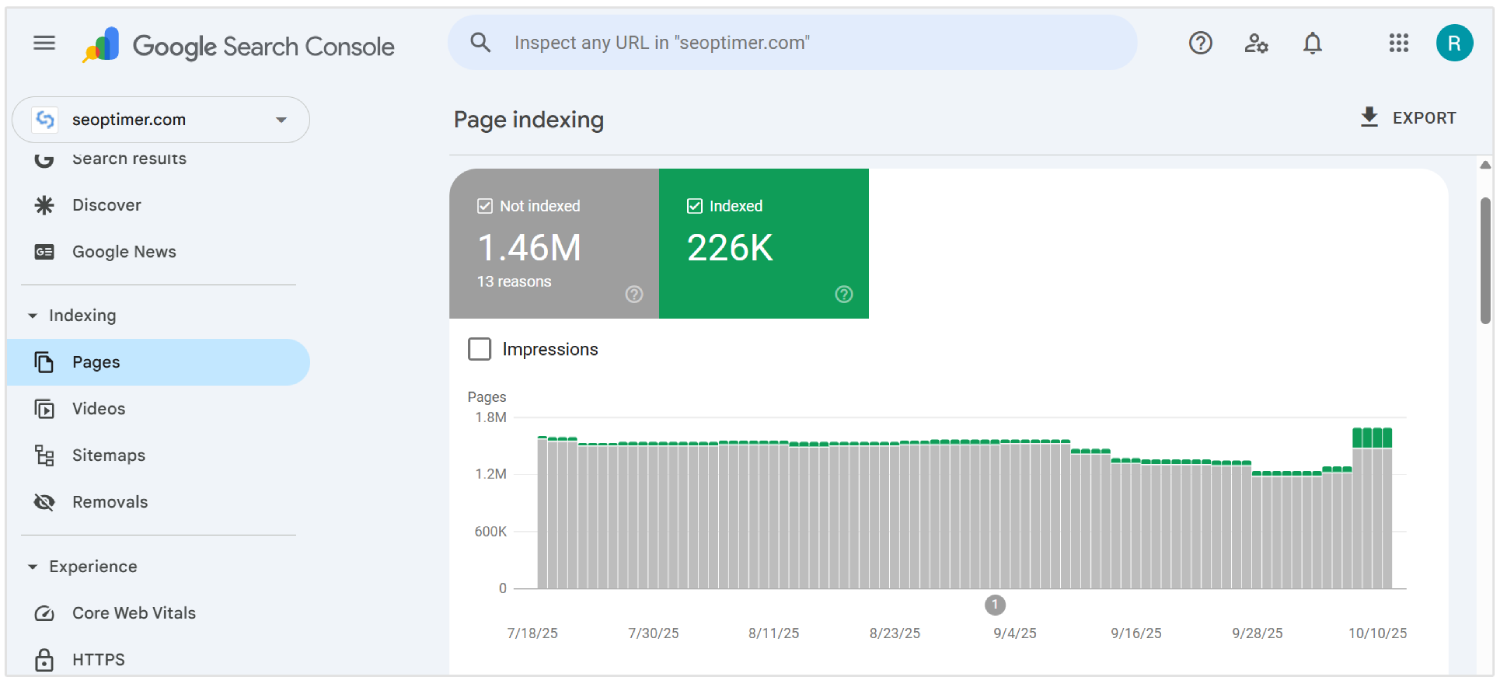

Überprüfen Sie die SEO-Leistung mit spezialisierten Werkzeugen

Sie sollten die Leistung Ihrer Suchmaschinenoptimierung regelmäßig prüfen, um Sichtbarkeitsprobleme in "Single Page Applications" zu erkennen.

Standard-Browser-basierte Überprüfungen übersehen [Probleme], die einzigartig für JavaScript-intensive Umgebungen sind.

Die Verwendung fortschrittlicher Tools bietet tiefgehende Einblicke, wie Seiten von Suchmaschinen "gerendert", "indexiert" und bewertet werden.

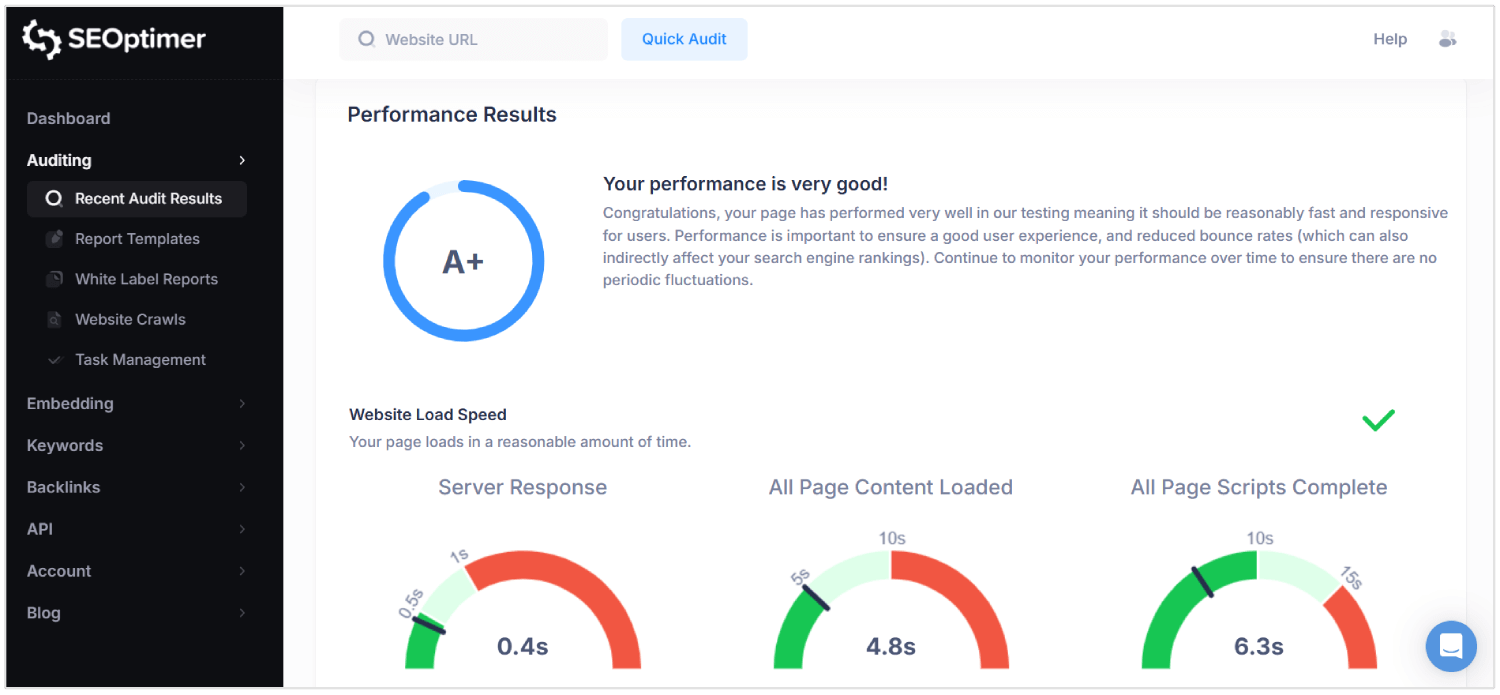

SEOptimer ist ein solches Werkzeug, das umfassende Audits in den Bereichen "Technik", "On-Page" und "Leistung" durchführt.

Es scannt jede Seite auf "Metadatenqualität", "mobile Reaktionsfähigkeit", interne Verlinkungsstruktur und "Inhalt-zu-Code-Verhältnis".

Für SPAs hilft SEOptimer dabei, fehlende "HyperText Markup Language"-Elemente, falsch konfigurierte kanonische Tags und schwache Header-Strukturen zu identifizieren, die die "crawlability" beeinträchtigen.

Sie sollten SEOptimer-Prüfungen durchführen, nachdem Sie größere Updates bereitgestellt oder neue Routen gestartet haben. Das Tool kennzeichnet "Rendering-Verzögerungen", "defekte Links" und JavaScript-Abhängigkeiten, die das korrekte Laden von Inhalten verhindern.

Kombinieren Sie SEOptimer mit Tools wie Google Search Console und Log-Analysatoren, um Ergebnisse unter realen Crawl-Bedingungen zu validieren.

Regelmäßige Überprüfung stellt sicher, dass "Routing-Logik", Inhaltsbereitstellung und "Rendering-Verhalten" alle eine nachhaltige SEO-Leistung unterstützen.

Warum SEO für SPAs "herausfordernd" ist

SEO ist "schwierig" für "Single Page Apps", weil "Metadaten", routenspezifische Inhalte und korrekte Statuscodes von "Crawlers" möglicherweise übersehen oder missverstanden werden.

Hier sind die wichtigsten SEO-Herausforderungen für SPAs:

1. "Client-seitiges Rendering"

Suchmaschinen erwarten, dass "bedeutungsvolle Inhalte" in der anfänglichen HTML-Antwort vorhanden sind. SPAs verlassen sich auf JavaScript, um Inhalte nach dem Laden der Seite zu rendern, was die "Sichtbarkeit" verzögert.

Wenn ein Crawler die Seite aufruft, bevor das Rendern abgeschlossen ist, können Schlüsselelemente wie "Text" und [Links] möglicherweise nicht verarbeitet werden. Dies birgt das Risiko, dass Suchmaschinen unvollständige oder leere Seiten indexieren.

Als Ergebnis "erreicht" Inhalt, den Benutzer sehen können, niemals die Suchmaschinenergebnisse.

2. Crawling-[Einschränkungen]

SPAs "stellen" nicht alle Seiten über traditionelle statische Links "bereit", was das Crawlen "komplizierter" macht.

Viele Seiten sind nur über die interne clientseitige Navigation zugänglich, der Suchbots möglicherweise nicht folgen.

Selbst moderne Crawler wie Googlebot rendern JavaScript mit Verzögerungen und begrenzter Verarbeitungszeit. Seiten, die mehrere Renderzyklen oder verschachteltes Datenabrufen erfordern, können das "Crawl-Budget" überschreiten.

Wichtige "Ansichten" können vollständig übersehen werden, was die "Sichtbarkeit" der "Website" in Suchergebnissen schwächt.

3. Dynamische Metadatenverwaltung

Jede Ansicht in einem SPA fehlt es an einzigartige Metadatensofern nicht manuell konfiguriert.

Ohne "dynamische" Aktualisierungen von Titeln, Beschreibungen und kanonischen Tags erscheinen alle URLs für Suchmaschinen identisch.

Dies führt zu Indexierungsfehlern, reduzierter Relevanz und niedrigeren Klickraten.

Metadaten, die an URL-Änderungen gebunden sind, müssen in Echtzeit mithilfe von Bibliotheken oder benutzerdefinierter Logik "eingespeist" werden. Die [Nichtbeachtung] dieser Verwaltung verhindert, dass die Anwendung ordnungsgemäß über verschiedene Suchanfragen hinweg "ranken" kann.

4. Nicht-Standard-URL-Strukturen

SPAs können URLs verwenden, die von Hash-Fragmenten oder der Manipulation des Browserverlaufs abhängen. Diese Formate können Verwirrung bei Suchmaschinen verursachen, die saubere, "kanonische" Pfade bevorzugen.

Wenn eine Route keine "ordnungsgemäße" Struktur aufweist, wird sie möglicherweise nicht indiziert oder als [Duplikat] behandelt.

Inkonsistente URLs "brechen" auch das "Deep Linking", das entscheidend für die Benutzerführung und die Crawltiefe ist.

Die "SEO-Leistung" leidet, wenn Bots keine realen, eindeutigen URLs interpretieren oder darauf zugreifen können.

5. Falsche HTTP-Statuscodes

Im Gegensatz zu traditionellen Seiten antworten SPAs mit 200 OK, auch für nicht vorhandene Routen.

Dies führt dazu, dass Suchmaschinen Fehlerseiten oder irrelevante Inhalte indizieren.

Ohne korrekte Codes wie 404 Nicht Gefunden oder 301 Umleitung können Crawler veraltete Seiten nicht entfernen oder neuen Pfaden folgen.

Bots erfordern genaue Statussignale, um [Website-]Struktur und Inhaltsänderungen zu interpretieren.

SPAs, die diese Antworten falsch handhaben, verlieren die Kontrolle darüber, wie ihr Inhalt in Suchergebnissen erscheint.

6. Keine Seitenaktualisierungen während der Navigation

In SPAs, "Routenänderungen" [geschehen] innerhalb des Browsers, ohne die Seite neu zu laden. Dies verhindert, dass Suchmaschinen Navigationsereignisse als neue Seiten erkennen.

Bots können annehmen, dass der Benutzer sich noch auf derselben Seite befindet, was die Indexierung neuer Ansichten [einschränkt].

Im Gegensatz zu mehrseitigen Websites müssen SPAs diese Übergänge simulieren, damit SEO-Tools sie erkennen. Ohne dies wird inhaltsabhängiger Inhalt übersehen oder falsch klassifiziert.

7. Verzögerte Darstellung von Inhalten

SPAs verzögern den sichtbaren [Inhalt] aufgrund mehrerer JavaScript-Abhängigkeiten und asynchronem [Laden].

Aufgrund dessen können Suchmaschinen-Crawler die Seite verarbeiten, bevor "wesentliche Daten" erscheinen.

Lange Renderzeiten können zu [teilweiser] Indexierung, fehlenden [Überschriften] und unvollständigen [Seitenauszügen] führen.

Wenn "sinnvoller" Inhalt während des Crawlens nicht bereit ist, nehmen Suchmaschinen an, dass die Seite keinen Wert hat oder die Seite als "dünner Inhalt" betrachten könnte.

Dies [reduziert] letztendlich "Rankings", "Sichtbarkeit" und "Traffic".

Fazit

SEO "richtig" für "Single Page Applications" zu machen, ist nicht einfach.

Suchmaschinen müssen sofort echte Inhalte sehen, nicht darauf warten, dass Skripte sie im Nachhinein laden. Daher sollten Sie korrektes HTML senden, jede Route wie eine echte Seite behandeln und die Titel und Beschreibungen aktualisieren, während der Benutzer durch die App navigiert.

Sie [müssen] auch Statuscodes verwalten, interne Links [erstellen], strukturierte Daten [hinzufügen] und sicherstellen, dass Suchmaschinen jede [Teil] der Seite crawlen können. Wenn alles an seinem Platz ist, wird Ihre Single-Page-Anwendung einfacher zu indizieren und einfacher zu ranken.