At få din single page app (SPA) opdaget af søgemaskiner er ingen let bedrift. SEO for single page applikationer hjælper dine webapplikationer med at få flere organiske visninger.

HTML-baserede websites er lettere at tilgå, gennemgå og indeksere, fordi de giver en struktureret markup for crawlere.

Derfor kan det at have dit indhold i HTML-sider føre til bedre søgerangeringer, og de er lettere at optimere end enkelt-sides apps.

SPAs er stærkt afhængige af JavaScript til dynamisk at omskrive indhold baseret på en besøgendes handlinger på siden (tænk på "udvidelig tekst" eller "pop-up bokse").

Derfor gør det det vanskeligt for Googlebots at indeksere sidens indhold, da det ikke kører "client-side JavaScript" indhold.

I denne artikel vil jeg diskutere de reelle udfordringer ved at bruge SPAs og dele den komplette proces for at lave SEO for "single page apps" for at opnå bedre søgeplaceringer.

Vigtige punkter

- SEO for "single page applications" er essentiel, fordi JavaScript-drevne SPAs ofte skjuler nøgleindhold fra crawlere.

- Brug server-side rendering (SSR) eller forud-rendering til at give crawlere fuldt renderede HTML-versioner af dine sider.

- Dynamiske titler, meta-beskrivelser og kanoniske tags er afgørende for single page application SEO for at forhindre duplikeret indhold og opretholde relevans på tværs af ruter.

- Kombiner interne links, rene URL'er, XML-sitemaps og korrekte HTTP-statuskoder for at hjælpe søgemaskiner med at opdage og indeksere alle nøgle-ruter inden for din SPA.

Hvad er SEO for Single Page Applications (SPA)?

"Søgemaskineoptimering" for [single page apps] refererer til processen med at gøre SPAs, bygget med JavaScript frameworks såsom React.js, Angular.js eller Vue.js, tilgængelige og indekserbare af søgemaskiner.

SEO for "enkelt" side apps inkluderer:

- "Server-side rendering" eller "pre-rendering"

- "Title tags", "meta descriptions", og optimering af strukturerede data

- URL og kanonisk tag optimering

- Intern linkoptimering

- Oprettelse og indsendelse af sitemap

- Linkbuilding

Google, Bing, Baidu, DuckDuckGo, og andre søgemaskiner har svært ved at "crawle" og indeksere JavaScript-indhold, da SPAs "indlæser indhold dynamisk" på klientsiden.

Derfor består SPA SEO af strategier og bedste praksis for at forbedre "discoverability" og "web presence" af "[single page apps]" i søgemaskiner.

Eksempler på "Single Page Applications"

Her er de bedste eksempler på SPAs:

Gmail

Gmail er et skoleeksempel på en SPA. Når du logger ind, bliver hele brugergrænsefladen, inklusive din "indbakke", "mapper" og "chat", indlæst én gang.

Fra det punkt fremad kræver "browsing" af "emails", åbning af tråde eller komponering af nye beskeder ikke en fuld sideopdatering.

JavaScript håndterer "routing" og indholdsændringer bag kulisserne, hvilket gør oplevelsen hurtig og gnidningsløs.

Google bruger asynkrone forespørgsler til at hente kun de nødvendige data, hvilket reducerer latenstid og forbedrer brugeroplevelsen.

Google Maps

Google Maps tilbyder rige interaktive funktioner såsom "panorering", "zoomning" og "søgning [efter] placeringer", alt sammen på den samme side.

Det "genindlæser" ikke, når du anmoder om nye [vejledninger] eller skifter mellem satellit- og kortvisninger.

I stedet hentes data via AJAX, og kortfliser eller UI-komponenter opdateres dynamisk. Dette får Google Maps til at føles ekstremt responsivt og anvendeligt, selv over langsommere forbindelser.

Selvom det ikke er 100% SPA, bruger store dele af Facebook SPA-arkitektur.

Når brugere ruller gennem deres nyhedsfeed, åbner opslag, reagerer eller kommenterer, sker alle opdateringer uden en sidegenindlæsning.

Selv når man skifter mellem sider som "Beskeder", "Notifikationer" og "Marketplace", bruger siden klient-side routing med JavaScript-rammer (som React) til dynamisk at gengive indhold, hvilket reducerer serverkald og forbedrer indlæsningstid.

Netflix

Netflix’s web interface er en anden højprofileret SPA. Når du gennemser film- eller tv-programforslag, "afspilles" trailere automatisk, og "indholdets" detaljer vises straks uden genindlæsning.

Klik på en titel åbner en modal overlay eller nyt [visning] samtidig med at den [kerne] [grænseflade] forbliver intakt.

Routingen, "anbefalingerne", og [ændringer] i brugerprofilen styres af JavaScript, hvilket giver en "konsekvent oplevelse" med lave ventetider.

Er en Single Page Application God til SEO?

Ja, en "single page application" er god for SEO, hvis du kender de rigtige optimeringstips til SPAs.

Søgemaskiner som Google kan gengive JavaScript, men de [kan] forsinke crawling eller springe over [indhold], der kræver brugerinteraktion.

For at undgå det, kan du bruge server-side rendering, statisk site-generering, ren URL-routing og dynamiske metadata-opdateringer.

Værktøjer som Next.js, Nuxt.js, React Helmet og Vue Meta hjælper med at få alt det til at "fungere".

Med den rette opsætning kan en SPA rangere lige så godt som ethvert traditionelt site. Dog, uden de rette SEO-justeringer, kan søgemaskiner gå glip af meget af det, du har bygget.

Relateret læsning: Hvordan man udfører SEO for dynamisk [indhold]

Hvordan man laver SEO for [Single Page Applications]

Her er de bedste SEO-løsninger til "single page web apps":

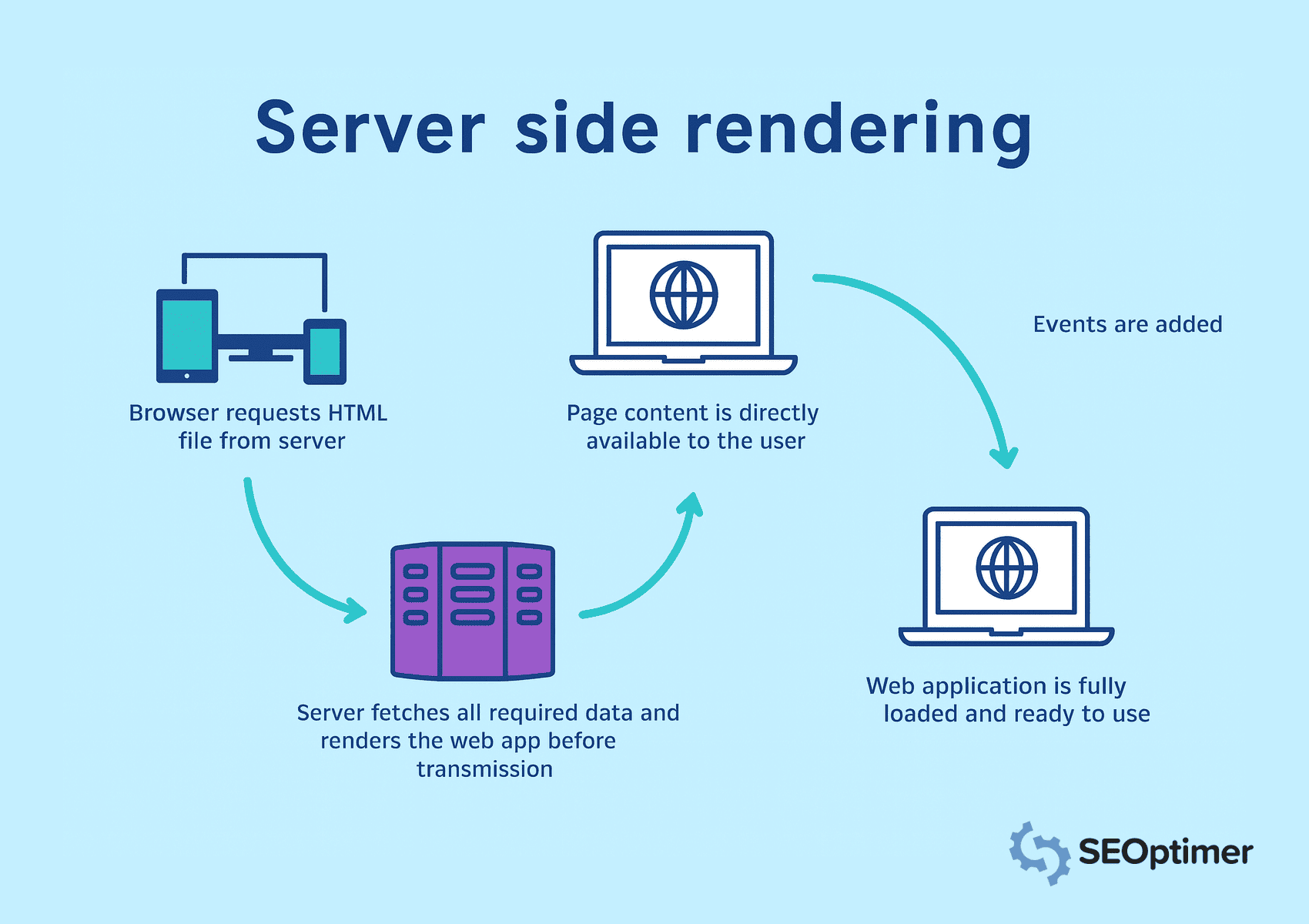

Brug server-side rendering (SSR)

"Single page applications" [afhænger] af JavaScript til [dynamisk at indlæse] "indhold".

Men søgemaskiner forventer komplet server HTML i HTTP-svaret for at få adgang til, gennemgå og indeksere "indhold".

Derfor bør du implementere "server-side rendering" for at gengive sider på serveren, før de sendes til browseren.

I server-side rendering, anmoder browseren om HTML-filer, og serveren henter alle dataene. Det sikrer, at alt indhold er umiddelbart synligt og kan gennemsøges.

Cache ofte tilgåede sider for at reducere indlæsningstider og levere indhold hurtigere. Undgå "client-side rendering" for nøgleelementer, da søgemaskiner måske ikke kan behandle JavaScript-tunge visninger.

Implementer "Pre-Rendering" for [Static Routes]

Du bør forud-rendere ruter, der viser det samme indhold til hver besøgende. Det giver dig mulighed for at generere HTML på byggetidspunktet og fjerner behovet for runtime rendering.

Som et resultat kan søgemaskiner få adgang til siden øjeblikkeligt.

Værktøjer til statisk generering fra frameworks som Next.js eller Nuxt.js kan hjælpe dig med at oprette statiske filer til ruter som "landingssider", "blogs" eller "produktoversigter".

Du bør levere disse forudrenderede sider gennem et Content Delivery Network eller webserver for at forbedre indlæsningshastighed og synlighed. Undgå at anvende forudrendring på visninger med "real-time" eller bruger-specifikke data.

Tilføj Ren og Gennemsøgbart HyperText Markup Language Output

Du bør generere velstruktureret HyperText Markup Language output, som søgemaskiner nemt kan fortolke.

Ren "markup" hjælper bots med at forstå sideopsætningen, hierarkiet og nøgleelementerne uden at være afhængig af "JavaScript"-udførelse.

Undgå at injicere indhold dynamisk efter sidens indlæsning. I stedet skal du sikre, at vigtig tekst, overskrifter, og links vises direkte i kildekoden.

Når du arbejder med SEO for en enkelt side app, er det vigtigste at huske, at Google ikke altid ser din side på samme måde som mennesker gør. Fordi de indlæser indhold med JavaScript, får crawleren nogle gange bare en blank side. Så sørg for, at det du vil have Google til at læse, faktisk vises i html.

- Ciara Edmondson, SEO & "Content Manager" hos Max Web Solutions

Brug semantiske tags som <header>, <main>, <article>, og <footer> til at give klar struktur.

Du bør også minimere inline-stilarter og script-rod, der kunne skjule meningsfuldt indhold.

Hold dokumentet "læsbart" og let for hurtigere crawling og bedre indeksering.

Brug "server-side rendering" eller "pre-rendering" til at producere statisk HTML for hver rute. Det garanterer, at crawlers får adgang til det fulde sideindhold ved den indledende anmodning.

Eksponér [statiske snapshots] for [crawlere]

Du bør eksponere statiske snapshots for at sikre, at crawlere kan få adgang til komplet indhold, især når klient-side rendering forsinker sideoutput.

Et statisk øjebliksbillede er en fuldt gengivet version af siden genereret på forhånd og serveret specifikt til bots.

Denne "taktik" er nyttig, når server-side rendering eller præ-rendering ikke er mulig på tværs af hele "applikationen".

Snapshots giver en alternativ vej for crawlere til at få adgang til struktureret HyperText Markup Language uden at udføre JavaScript.

Du [bør] konfigurere serveren til at [detektere] brugeragenter som Googlebot og [servere] forudbyggede snapshots til de anmodninger.

Værktøjer som Rendertron, Prerender.io, eller brugerdefinerede headless NodeJS renderers kan hjælpe med at generere og levere "snapshots" pålideligt.

Sørg for, at hvert øjebliksbillede afspejler det fulde indhold og strukturen af siden, inklusive titler, metadata, links og schema-markup.

Safira fra Somar Digital, et bureau baseret i New Zealand, anbefaler, at alle SPAs bør bruge "schema markup" til deres SEO.

Jeg anbefaler at bruge struktureret data schema markup for SPAs. Integrer relevante schema markups som [organisation], [webside], [brødkrummeliste], [FAQ] osv.

Jeg har bemærket, at nogle gange vises schema markup måske ikke i kildekoden eller endda i Google Rich Results Test, men hvis du tester schema ved hjælp af schema markup validatoren, vil du se tilføjede schema markups i resultaterne. Dette sker fordi SPAs, der indsætter Schema (via JavaScript), ikke har dette tilgængeligt ved den [indledende] indlæsning. Men Google er i stand til at læse JavaScript, da det er "headless".

- Safira Mumtaz, SEO/SEM Specialist hos Somar Digital

Du bør også overvåge indeksdækning for at bekræfte, at crawlere behandler "snapshots" som [forventet].

At servere statiske snapshots forbedrer synligheden for sider med kompleks renderingslogik, hvilket hjælper med at opretholde ensartet indeksering og SEO-værdi.

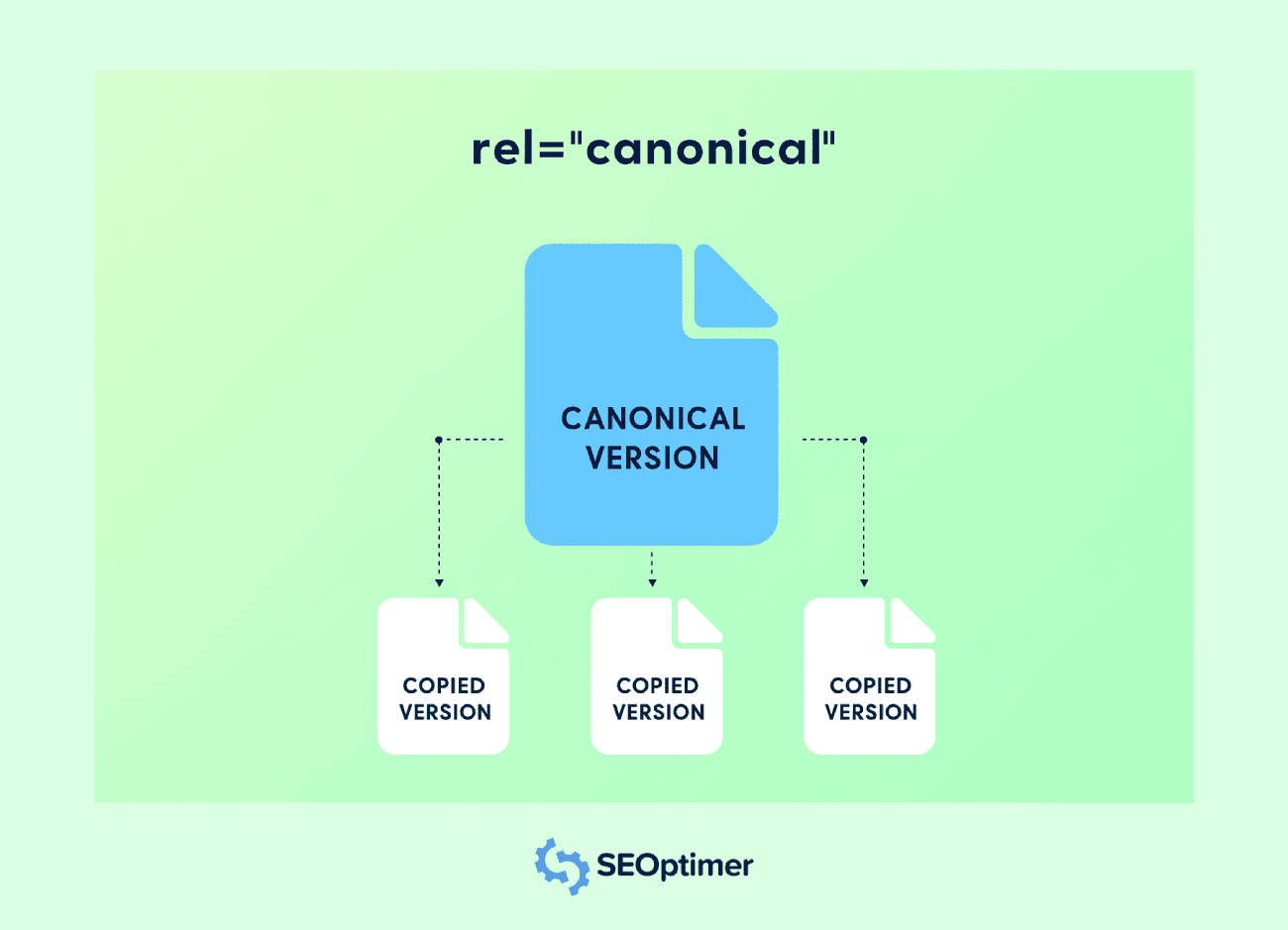

[Opsæt] [kanoniske] [tags] for hver visning

Du bør angive et kanonisk tag for hver rute i en enkelt side applikation for at undgå problemer med duplikeret indhold.

Det meste af tiden vil SPAs generere flere tilgængelige URL'er for det samme indhold.

For eksempel kan det samme indhold være til stede i URL'er med forskellige "query strings", "filters" eller "tracking parameters". "Canonical tags" hjælper søgemaskiner med at forstå den foretrukne version.

Hver rute bør inkludere et <link rel="canonical">-tag, der peger på den originale URL for den visning. Det forhindrer linkværdiudvanding blandt forskellige URL'er med det samme indhold.

Du bør indsætte kanoniske tags dynamisk, når ruten ændres, især hvis applikationen opdaterer metadata på klientsiden.

Brug "routing hooks" eller "middleware funktioner" til at tildele den korrekte [tag] ved hver [sideovergang].

Undgå at pege alle ruter til hjemmesiden eller bruge en statisk kanonisk værdi. Hver unik visning bør afspejle sin egen logiske URL for at bevare relevans og nøjagtighed i indekseringen.

Implementering af korrekt kanoniskisering understøtter klarere indeksering, forbedrer sideautoritet og forhindrer uønsket duplikering i søgeresultater.

Håndter 404 og Andre Statuskoder Korrekt

Du bør konfigurere korrekte statuskoder for alle visninger i en "single page application" for at hjælpe søgemaskiner med at fortolke din [sites] struktur korrekt.

Mange SPAs serverer en standard HTML-shell for hver anmodning, hvilket kan returnere en 200 OK selv for ikke-eksisterende ruter.

Et korrekt 404 Not Found svar bør returneres for ugyldige URL'er.

Brug serverlogik eller middleware i NodeJS til at opdage "[umatchede ruter]" og sende den korrekte "[statuskode]" sammen med en "[brugerdefineret fejlside]".

Du bør også håndtere andre svar som 301 eller 302 for "omdirigering" og 500 for "serverfejl".

Disse statuskoder informerer søgemaskiner om, hvordan de skal behandle hver anmodning og opretholde integriteten af din "crawl" og indekseringsdækning.

Undgå at stole udelukkende på "client-side" [fejlhåndtering]. Crawlers [måske] ikke [udfører] JavaScript, så forkerte statusresponser kan skade "search engine optimization" [signaler] og vildlede indeksering.

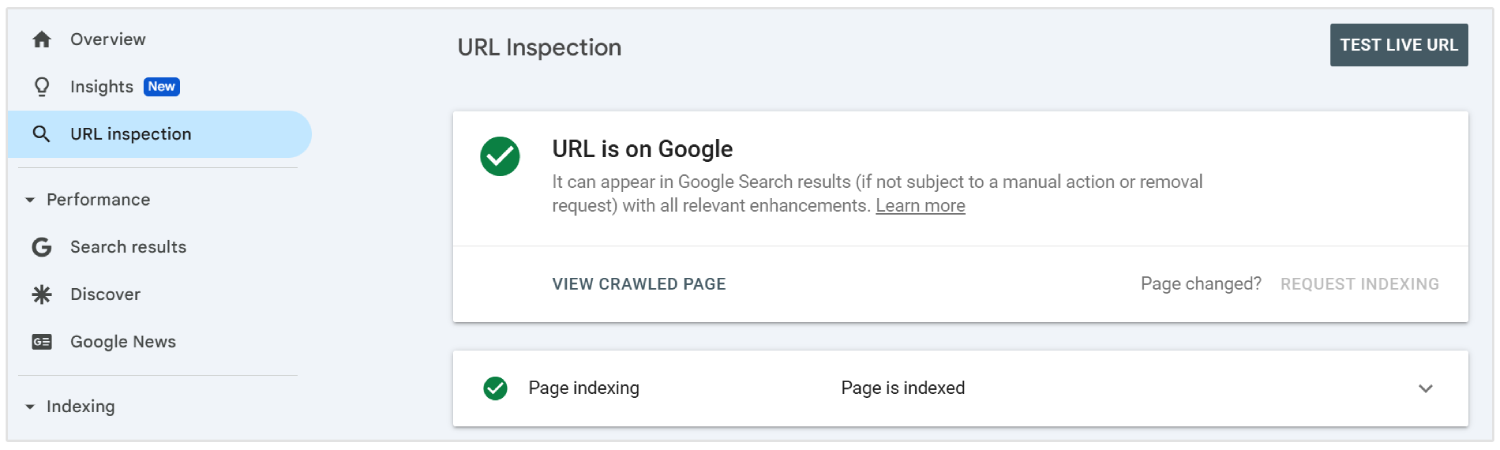

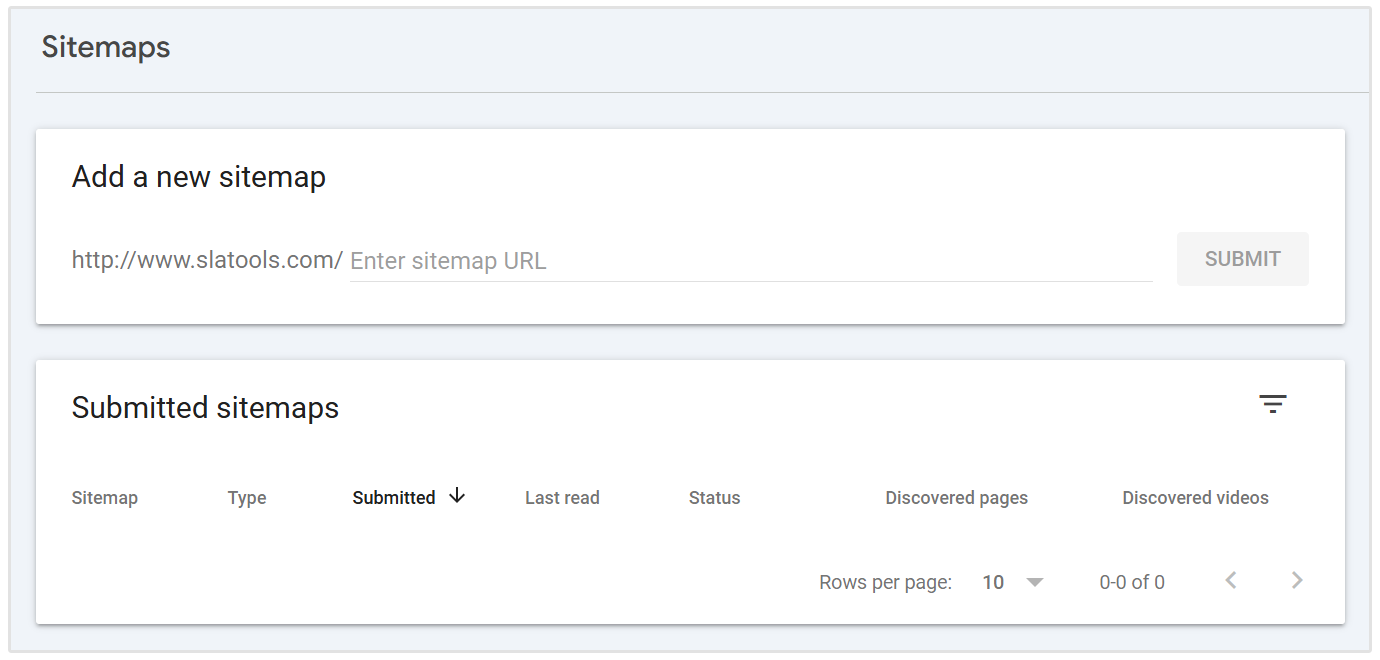

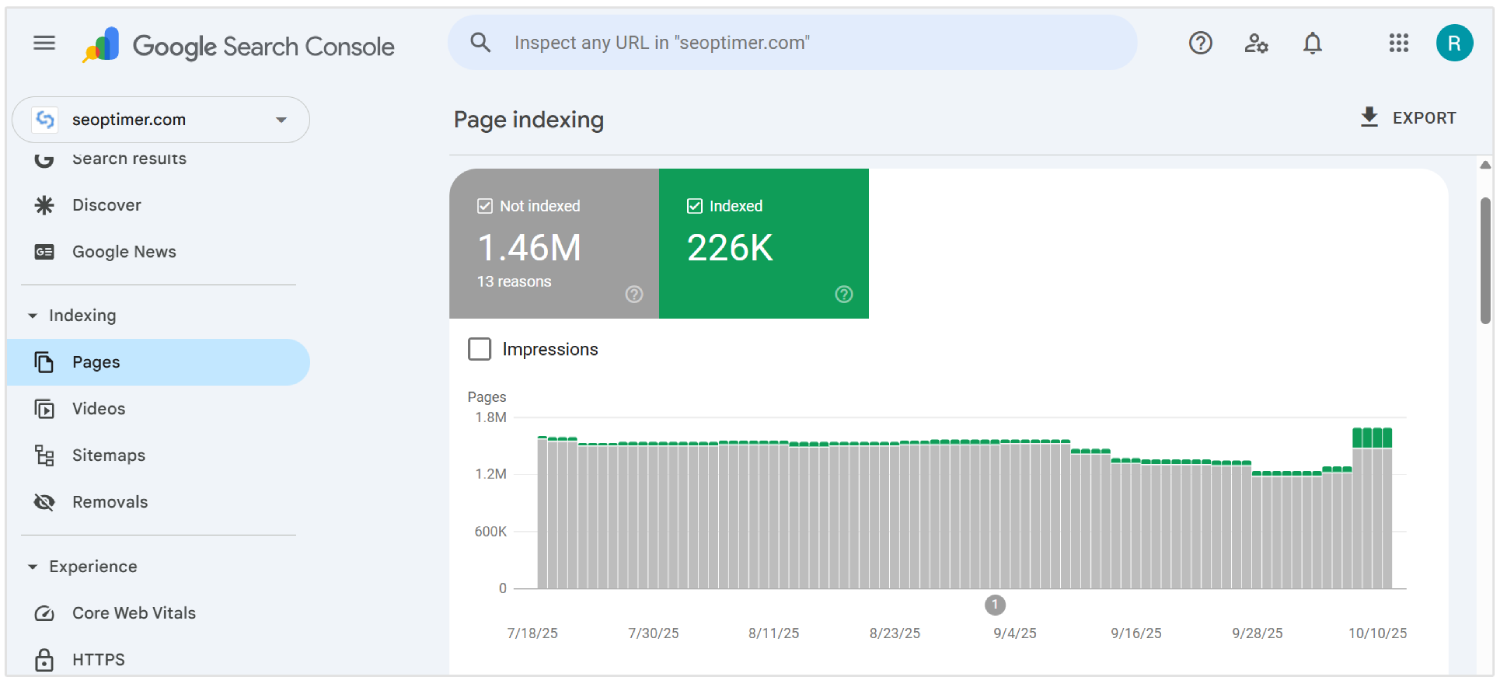

Indsend "dynamiske URL'er" til Google Search Console

Du bør indsende alle vigtige dynamiske URL'er fra en enkelt side applikation til Google Search Console ved hjælp af URL-inspektionsværktøjet. Det hjælper søgemaskinebots med at opdage og indeksere indhold, der måske ikke vises i en traditionel gennemgang.

Da SPAs indlæser indhold gennem klient-side routing, kan nogle interne sider ikke findes af crawlere uden direkte linking.

For at sikre synlighed, [list] disse URLs i et XML-sitemap og [submit] det gennem konsolgrænsefladen.

Du bør opdatere sitemap, hver gang nye ruter tilføjes eller ændres. Hver post skal afspejle den endelige, rene URL, som brugere og crawlere ser, ekskluderende hash-tegn eller unødvendige parametre.

Indsendelse af dynamiske URL'er giver Google et klart kort over din applikations struktur og forbedrer chancerne for nøjagtig gennemgang og hurtigere indeksering.

Aktivér "Lazy Loading" med "Fallbacks"

Du bør aktivere "lazy loading" for at forbedre ydeevnen i SPAs ved at udsætte indlæsningen af ikke-essentielle elementer såsom billeder, videoer eller sektioner under skærmens synlige del.

Det hjælper med at reducere den indledende indlæsningstid og forbedrer brugeroplevelsen på tværs af desktop- og mobilvisninger.

Søgemaskiner kan muligvis ikke udløse indhold, der indlæses gennem JavaScript, hvilket kan føre til manglende indeksering.

Du bør give [tilbagefald] som "pladsholderindhold" eller <noscript>-tags for at sikre, at alle [nøgleelementer] forbliver synlige for [crawlere].

Brug native browserfunktioner såsom loading="lazy" attribut eller administrer [rullebaseret] indlæsning gennem JavaScript. Du bør altid bekræfte synlighed ved hjælp af værktøjer som Google Search Console.

Undgå at forsinke vigtigt indhold eller links, der bidrager til søge synlighed. Korrekt brug af "lazy loading" med pålidelige reservemuligheder understøtter hurtigere indlæsningshastighed og komplet indholds dækning.

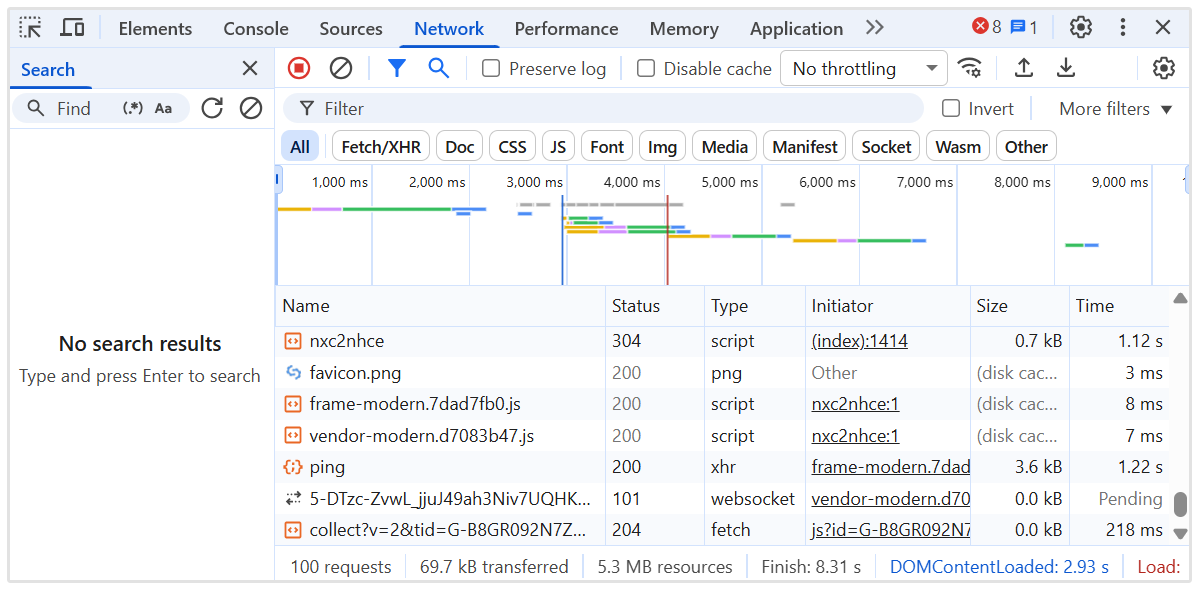

Udsæt Ikke-Kritisk JavaScript

Du bør udskyde ikke-kritisk JavaScript for at fremskynde den indledende sidegengivelse og reducere blokeringen af vigtigt indhold i enkelt-side-applikationer.

Scripts, der ikke er afgørende for indholdet "above-the-fold", kan forsinke både brugerinteraktion og crawler synlighed.

Brug "defer" eller "async" attributterne i script tags for at forhindre unødvendig udførelse under den første sideindlæsning.

Placer "ikke-essentielle" scripts i slutningen af dokumentet eller indlæs dem efter at "kerneindholdet" er blevet gengivet.

Du bør identificere hvilke scripts der påvirker "layout", "metadata" eller "routing logic", og adskille dem fra "analytics", "chat widgets" eller "animations".

Værktøjer som Lighthouse og Chrome DevTools kan hjælpe med at [revidere] scriptadfærd og [indlæse] sekvens.

Implementer intern linking mellem SPA-ruter

Du bør skabe en klar intern linkstruktur mellem alle ruter i en enkelt side-applikation for at guide crawlere gennem siden.

I modsætning til traditionelle websites, er SPAs afhængige af navigation på klientsiden, hvilket kan forhindre søgemaskiner i at opdage alle interne sider, hvis links ikke tilføjes korrekt.

Brug anker-tags med korrekte href-attributter, der afspejler den faktiske sti, ikke bare JavaScript-funktioner eller knapper. Undgå at bruge elementer som onClick-handlere uden meningsfulde URL'er, da disse ignoreres af crawlers (for det meste).

Du bør sikre, at hver vigtig side er linket fra andre dele af applikationen, især fra hjemmesiden og sider med høj autoritet. Det hjælper med at overføre relevans- og autoritetssignaler for effektiv crawling.

Oprethold en logisk hierarki med navigationsmenuer, brødkrummer og kontekstuelle links mellem relaterede visninger. Brug beskrivende ankertekst til at forstærke sidetemaer.

"Intern linking" forbedrer "crawl depth", distribuerer "authority", og styrker den samlede "search engine optimization" [performance] på tværs af hele applikationen.

Brug et "sitemap", der afspejler alle vigtige ruter

Du bør generere og indsende et "sitemap", der inkluderer hver vigtig rute i [single page application].

Da SPAs bruger klient-side routing, er mange interne [visninger] muligvis ikke [mulige at finde] gennem traditionel crawling.

Opret et XML-sitemap, der opregner alle statiske og dynamiske ruter beregnet til indeksering. Inkluder kun rene, kanoniske URL'er uden unødvendige parametre, fragmenter eller sessionsdata.

Du bør opdatere "sitemap", når nye ruter tilføjes, fjernes eller ændres. Automatiseringsværktøjer kan regenerere "sitemap" under hver implementering for at holde det nøjagtigt.

Indsend "sitemap" i Google Search Console for at hjælpe søgemaskiner med at finde og prioritere vigtig [indhold]. Dette understøtter fuld [indeks]dækning og forstærker rute-niveau synlighed.

Et velholdt sitemap forbedrer "crawl-effektivitet" og sikrer, at "kritiske visninger" får den opmærksomhed, de har brug for.

Overvåg "crawl" adfærd med serverlogfiler

Du bør analysere serverlogfiler for at forstå, hvordan søgemaskiner interagerer med din "Single Page Application".

Logfiler afslører, hvilke ruter der bliver crawlet, hvor ofte de tilgås, og om bots støder på fejl eller forsinkelser.

Gennemgå HTTP-statuskoder, brugeragenter og tidsstempler for at opdage indekseringshuller eller ineffektivitet i crawling.

Kig efter tegn på [manglende] indhold, gentagne [besøg] på irrelevante sider eller mislykkede svar, der kunne skade synligheden.

Du bør spore, hvordan Googlebot navigerer gennem dynamiske ruter og verificere, at vigtige [visninger] modtager crawl-opmærksomhed. Kombiner logdata med [indsigter] fra værktøjer som Google Search Console for at krydstjekke indekseringsdækning.

Brug værktøjer til analyse af serverlogfiler eller eksportér data fra dit NodeJS-servermiljø for dybere indsigt.

Overvågning af realtids botaktivitet hjælper med at identificere "crawl"-spild, løse problemer med [discoverability], og optimere den samlede SPA SEO-præstation.

Løs "Rendering Issues" med dynamisk indhold

Du bør løse "rendering issues" i "single page applications" for at sikre, at dynamisk indhold er fuldt synligt for søgemaskiner.

Indhold, der afhænger af JavaScript-udførelse, kan "mislykkes" i at vises under gennemsøgning, hvis det indlæses for sent eller kræver brugerinteraktion.

Revider hver rute for at bekræfte, at vigtig tekst, links og overskrifter er tilgængelige i den gengivne output. Brug værktøjer som Googles URL Inspection Tool eller Lighthouse til at opdage indhold, der mangler fra den indledende rendering.

Du bør anvende teknikker såsom server-side rendering eller pre-rendering for at levere fuldt byggede sider, hvor det er nødvendigt.

For "client-side rendering", sørg for, at data [loads] hurtigt og ikke afhænger af forsinkede [triggers].

Undgå at injicere kritisk information, efter at crawleren allerede har behandlet siden. Forsinkelser i gengivelsen kan føre til delvis indeksering eller udelukkelse fra søgeresultaterne.

At rette gengivelsesproblemer sikrer fuld synlighed af [vigtigt] indhold, understøtter bedre indeksering og styrker de overordnede resultater inden for søgemaskineoptimering for SPAs.

Justér JavaScript-udførelse med crawler-funktioner

Du bør strukturere JavaScript-udførelse for at matche behandlingsgrænserne for moderne crawlere, især Googlebot's gengivelseskø og ressourcebegrænsninger.

Crawlere opererer med et tidsbudget for hver URL. Derfor kan overdrevne afhængighedskæder, asynkron datahentning eller logik, der blokerer for rendering, resultere i ufuldstændig indeksering af vigtige sider.

Prioriter at gengive kritisk sti-indhold under den indledende male fase. Undgå indlejrede hydratiseringslag, forsinkede DOM-mutationer eller overdreven brug af klient-kun komponenter.

Erstat "runtime content injection" med "server-prefetched data" eller "skeleton layouts", hvor fuld server HTML ikke er muligt.

Du bør kontrollere udførelsestiming ved hjælp af værktøjer som Chrome DevTools Performance panel og simulere crawlerbetingelser med Puppeteer eller headless NodeJS-renderers.

Spor "tid til interaktiv" (TTI), "største indholdsfulde maling" (LCP) og "total blokerings tid" (TBT) under [ingen-cache] forhold.

Sørg for, at rute-specifikke metadata, kanoniske tags og skema er monteret synkront. Reducer afhængigheden af tunge biblioteker eller runtime-routing-frameworks, der forsinker meningsfuld render-output.

Revidér SEO-ydeevne med specialiserede værktøjer

Du bør regelmæssigt revidere din "søgemaskineoptimering" ydeevne for at opdage synlighedsproblemer i "single page applications".

Standard browser-baserede kontrolmiss [problemer] unikke for JavaScript-tunge miljøer.

Brug af avancerede værktøjer giver dyb indsigt i, hvordan sider "rendes", indekseres og vurderes af søgemaskiner.

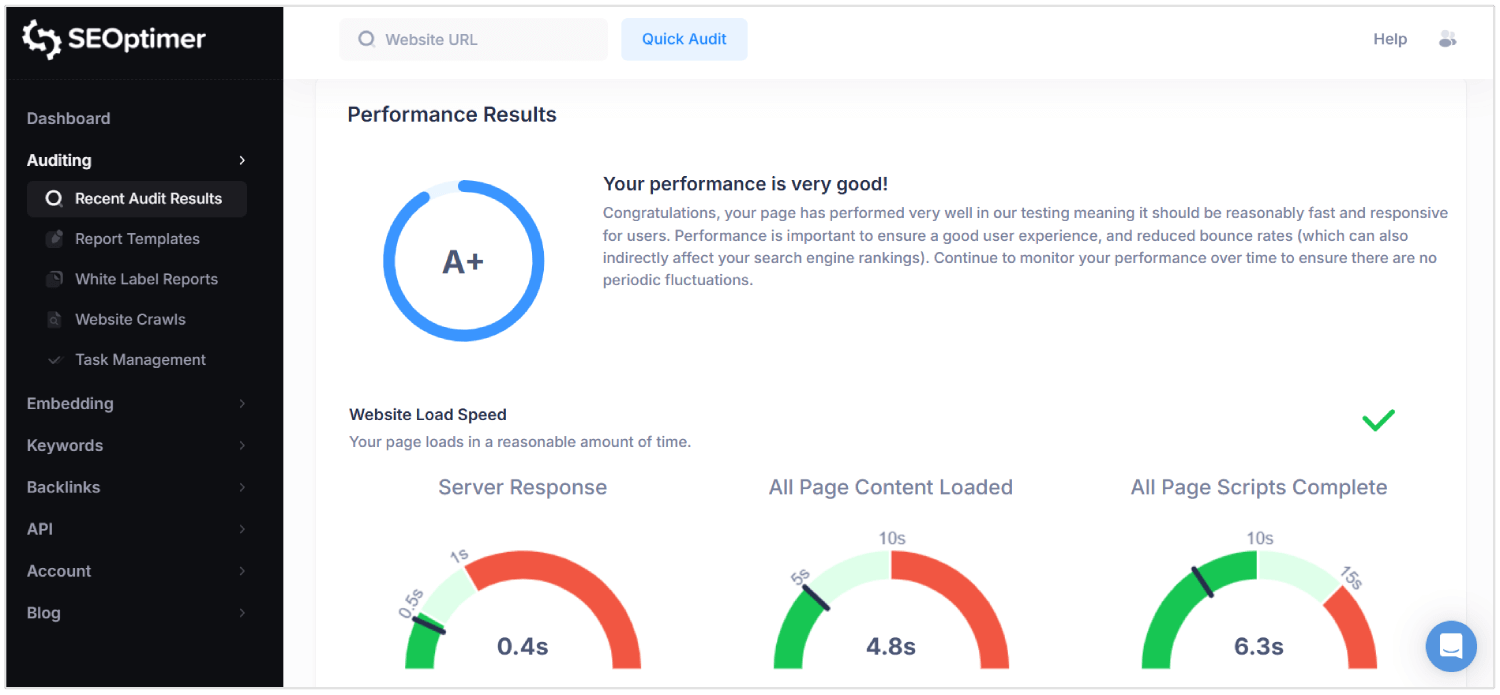

SEOptimer er et sådant værktøj, der udfører omfattende revisioner på tværs af tekniske, on-page og ydelseslag.

Det scanner hver side for metadata-kvalitet, mobilvenlighed, intern linkstruktur og forholdet mellem indhold og kode.

For SPAs, SEOptimer hjælper med at identificere manglende HyperText Markup Language-elementer, forkert konfigurerede kanoniske tags og svage headerstrukturer, der påvirker [crawlability].

Du bør køre SEOptimer-revisioner efter implementering af større opdateringer eller lancering af nye ruter. Værktøjet markerer "rendering delays", "broken links", og "JavaScript dependencies" der forhindrer indhold i at indlæses korrekt.

Kombiner SEOptimer med værktøjer som Google Search Console og loganalysatorer for at validere resultater under "real-world crawl" betingelser.

Regelmæssig revision sikrer, at routing-logik, indholdslevering og rendering-adfærd alle understøtter vedvarende SEO-præstation.

Hvorfor SEO er udfordrende for SPAs

SEO er "vanskelig" for "single page apps", fordi metadata, rutespecifikt indhold og korrekte statuskoder muligvis bliver overset eller misforstået af crawlere.

Her er de største SEO-udfordringer for SPAs:

1. "Client-Side" Rendering

Søgemaskiner forventer, at "meningsfuldt indhold" er til stede i det oprindelige HTML-svar. SPAs er afhængige af JavaScript til at gengive indhold efter, at siden [indlæses], hvilket forsinker synligheden.

Hvis en crawler får adgang til siden, før rendering er færdig, "kan" nøgleelementer som tekst og links muligvis ikke blive behandlet. Dette skaber en risiko for, at søgemaskiner indekserer ufuldstændige eller tomme sider.

Som et resultat når indhold, som brugerne kan se, aldrig søgeresultatmotorens resultater.

2. Begrænsninger for "crawling"

SPAs "udsætter" ikke alle sider gennem traditionelle statiske links, hvilket gør [gennemsøgning] mere kompleks.

Mange sider er kun tilgængelige gennem intern klient-side "navigation", som søgebots muligvis ikke følger.

Selv moderne crawlere som Googlebot gengiver JavaScript med forsinkelser og begrænset behandlingstid. Sider, der kræver flere gengivelsescyklusser eller indlejret datahentning, kan overstige [crawling budgettet].

Vigtige "visninger" kan blive helt overset, hvilket svækker sidens synlighed i "søgeresultater".

3. Dynamisk [metadata] håndtering

Hver visning i en SPA mangler unik [metadata], medmindre det konfigureres manuelt.

Uden dynamiske opdateringer til titler, beskrivelser og kanoniske tags, fremstår alle URL'er identiske for søgemaskiner.

Dette fører til indekseringsfejl, reduceret relevans og lavere klikfrekvenser.

Metadata knyttet til URL-ændringer skal indsættes i realtid ved hjælp af biblioteker eller brugerdefineret logik. [Manglende] "håndtering" af dette blokerer applikationen fra at rangere korrekt på tværs af forskellige søgeforespørgsler.

4. Ikke-standard URL-strukturer

SPAs kan bruge URL'er, der afhænger af hash-fragmenter eller browserhistorik-manipulation. Disse formater kan skabe forvirring for søgemaskiner, der foretrækker "rene", kanoniske stier.

Hvis en rute mangler en ordentlig struktur, kan den muligvis ikke blive indekseret eller kan blive behandlet som en [duplikat].

"Inkonsekvente" URLs "bryder også dybe links", hvilket er "kritisk for brugernavigation og crawl-dybde".

SEO-ydeevne lider, når bots ikke kan fortolke eller få adgang til rigtige, adskilte URL'er.

5. [Forkerte] HTTP-statuskoder

I modsætning til traditionelle sider svarer SPAs med 200 OK, selv for ikke-eksisterende "ruter".

Dette vildleder søgemaskiner til at indeksere fejlsider eller irrelevant indhold.

Uden korrekte koder som 404 Ikke Fundet eller 301 Omdirigering kan "crawlers" ikke fjerne forældede sider eller følge nye stier.

Bots kræver nøjagtige statussignaler for at fortolke [webstedets] struktur og ændringer i [indhold].

SPA'er der "håndterer" disse svar forkert, mister kontrollen over hvordan deres indhold "vises" i [søgeresultater].

6. Ingen sideopdateringer under navigation

I SPAs sker ruteskift inden for browseren uden at genindlæse siden. Dette forhindrer søgemaskiner i at genkende navigationsbegivenheder som nye sider.

"Bots [kan] antage, [at] brugeren stadig er på den samme side, hvilket begrænser indekseringen af nye visninger."

I modsætning til multi-page sites skal SPAs simulere disse overgange for at SEO-værktøjer kan registrere dem. Uden dette bliver rute-specifikt indhold overset eller fejlagtigt klassificeret.

7. Forsinket [rendering] af [indhold]

SPAs forsinker synligt indhold på grund af flere JavaScript-afhængigheder og asynkron indlæsning.

På grund af dette kan søgemaskinecrawlere behandle siden, før "vigtige" [data] vises.

Lange "rendertider" kan resultere i "partiel indeksering", manglende overskrifter og ufuldstændige "sideoversigter".

Hvis meningsfuldt indhold ikke er klar under gennemgangen, antager søgemaskinerne, at siden mangler værdi eller kan betragte siden som "tyndt indhold."

Dette reducerer i sidste ende "rangeringer", "synlighed" og "trafik".

Konklusion

At få SEO rigtig for "enkelt-sides applikationer" er ikke enkelt.

Søgemaskiner skal se "rigtigt indhold" med det samme, ikke vente på, at scripts loader det bagefter. Derfor bør du sende korrekt HTML, behandle hver rute som en rigtig side og opdatere titler og beskrivelser, når brugeren bevæger sig gennem appen.

Du skal også håndtere statuskoder, opbygge interne links, tilføje strukturerede data og sørge for, at søgemaskiner kan crawle alle dele af [siden]. Når alt er på plads, bliver din "single page application" lettere at indeksere og lettere at rangere.