Du ved, når du bruger Google til at søge efter en tjeneste, eller finde information? Og når siden er indlæst, er der altid ét websted øverst.

Websteder på position 1 på Googles søgemaskineresultatside (SERP) får hovedparten af alle klik. Så det er unødvendigt at sige, det er vigtigt at følge SEO "best practices" for at forsøge at maksimere din sides position i SERP.

Men ved du, hvordan Google overhovedet finder dit "site" i første omgang?

Svaret er Google’s crawlers. Google’s crawlers er som små digitale robotter, der besøger websites og indsamler information om disse sites.

![Google-edderkop [gennemgår] en hjemmeside](/storage/images/2025/06/7018-Google spider crawling website.png)

Derefter indekserer Google al den information og bruger den til at forbedre sin søgealgoritme. Når nogen indtaster en forespørgsel i Google, gennemgår søgealgoritmen al den indekserede information for at finde de bedste resultater for personens forespørgsel.

Og det er sådan, Google er i stand til at bringe dig de bedste resultater, når du søger efter noget på internettet!

Hvad er en Google Crawler?

En Google Crawler er også kendt som en “robot” eller “spider,” (forstået, fordi de [crawle]) og de går fra website til website på jagt efter ny information til at gemme i deres databaser. Der er 15 slags crawlers, der bruges af Google, men den vigtigste er Googlebot.

Selvom Google er magtfuld, kan det ikke gøre alt; hver gang en ny webside oprettes, ved Google ikke om den, før siden er blevet crawlet.

Google bruger Googlebot til konstant at indhente den nyeste information til at gemme i sin database.

Google Indeksering vs Google Crawling

"Indeksering" sker kun efter, at "hjemmesiden" er blevet "crawlet" af GoogleBot. Når den bliver "crawlet", bliver den "scannet", og de oplysninger, der er "scannet" fra det [site] eller den [side], gemmes i "Google index".

"Indekset vil kategorisere og rangere siderne" i "overensstemmelse hermed i søgeresultaterne".

Hvorfor er Google Crawlers vigtige?

Så hvorfor er alt dette vigtigt?

Nå, lad os sige, at du driver en virksomhed og har en hjemmeside. Du vil have din hjemmeside så tæt på toppen som muligt. Hvis din hjemmeside ikke bliver [gennemgået] og scannet, [vil] den ikke [indlæses] på søgesiden.

Uden nogen internettilstedeværelse vil du ikke kunne nå dit publikum eller forbrugere. "Crawling" og "indeksering" gør det lidt lettere for websites at få noget opmærksomhed.

Hvordan en Google Crawler Fungerer

Så, du ved hvad det er, men hvordan fungerer det? Mens Google er "kraftfuld", kan den ikke gøre alt; hver gang en ny webside bliver oprettet, ved Google ikke om det, før den side er blevet [gennemgået]. Google bruger Googlebot til konstant at få tilføjet information til at gemme i sin database.

Når den webside er [gennemgået] eller scannet. Siden gengives og [tilføjes] en HTML, CSS, JavaScript og tredjepartskode, som alle er nødvendige for at Googlebot kan indeksere og rangere [websteder]. Googlebot, den største crawler, er i stand til at se og gengive alle websiderne og [websteder] med Chromium.

"Chromium" [opdateres] altid, så det kan forblive [stabilt] og udføre sit arbejde [nøjagtigt]. Dette er tilgængeligt for alle og kan også bruges til at teste nye funktioner og lave nye browsere.

Hvordan man gør din side lettere at "crawle"

Nu hvor vi ved, hvad vi arbejder med, lad os arbejde på at gøre din hjemmeside nem at blive crawlet.

Her er nogle tips og tricks til at gøre din hjemmeside til en crawler-magnet og stige til toppen på søgeresultatsiden.

Interne [links]

Interne links kan være din bedste ven til crawling. Din side er måske allerede blevet crawlet af Google i fortiden, men for nylig har du muligvis tilføjet flere sider. Hvis crawleren allerede kender dit websted, vil den kun fokusere på hovedsiderne.

Husk, Google bliver ikke underrettet, hver gang en ny side oprettes, den gennemgår for at finde disse sider.

Brug af interne links på hovedsider guider crawleren, hvor den [skal] gå hen. Det bedste sted for disse interne links er din hjemmeside, det er den side, der modtager mest trafik og hvor crawleren vil scanne først.

Tilbagekoblinger

Backlinks er en anden god måde at få din side crawlet på. Denne metode kan bruges til at “promovere” dit website til crawleren.

At linke til en mere populær hjemmeside vil øge dine chancer for at blive opdaget af crawleren.

Bemærk: Du kan nemt kontrollere backlink-profilen for enhver side, inklusive dine konkurrenter, ved hjælp af SEOptimer's gratis Backlink Research værktøj.

Billeder

Billeder kan gennemsøges, faktisk er der en specifik crawler kun for billeder. Denne crawler er kendt som Googlebot Image, og den indsamler billeder til databasen.

Sitemaps

Der er en måde at fortælle Google, hvilke sider du ønsker, de skal crawle mere direkte. Du kan indsende et sitemap med en detaljeret liste over de sider, du vil have crawlet af Google.

Brug vores XML Sitemap Generator til at opbygge et [sitemap] af hele din [website]. Lav det, navngiv det. Og download det til din computer for at uploade det til Google Search Console.

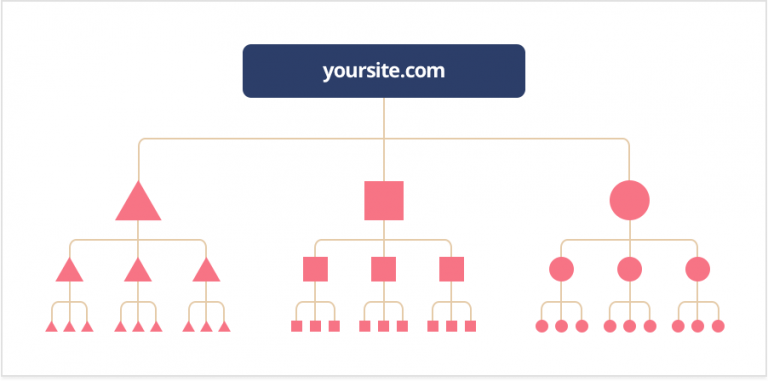

Klikdybde

"Klikdybde" (også kendt som "crawldybe") viser dig, hvor meget arbejde en crawler skulle udføre for at nå og scanne din side. Du ønsker aldrig, at crawleren skal gøre for meget arbejde, du vil have din side eller hjemmeside til at være så "crawler-venlig" som muligt.

Det bør tage omkring tre klik eller færre, jo flere det tager, jo mere [slows] det [down] crawleren.

En god struktur bør gøre det muligt for dig at tilføje nye sider uden at påvirke din "klikdybde". Crawleren bør stadig kunne nå disse sider let også.

Til orientering: En god tommelfingerregel er at sikre, at du kan navigere fra en side på dit websted til enhver anden side på dit websted med højst 3 klik. Dette sikrer, at Google kan finde og indeksere alle dine sider effektivt. Plus, det er godt for brugeroplevelsen.

Indekseringsinstruktioner

Der er instruktioner, som Google følger, når de crawler og ideation-sider. Robots.txt, noindex-tag, robots meta-tag, og X-Robots-Tag. Bare rolig, vi vil forklare dette for dig.

Robots.txt. er en rodmappefil, der tilbageholder visse sider og indhold fra Google. Når crawleren scanner en side, vil den kigge på dette for information. Hvis crawleren ikke kan finde denne information, vil den stoppe sin gennemgang, og siden vil ikke være en del af søgeresultaterne.

"Noindex tag" [forhindrer] alle typer af crawlers [fra] at kunne scanne og indeksere en side.

Robots meta tag, kan hjælpe med at kontrollere den måde, en side skal indekseres og indlæses for websurfere i søgeresultaterne.

X-Robots-Tag, er en del af HTTP-headeren og vil hjælpe med at kontrollere crawlerens adfærd. Den overvåger, hvordan hele siden indekseres. Du kan blokere billeder og videoer på en side ved hjælp af denne metode. Du kan også målrette individuelle crawlertyper, men kun hvis det er specificeret.

Hvis typen af crawler ikke er specificeret, vil instruktionerne være for alle Google crawlers.

URL-struktur

Du har måske hørt denne før, men sørg for at have en brugervenlig URL.

En URL, der er "nem", en som både dine forbrugere og algoritmer vil elske. Prøv at holde din URL så kort og enkel som muligt.

Hvis du har en lang URL, kan det være forvirrende ikke kun for det menneskelige øje, men også for Google-botten.

Jo mere forvirret Googlebot er, jo mere vil det udtømme sine "crawling" ressourcer, og det er bestemt ikke hvad du ønsker.

Almindelige problemer (og løsninger) med Google Crawling

Så, du har en side, men den "performer" ikke som du ønsker det. Dette kunne være fordi "crawleren" har svært ved at [scanne] og indeksere din side.

Her er et par almindelige problemer, som folk er stødt på med Google Crawling.

1. Google "crawler" ikke din [webside]

Sørg for, at du tjekker for at se, om din side eller dit site er "crawl venlig". Det betyder at have en god URL, inkorporere de interne og "backlinks" hvis nødvendigt, eller tage sig tid til at oprette et "sitemap" for at vise Googlebot hvor den skal "crawle".

Husk også, at det kan tage noget tid for Google at gennemgå og indeksere din hjemmeside, fordi den skal komme og finde dig!

2. Du er blevet fjernet fra Googles indeks

Google vil fjerne en [website], hvis det føler behov for det, hvad enten det er ved lov, relevans eller for ikke at følge de [guidelines], der er på plads. Brug vores SEO Crawler til at kontrollere for noget, der kunne blokere [crawleren] fra din side.

Når du har gjort det, kan du indsende dit website til Google for genovervejelse.

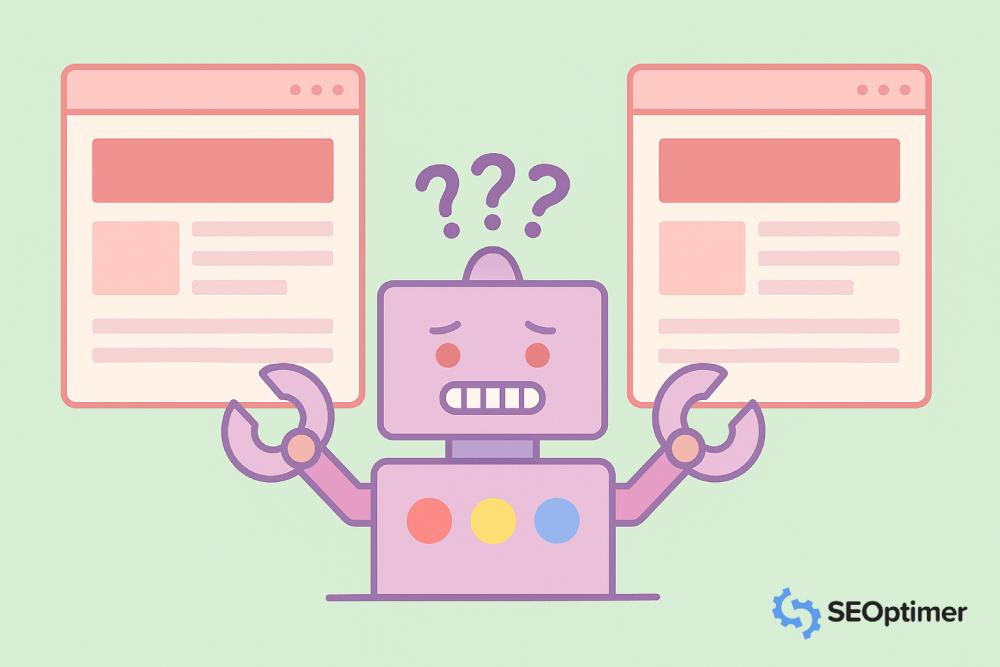

3. Du har "duplikeret indhold"

Duplikeret [indhold] er en [side], der har lignende [indhold] som en anden [side] eller flere URL'er, der linker til én [side].

I tilfælde af at have sider med lignende indhold, hvilket også kunne betyde, at du har en desktop- og mobilversion af én side. Dog er det mest almindelige eksempel på [duplikeret] indhold på et antal sider.

Disse kan både undgås og løses med en kanonisk URL, eller URL, der fungerer som repræsentant for disse duplikerede sider.

Google vil kun vise den side, som de mener har det mest nyttige indhold på, og betegne den som "kanonisk". Dette er den side, der vil blive crawlet i stedet for dubletterne.

For at undgå dette, overvej at omskrive teksten på disse sider, så de ikke bliver forvekslet som "dubletter".

4. Der er "gengivelsesproblemer"

Hvis du har [gengivelsesproblemer], skal du sikre dig, at din kodning ikke er for stor. Din kodning skal være så [ren] som muligt, så crawleren kan [gengive] alt korrekt.

Hvis "crawleren" ikke kan gengive siden, vil den blive betragtet som tom.

Google Crawler "ofte stillede spørgsmål"

Hvor lang tid tager det for Google at "crawle" en hjemmeside?

Det tager normalt Google alt fra dage til uger at "crawle". Du kan overvåge "crawling" ved hjælp af [Index Status Report] eller [URL inspection tool]. Husk, Google bliver ikke underrettet, når et nyt website eller en ny side oprettes, det skal "crawle" og finde det.

Til orientering: Mere populære sider gennemsøges hurtigere. Helt nye sider vil normalt kræve uger at gennemsøge, mens velrenommerede sider som NY Times, Wall Street Journal og Wikipedia gennemsøges flere gange om dagen.

Hvad er Google Crawler-algoritmen?

"Google Crawler"-algoritmen er baseret på, hvor "crawler"-venlig din side er. Dette inkluderer "søgeord", "URL'er", "indhold" og "information", kodning og meget mere. Det er op til dig at give Google det bedste indhold og vejledning, så den kan finde din side og begynde at crawle.

Er alle sider tilgængelige for "crawling"?

Dette er et godt spørgsmål. Det korte svar er nej. Nogle sider kan ikke crawles og indekseres, fordi de er "passwordbeskyttede", blev specifikt udelukket fra indeksinstruktionerne, eller ikke har nogen links på deres sider.

Hvornår vil min hjemmeside [dukke] op i Google-søgning?

Dette vil altid variere afhængigt af, hvor lang tid det tager for din hjemmeside at blive "gennemgået" og indekseret. Dette kunne kun tage et par dage eller så længe som et par uger.

Hvilke andre "web crawlers" er der?

Ja! Der er masser af webcrawlere uden for Googles femten. Her er nogle få til reference:

- Der er BingBot brugt af søgemaskinen Bing.

- SlurpBot, brugt af Yahoo! Denne webcrawler er en blanding mellem Yahoo! og Bing, fordi Bing primært driver Yahoo!.

- ExaBot er den mest populære søgemaskine og crawler i Frankrig.

- AppleBot bruges af den store tech Apple til spotlight-søgning og Siri-forslag.

- Facebook, tro det eller ej, bruger links til at sende indhold til andre profiler og kan kun crawle, hvis der gives et link.

Optimér din side til Google-gennemsøgning

Nu hvor du forstår det grundlæggende i Google Crawling og hvordan det fungerer, brug det til din fordel! Få din hjemmeside indekseret korrekt og klatre til toppen af startsiden for søgeresultater. Det er gratis og helt til din rådighed.