Het laten ontdekken van je single page app (SPA) door zoekmachines is geen gemakkelijke opgave. SEO voor single page applicaties helpt je webapplicaties om meer organische weergaven te krijgen.

HTML-gebaseerde websites zijn gemakkelijker te [toegankelijk], [doorzoeken], en [indexeren] omdat ze een gestructureerde opmaak voor crawlers bieden.

Daarom kan het hebben van uw inhoud in HTML-pagina's leiden tot betere zoekresultaten, en ze zijn gemakkelijker te optimaliseren dan "single page apps".

SPA's vertrouwen sterk op JavaScript om inhoud dynamisch te herschrijven op basis van de acties van een bezoeker op de site (denk aan [uitklapbare tekst] of pop-upvensters).

Daarom maakt het het moeilijk voor Googlebots om de inhoud van de pagina te indexeren, omdat het geen client-side JavaScript-inhoud uitvoert.

In dit artikel zal ik de echte uitdagingen van het gebruik van SPAs bespreken en het volledige proces delen van het doen van SEO voor [single page apps] om betere zoekresultaten te behalen.

Belangrijkste [bevindingen]

- SEO voor "single page applications" is essentieel omdat door JavaScript aangedreven SPAs vaak belangrijke inhoud voor crawlers verbergen.

- Gebruik "server-side rendering" (SSR) of vooraf renderen om crawlers volledig gerenderde HTML-versies van je pagina's te geven.

- Dynamische titels, metabeschrijvingen en canonical tags zijn cruciaal voor single page application SEO om dubbele inhoud te voorkomen en relevantie over routes te behouden.

- Combineer interne links, schone URL's, XML-sitemaps en correcte HTTP-statuscodes om zoekmachines te helpen alle belangrijke routes binnen je SPA te ontdekken en indexeren.

Wat is SEO voor Single Page Applications (SPA)?

"Zoekmachineoptimalisatie" voor "single page apps" verwijst naar het proces van het toegankelijk en indexeerbaar maken van SPA's, gebouwd met JavaScript frameworks zoals React.js, Angular.js of Vue.js, door zoekmachines.

SEO voor [single page apps] omvat:

- "Server-side rendering" of "pre-rendering"

- "Title tags", "meta descriptions", en optimalisatie van gestructureerde gegevens

- URL- en canonical tag-optimalisatie

- Interne linkoptimalisatie

- Aanmaken en indienen van een sitemap

- "Link building"

Google, Bing, Baidu, DuckDuckGo en andere zoekmachines vinden het uitdagend om JavaScript-inhoud te crawlen en indexeren omdat SPAs inhoud dynamisch laden aan de clientzijde.

Daarom bestaat SPA SEO uit strategieën en best practices om de vindbaarheid en webaanwezigheid van single page apps in zoekmachines te verbeteren.

Voorbeelden van "Single Page Applications"

Hier zijn de beste voorbeelden van SPA's:

Gmail

Gmail is een schoolvoorbeeld van een SPA. Wanneer je inlogt, wordt de gehele gebruikersinterface, inclusief je inbox, mappen en chat, één keer geladen.

Vanaf dat punt [hoeft] het bladeren door e-mails, openen van threads of opstellen van nieuwe berichten [geen] volledige paginavernieuwing.

JavaScript beheert de "routering" en inhoudsveranderingen achter de schermen, waardoor de ervaring snel en naadloos is.

Google gebruikt asynchrone verzoeken om alleen de benodigde gegevens op te halen, waardoor de latentie wordt verminderd en de gebruikerservaring wordt verbeterd.

Google Maps

Google Maps biedt rijke interactieve functies zoals "pannen", "zoomen" en het [zoeken] van locaties, allemaal binnen dezelfde pagina.

Het [wordt] niet opnieuw geladen wanneer je [nieuwe richtingen aanvraagt] of [overschakelt] tussen satelliet- en kaartweergaven.

In plaats daarvan worden gegevens opgehaald via AJAX, en de kaarttegels of UI-componenten worden dynamisch bijgewerkt. Dit maakt dat Google Maps uiterst [responsief] en bruikbaar aanvoelt, zelfs bij [langzamere] verbindingen.

Hoewel niet 100% SPA, gebruiken grote delen van Facebook de SPA-architectuur.

Wanneer gebruikers door hun nieuwsfeed scrollen, berichten openen, reageren of een opmerking plaatsen, gebeuren alle updates zonder dat de pagina wordt herladen.

Zelfs wanneer er gewisseld wordt tussen pagina's zoals Berichten, Meldingen en Marketplace, maakt de site gebruik van client-side routing met JavaScript-frameworks (zoals React) om inhoud dynamisch te renderen, wat serveroproepen vermindert en de laadsnelheid verbetert.

Netflix

De webinterface van Netflix is een ander hoogwaardig SPA. Terwijl je door film- of tv-programmasuggesties bladert, worden trailers automatisch afgespeeld en verschijnen inhoudsdetails onmiddellijk zonder opnieuw te laden.

Door op een titel te klikken, wordt een modale overlay of nieuw [weergave] geopend terwijl de kerninterface intact blijft.

De "routing", "aanbevelingen" en "gebruikersprofiel" [wijzigingen] worden beheerd door JavaScript, wat een consistente ervaring met lage wachttijden levert.

Is een "Single Page Application" goed voor SEO?

Ja, een "single page application" is goed voor SEO als je de juiste optimalisatietips voor SPAs kent.

Zoekmachines zoals Google kunnen JavaScript weergeven, maar ze kunnen het crawlen vertragen of "inhoud" overslaan die "gebruikersinteractie" vereist.

Om dat te voorkomen, kunt u "server-side rendering", "static site generation", schone URL-routing en dynamische metadata-updates gebruiken.

Tools zoals Next.js, Nuxt.js, React Helmet, en Vue Meta helpen om al dat werk te [verrichten].

Met de juiste [opstelling], kan een SPA net zo goed [ranken] als elke traditionele site. [Echter], zonder de juiste SEO-aanpassingen, kunnen zoekmachines veel van wat je hebt gebouwd missen.

Gerelateerde [lezen]: Hoe [SEO uit te voeren voor dynamische inhoud]

Hoe [SEO] te doen voor [Single Page Applications]

Hier zijn de beste SEO-oplossingen voor [enkele pagina] web-apps:

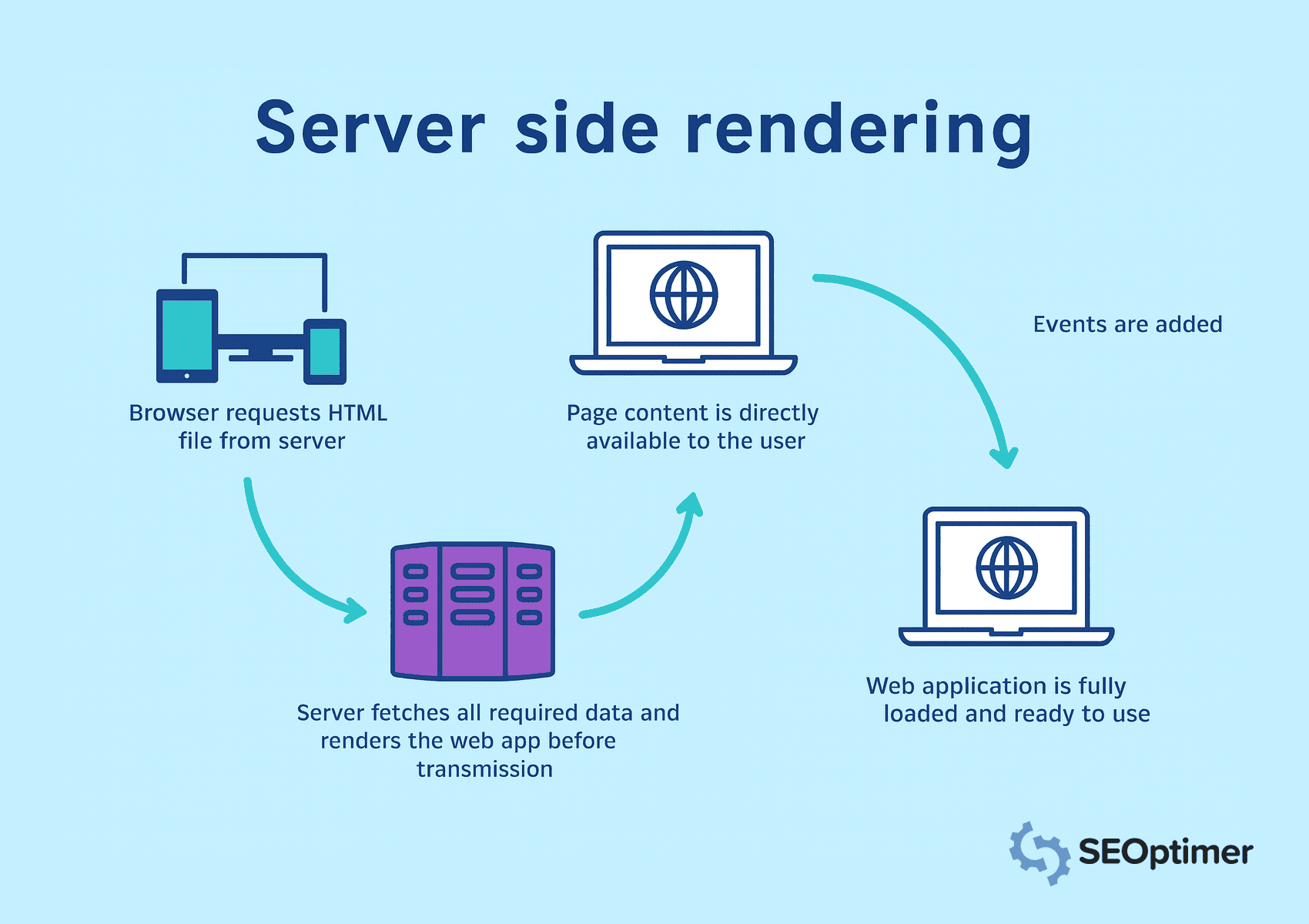

Gebruik "Server-Side Rendering" (SSR)

"Single page applications" vertrouwen op JavaScript om inhoud dynamisch te laden.

Echter, zoekmachines verwachten volledige server-HTML in de HTTP-reactie om inhoud te "toegangen", "crawlen" en "indexeren".

Daarom moet je "server-side rendering" implementeren om pagina's op de server te renderen voordat je ze naar de browser stuurt.

In server-side rendering, vraagt de browser om HTML-bestanden, en haalt de server alle gegevens op. Het [zorgt] ervoor dat alle [inhoud] onmiddellijk zichtbaar en doorzoekbaar is.

Cache "frequent" bezochte pagina's om laadtijden te verminderen en [content] sneller te leveren. Vermijd client-side rendering voor "belangrijke" elementen, aangezien zoekmachines mogelijk moeite hebben met het verwerken van JavaScript-rijke weergaven.

Implementeer Vooraf Rendereen voor Statische Routes

Je moet routes vooraf renderen die dezelfde inhoud aan elke bezoeker tonen. Het stelt je in staat om HTML te genereren tijdens de buildtijd en verwijdert de noodzaak voor rendering tijdens runtime.

Als gevolg hiervan kunnen zoekmachines onmiddellijk toegang krijgen tot de pagina.

Tools voor statische generatie van frameworks zoals Next.js of Nuxt.js kunnen je helpen bij het maken van statische bestanden voor routes zoals [landingspagina's], [blogs], of [productoverzichten].

Je moet deze vooraf gerenderde pagina's serveren via een Content Delivery Network of webserver om de laadsnelheid en zichtbaarheid te verbeteren. Vermijd het toepassen van pre-rendering op weergaven met "real-time" of gebruikersspecifieke data.

Voeg Schone en Kruipbare HyperText Markup Language Uitvoer Toe

Je zou een goed gestructureerde HyperText Markup Language output moeten genereren die zoekmachines gemakkelijk kunnen interpreteren.

Schone opmaak helpt bots de paginalay-out, hiërarchie en belangrijke elementen te begrijpen zonder te vertrouwen op de uitvoering van JavaScript.

Vermijd het dynamisch injecteren van content na het laden van de pagina. Zorg er in plaats daarvan voor dat belangrijke tekst, koppen, en links direct in de broncode verschijnen.

Wanneer je werkt aan SEO voor een [enkele pagina-app], is het belangrijkste om te onthouden dat Google je pagina niet altijd ziet zoals mensen dat doen. Omdat ze [inhoud] laden met JavaScript, krijgt de crawler soms gewoon een lege pagina. Dus zorg ervoor dat wat je wilt dat Google leest, daadwerkelijk in de html verschijnt.

- Ciara Edmondson, SEO & Content Manager bij Max Web Solutions

Gebruik semantische tags zoals <header>, <main>, <article>, en <footer> om [duidelijke] structuur te bieden.

Je moet ook minimaliseren inline stijlenen scriptrommel die zinvolle inhoud zou kunnen verbergen.

Houd het document leesbaar en lichtgewicht voor snellere [crawling] en betere [indexing].

Gebruik "server-side rendering" of "pre-rendering" om statische HTML voor elke route te produceren. Het garandeert dat crawlers toegang hebben tot de volledige [pagina]inhoud in het eerste verzoek.

Statische [momentopnamen] blootstellen voor [crawlers]

Je moet statische snapshots blootstellen om ervoor te zorgen dat crawlers volledige inhoud kunnen [toegang hebben], vooral wanneer client-side rendering de pagina-uitvoer vertraagt.

Een statische momentopname is een volledig weergegeven versie van de pagina die van tevoren wordt gegenereerd en specifiek aan bots wordt geleverd.

Deze tactiek is nuttig wanneer "server-side rendering" of "pre-rendering" niet haalbaar is in de hele [toepassing].

Momentopnamen bieden een alternatief pad voor crawlers om gestructureerde HyperText Markup Language te openen zonder JavaScript uit te voeren.

Je moet de server configureren om gebruikersagenten zoals Googlebot te detecteren en vooraf gebouwde snapshots voor die verzoeken te serveren.

Hulpmiddelen zoals Rendertron, Prerender.io, of aangepaste headless NodeJS renderers kunnen helpen om snapshots betrouwbaar te genereren en leveren.

Zorg ervoor dat elke momentopname de volledige inhoud en structuur van de pagina weerspiegelt, inclusief titels, metadata, links en schema-opmaak.

Safira van Somar Digital, een agentschap gevestigd in Nieuw-Zeeland, beveelt aan dat alle SPAs schema markup voor hun SEO zouden moeten gebruiken.

Ik raad aan om [gestructureerde gegevensschema]-markup te gebruiken voor SPAs. Integreer relevante schema-markeringen zoals [organisatie], [webpagina], [kruimelpadlijst], [FAQ], enz.

Ik heb gemerkt dat soms "schema markup" mogelijk niet wordt weergegeven in de broncode of zelfs niet in de Google Rich Results Test, maar als je het schema test met behulp van de schema markup validator, zie je toegevoegde schema markups in de resultaten. Dit gebeurt omdat SPAs die het [Schema] injecteren (via JavaScript) dit niet beschikbaar hebben bij de eerste laadbeurt. Maar Google is in staat om de JavaScript te lezen omdat het "headless" is.

- Safira Mumtaz, SEO/SEM Specialist bij Somar Digital

Je moet ook de indexdekking [monitoren] om te bevestigen dat crawlers snapshots verwerken zoals bedoeld.

Het serveren van statische snapshots verbetert de zichtbaarheid voor pagina's met complexe renderlogica, wat helpt om consistente indexering en SEO-waarde te behouden.

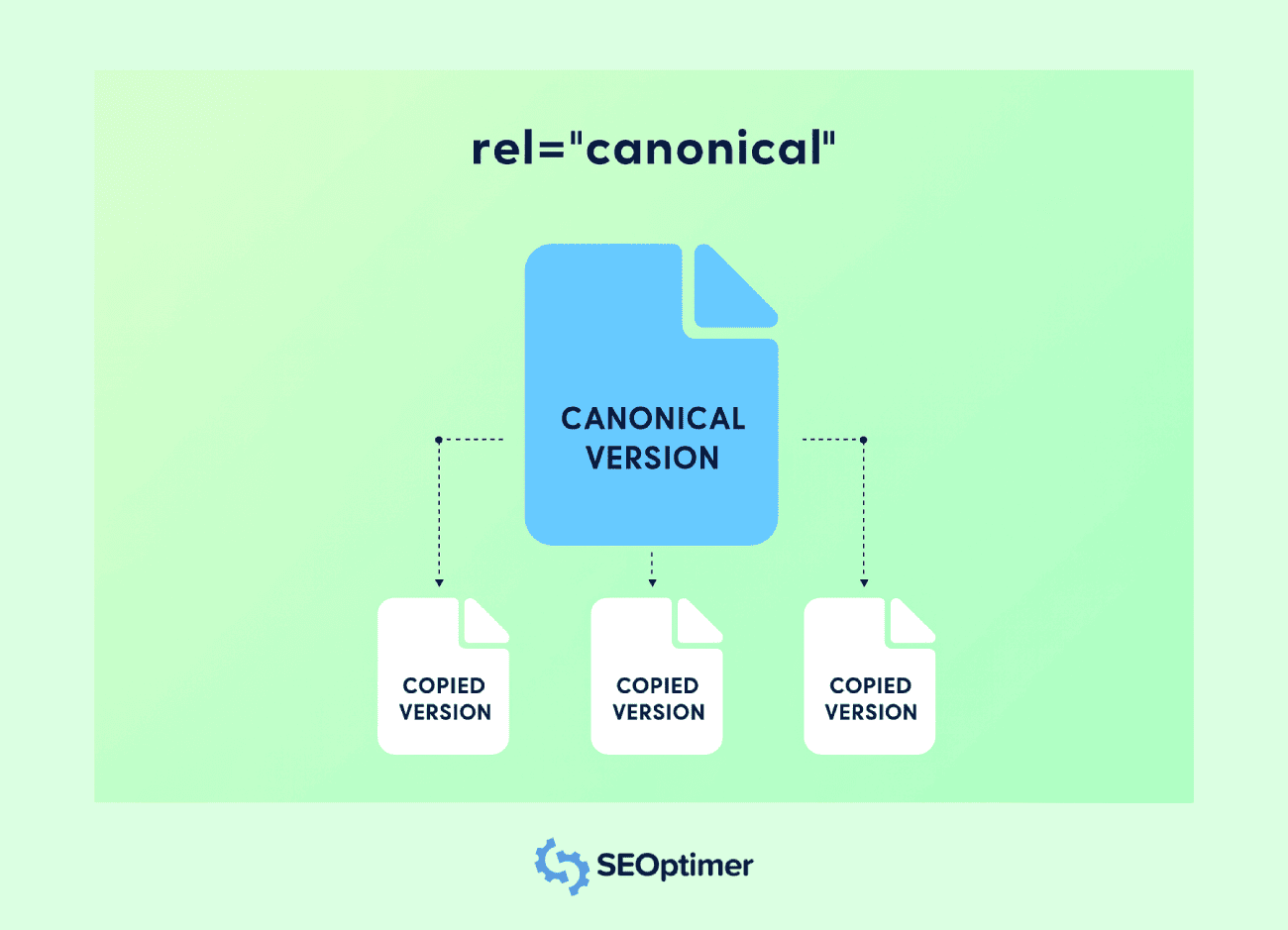

Stel Canonical Tags in voor elke [weergave]

Je moet een canonieke tag instellen voor elke route in een [single page] applicatie om problemen met dubbele inhoud te vermijden.

Meestal zullen SPAs meerdere toegankelijke URL's genereren voor dezelfde [inhoud].

Bijvoorbeeld, dezelfde inhoud kan aanwezig zijn in URL's met verschillende querystrings, filters of trackingparameters. Canonical-tags helpen zoekmachines de [voorkeursversie] te begrijpen.

Elke route moet een <link rel="canonical"> tag bevatten die verwijst naar de originele URL voor die weergave. Het voorkomt verwatering van "linkwaarde" tussen verschillende URL's met dezelfde inhoud.

Je moet canonieke tags dynamisch injecteren wanneer de route verandert, vooral als de applicatie metadata aan de clientzijde bijwerkt.

Gebruik routing hooks of middlewarefuncties om het juiste [label] toe te wijzen bij elke [paginaovergang].

Vermijd het aanwijzen van alle routes naar de startpagina of het gebruik van een statische canonieke waarde. Elk uniek [view] moet zijn eigen logische URL weerspiegelen om relevantie en indexnauwkeurigheid te behouden.

Het implementeren van juiste canonisatie ondersteunt duidelijkere indexering, verbetert de pagina-autoriteit en voorkomt ongewenste duplicatie in zoekresultaten.

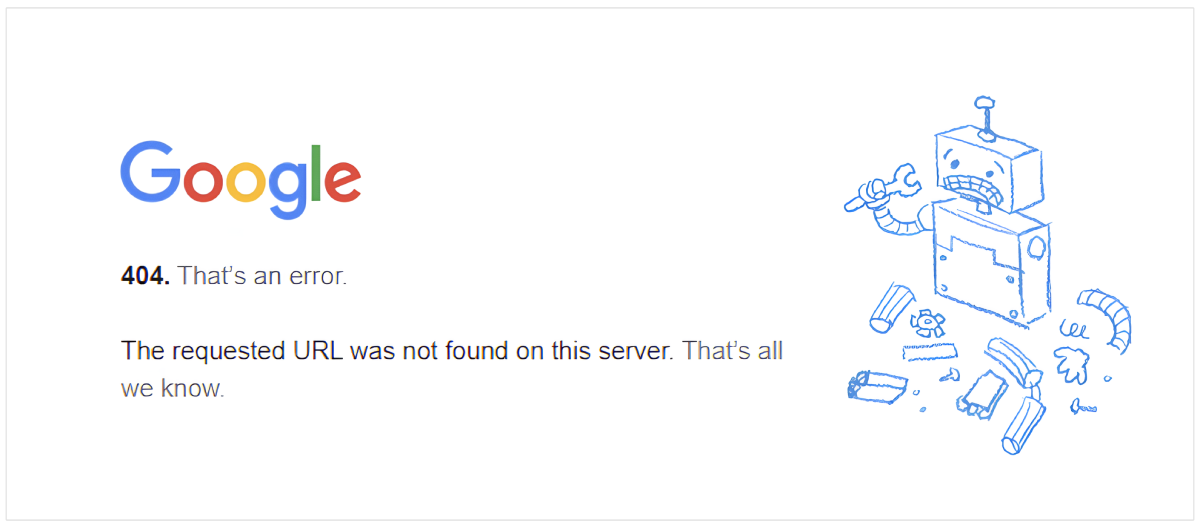

Behandel 404 en Andere Statuscodes Correct

Je moet nauwkeurige statuscodes configureren voor alle weergaven in een [single page application] om zoekmachines te helpen de structuur van je site correct te interpreteren.

Veel SPAs serveren een standaard HTML-shell voor elk verzoek, wat een 200 OK kan retourneren, zelfs voor niet-bestaande routes.

Een correcte 404 Niet Gevonden reactie moet worden gegeven voor ongeldige URL's.

Gebruik serverlogica of middleware in NodeJS om [niet-overeenkomende] routes te detecteren en de juiste statuscode samen met een [aangepaste] foutpagina te verzenden.

Je moet ook andere reacties afhandelen zoals 301 of 302 voor "omleiding" en 500 voor "serverfouten".

Deze statuscodes informeren zoekmachines over hoe elke aanvraag behandeld moet worden en behouden de integriteit van je crawl- en indexdekking.

Vermijd het uitsluitend vertrouwen op foutafhandeling aan de clientzijde. Crawlers kunnen mogelijk geen JavaScript uitvoeren, dus onjuiste statusreacties kunnen de "search engine optimization"-signalen beschadigen en misleidend zijn voor indexering.

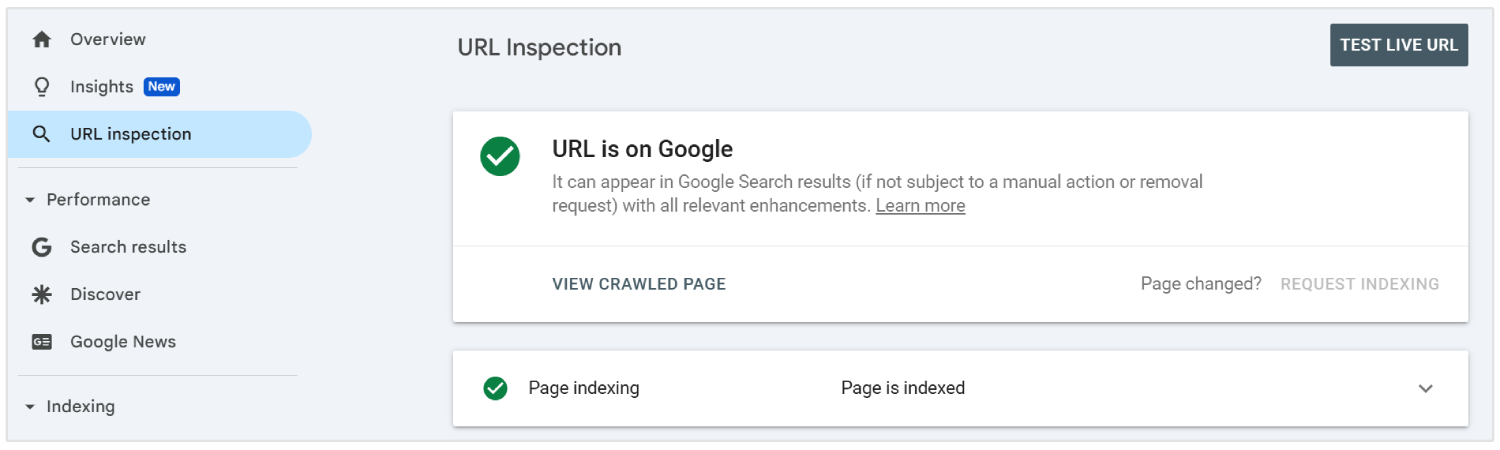

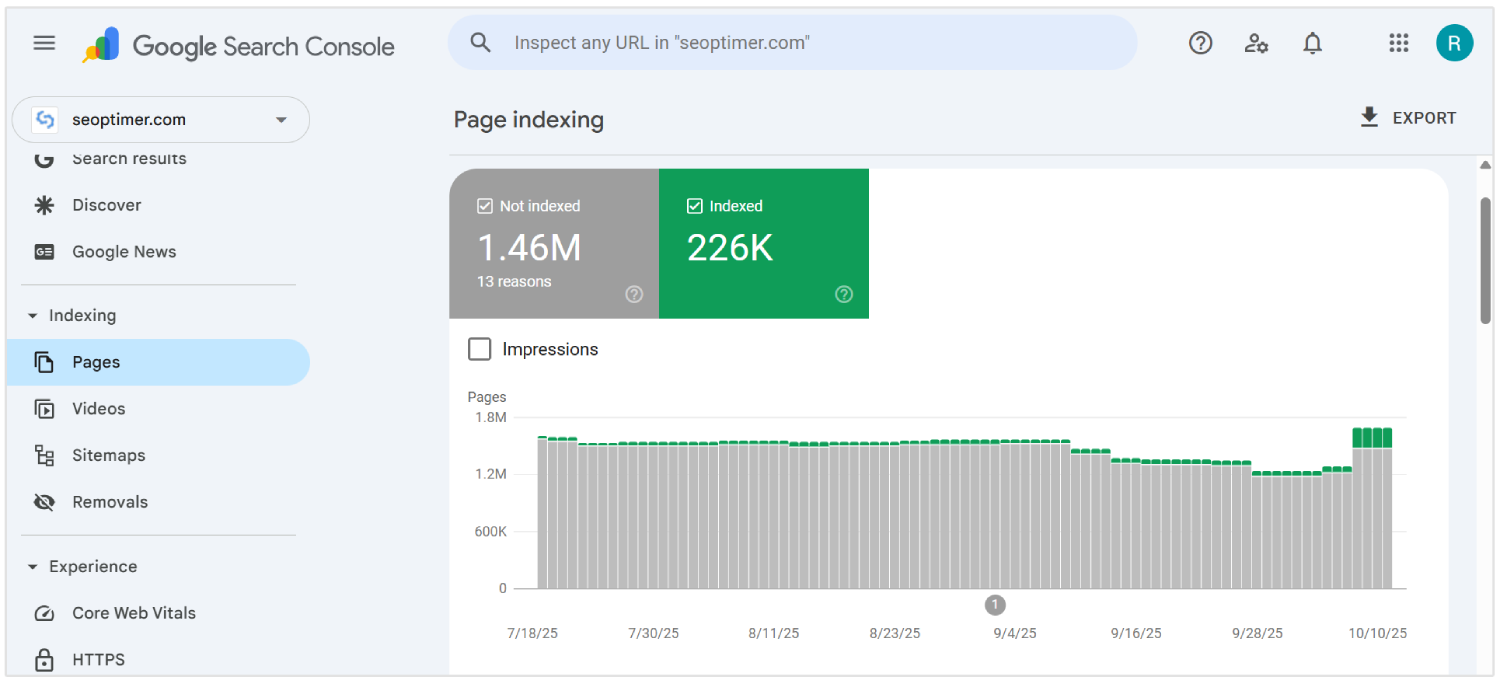

Dynamische URL's indienen bij Google Search Console

U moet alle belangrijke dynamische URL's van een single page application indienen bij Google Search Console met behulp van de URL-inspectietool. Het helpt zoekmachinebots om inhoud te ontdekken en te indexeren die mogelijk niet verschijnt in een traditionele crawl.

Aangezien SPAs inhoud laden via client-side routing, kunnen sommige interne pagina's mogelijk niet worden gevonden door crawlers zonder directe koppeling.

Om zichtbaarheid te garanderen, vermeld deze URL's in een XML-sitemap en dien deze in via de console-interface.

Je moet de sitemap bijwerken wanneer nieuwe routes worden toegevoegd of gewijzigd. Elke [invoer] moet de uiteindelijke, schone URL [weergeven] die gebruikers en crawlers zien, met uitzondering van hekken of onnodige parameters.

Het indienen van dynamische URL's geeft Google een duidelijk overzicht van de structuur van uw applicatie en vergroot de kans op nauwkeurig crawlen en snellere indexering.

Schakel "Lazy Loading" in met "Fallbacks"

Je zou moeten inschakelen lui ladenom de prestaties in SPAs te verbeteren door het laden van niet-essentiële elementen zoals afbeeldingen, video's of [onder-de-vouw] secties uit te stellen.

Het helpt om de initiële laadtijd te verminderen en verbetert de gebruikerservaring op zowel desktop- als mobiele weergaven.

Zoekmachines kunnen de inhoud die via JavaScript wordt geladen mogelijk niet activeren, wat kan leiden tot gemiste indexering.

U moet [back-ups] bieden zoals "placeholder"-inhoud of <noscript>-tags om ervoor te zorgen dat alle [belangrijke] elementen zichtbaar blijven voor crawlers.

Gebruik native browserfuncties zoals het loading="lazy"-attribuut of beheer op scroll gebaseerde [loading] via JavaScript. Je moet altijd de zichtbaarheid bevestigen met behulp van tools zoals Google Search Console.

Vermijd het uitstellen van belangrijke inhoud of links die bijdragen aan zoekzichtbaarheid. Correct gebruik van "lazy loading" met betrouwbare terugvalopties ondersteunt snellere laadsnelheid en volledige dekking van de inhoud.

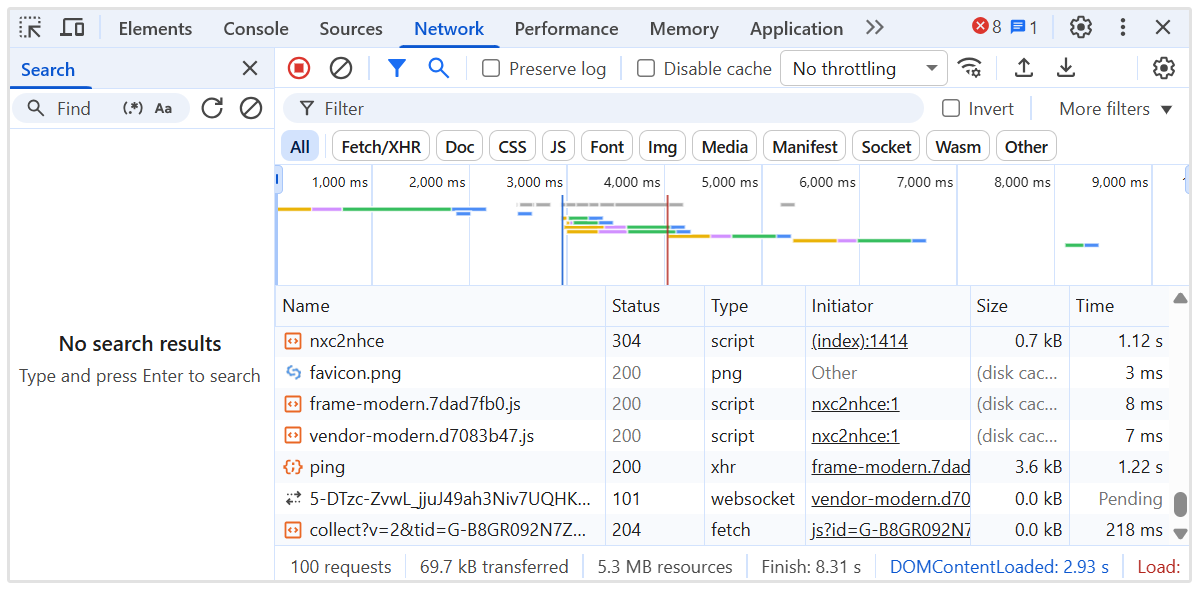

Uitstellen van niet-kritische JavaScript

Je moet niet-kritische JavaScript uitstellen om de initiële paginaweergave te versnellen en de blokkering van belangrijke inhoud in "single page applications" te verminderen.

Scripts die niet essentieel zijn voor [boven de vouw] inhoud kunnen zowel [gebruikersinteractie] als [crawlerzichtbaarheid] vertragen.

Gebruik de attributen defer of async in script-tags om onnodige uitvoering tijdens het laden van de eerste pagina te voorkomen.

Plaats "niet-essentiële" scripts aan het einde van het document of laad ze nadat de "kerninhoud" is gerenderd.

Je zou moeten identificeren welke scripts de lay-out, metadata of routeringslogica beïnvloeden, en deze scheiden van [analytics], chatwidgets of animaties.

Tools zoals Lighthouse en Chrome DevTools kunnen helpen bij het controleren van [scriptgedrag] en laadvolgorde.

Implementeer interne koppeling tussen SPA-routes

U moet een duidelijke interne linkstructuur creëren tussen alle routes in een [enkele] pagina [applicatie] om crawlers door de site te leiden.

In tegenstelling tot traditionele websites vertrouwen SPAs op navigatie aan de clientzijde, wat kan voorkomen dat zoekmachines alle interne pagina's ontdekken als links niet correct worden toegevoegd.

Gebruik anker-tags met juiste href-attributen die het werkelijke pad weergeven, niet alleen JavaScript-functies of knoppen. Vermijd het gebruik van elementen zoals onClick-handlers zonder betekenisvolle URL's, aangezien deze meestal genegeerd worden door crawlers.

U moet ervoor zorgen dat elke belangrijke pagina is gelinkt vanaf andere delen van de applicatie, vooral vanaf de homepage en [high-authority] pagina's. Het helpt om relevantie- en autoriteitssignalen door te geven voor efficiënte crawling.

Behoud een logische hiërarchie met navigatiemenu's, broodkruimels en contextuele links tussen gerelateerde weergaven. Gebruik beschrijvende ankertekst om paginaproblemen te versterken.

Interne [linking] verbetert de [crawl depth], verdeelt [authority], en versterkt de algehele [search engine optimization performance] over de volledige toepassing.

Gebruik een [sitemap] die alle belangrijke routes weerspiegelt

Je moet een sitemap genereren en indienen die elke belangrijke route in de single page applicatie bevat.

Aangezien SPAs client-side routing gebruiken, zijn veel interne "weergaven" mogelijk niet vindbaar via traditionele crawling.

Maak een XML-sitemap die alle statische en dynamische routes bevat die bedoeld zijn voor indexering. Neem alleen schone, canonieke URL's op zonder onnodige parameters, fragmenten of sessiegegevens.

U [moet] de sitemap bijwerken wanneer nieuwe routes worden toegevoegd, verwijderd of gewijzigd. Automatiseringstools kunnen de sitemap tijdens elke implementatie opnieuw genereren om deze nauwkeurig te houden.

Dien de "sitemap" in bij Google Search Console om zoekmachines te helpen belangrijke inhoud te vinden en prioriteren. Dit ondersteunt volledige indexdekking en versterkt zichtbaarheid op route-niveau.

![Een sitemap [indienen]](/storage/images/2025/10/7384-Submit a sitemap.png)

Een goed onderhouden sitemap verbetert de crawl-efficiëntie en zorgt ervoor dat belangrijke [weergaven] de aandacht krijgen die ze nodig hebben.

Controleer "crawlgedrag" met "serverlogs"

Je zou serverlogs moeten analyseren om te begrijpen hoe zoekmachines omgaan met je Single Page Application.

Logboeken onthullen welke routes worden gecrawld, hoe vaak ze worden geopend, en of bots fouten of vertragingen tegenkomen.

Bekijk HTTP-statuscodes, gebruikersagenten en tijdstempels om "indexeringsgaten" of "crawlefficiënties" te detecteren.

Zoek naar tekenen van gemiste inhoud, herhaalde hits op irrelevante pagina's, of mislukte reacties die de zichtbaarheid kunnen schaden.

Je moet bijhouden hoe Googlebot door dynamische routes navigeert en verifiëren dat belangrijke [weergaven] crawl-aandacht krijgen. Combineer loggegevens met inzichten van tools zoals Google Search Console om de dekking van de indexering te controleren.

Gebruik "server log" analysetools of exporteer gegevens uit uw NodeJS "serveromgeving" voor diepere zichtbaarheid.

Het "monitoren" van "real-time bot activiteit" helpt om [crawl waste] te identificeren, [discoverability issues] op te lossen en de algehele [SPA SEO performance] te optimaliseren.

Los [rendering]-problemen op met "dynamische inhoud"

Je moet problemen met renderen oplossen in "single page applications" om ervoor te zorgen dat dynamische inhoud volledig zichtbaar is voor zoekmachines.

Inhoud die afhankelijk is van de uitvoering van JavaScript kan mogelijk niet verschijnen tijdens het crawlen als het te laat laadt of gebruikersinteractie vereist.

Controleer elke route om te bevestigen dat belangrijke tekst, links en koppen beschikbaar zijn in de gerenderde output. Gebruik tools zoals Google's URL Inspectietool of Lighthouse om inhoud te detecteren die ontbreekt bij de initiële weergave.

Je moet technieken toepassen zoals server-side rendering of pre-rendering om volledig gebouwde pagina's te leveren waar nodig.

Voor "client-side rendering", zorg ervoor dat gegevens snel laden en niet afhankelijk zijn van vertraagde triggers.

Vermijd het injecteren van cruciale informatie nadat de crawler de pagina al heeft verwerkt. Vertragingen in het renderen kunnen leiden tot gedeeltelijke indexering of uitsluiting van zoekresultaten.

Het oplossen van [rendering]problemen zorgt voor volledige zichtbaarheid van belangrijke inhoud, ondersteunt betere [indexering], en versterkt de algehele resultaten van zoekmachineoptimalisatie voor SPAs.

JavaScript-uitvoering afstemmen op mogelijkheden van de crawler

U moet de uitvoering van JavaScript structureren om aan te sluiten bij de verwerkingslimieten van moderne crawlers, met name de renderwachtrij en hulpbronnenbeperkingen van Googlebot.

Crawlers werken met een tijdsbudget voor elke URL. Daarom kunnen overmatige afhankelijkheidsketens, asynchrone gegevensophaling, of render-blokkerende logica resulteren in onvolledige indexering van [belangrijke] pagina's.

Geef prioriteit aan het weergeven van "kritieke pad"-inhoud tijdens de eerste weergavefase. Vermijd geneste hydratatielagen, vertraagde DOM-mutaties of overmatig gebruik van alleen-clientcomponenten.

Vervang runtime contentinjectie door door de server vooraf opgehaalde gegevens of skeletlay-outs waar volledige server-HTML niet haalbaar is.

Je zou de uitvoeringstijd moeten controleren met behulp van tools zoals Chrome DevTools Performance panel en crawler-omstandigheden simuleren met Puppeteer of headless NodeJS-renderers.

Volg "Time to Interactive" (TTI), "Largest Contentful Paint" (LCP), en "Total Blocking Time" (TBT) onder [no-cache] omstandigheden.

Zorg ervoor dat route-specifieke metadata, canonieke tags en schema's synchroon worden geladen. Verminder het gebruik van zware bibliotheken of runtime-routeringskaders die de betekenisvolle renderoutput vertragen.

Controleer "SEO-prestaties" met gespecialiseerde tools

U [moet] uw zoekmachineoptimalisatieprestaties regelmatig [controleren] om zichtbaarheidsproblemen in "single page applications" te detecteren.

Standaard browsergebaseerde controles missen problemen die uniek zijn voor JavaScript-rijke omgevingen.

Het gebruik van geavanceerde tools biedt diepgaand inzicht in hoe pagina's worden gerenderd, geïndexeerd en beoordeeld door zoekmachines.

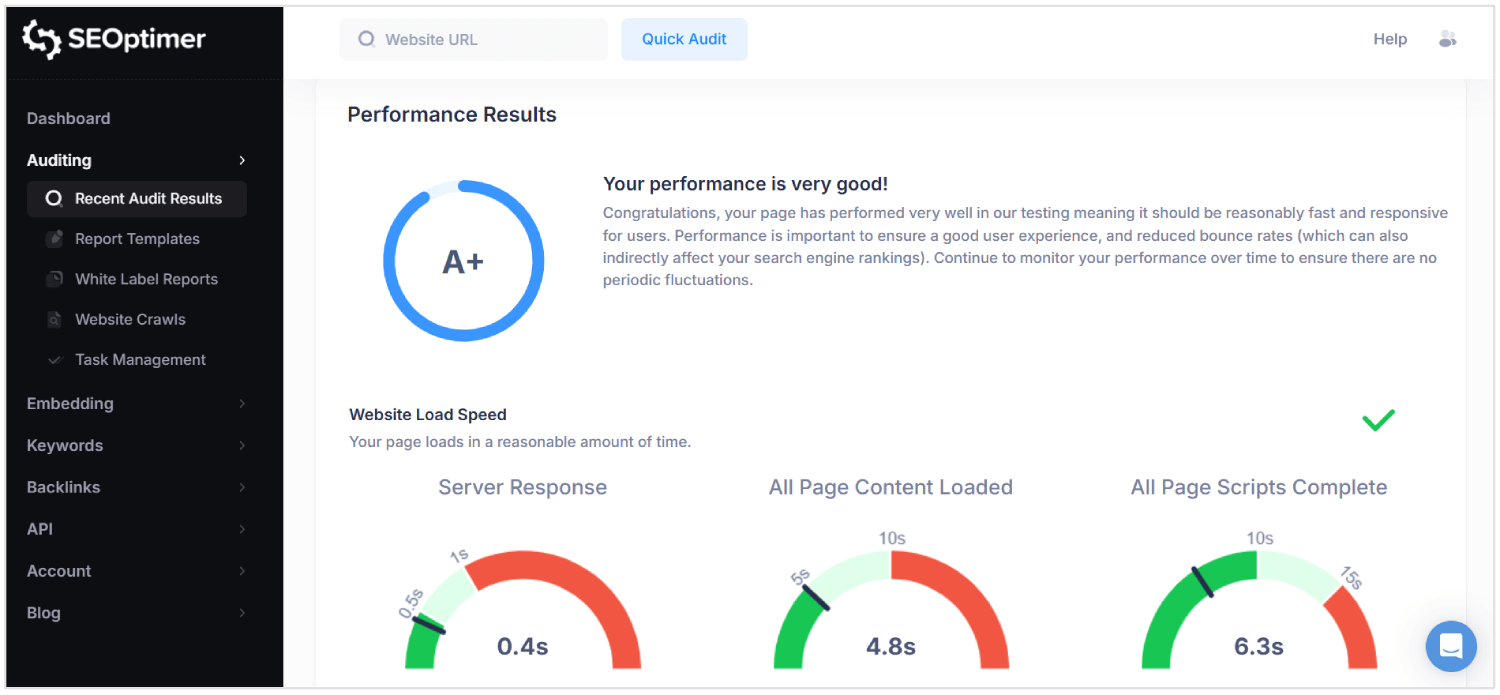

SEOptimer is een dergelijke tool die uitgebreide audits uitvoert over technische, on-page en prestatie-lagen.

Het scant elke pagina op [kwaliteit] van metadata, [mobiele responsiviteit], interne [linkstructuur], en de [verhouding tussen inhoud en code].

Voor SPAs helpt SEOptimer bij het identificeren van ontbrekende HyperText Markup Language-elementen, verkeerd geconfigureerde canonieke tags en zwakke headerstructuren die de doorzoekbaarheid beïnvloeden.

Je moet SEOptimer-audits uitvoeren na het implementeren van grote updates of het lanceren van nieuwe routes. De tool markeert "rendering" vertragingen, [gebroken] links, en JavaScript-afhankelijkheden die voorkomen dat [inhoud] correct laadt.

Combineer SEOptimer met tools zoals Google Search Console en log-analyzers om resultaten te valideren onder "real-world" [crawl] omstandigheden.

Regelmatige audits zorgen ervoor dat de routeringslogica, [content]levering en [rendering]gedragingen allemaal de voortdurende SEO-prestaties ondersteunen.

Waarom SEO een Uitdaging is voor SPA's

SEO is "moeilijk" voor "single page apps" omdat metadata, route-specifieke inhoud, en juiste statuscodes mogelijk worden gemist of verkeerd begrepen door crawlers.

Hier zijn de belangrijkste SEO-uitdagingen voor SPAs:

1. Rendering aan de clientzijde

Zoekmachines verwachten dat er betekenisvolle inhoud aanwezig is in de initiële HTML-reactie. SPAs vertrouwen op JavaScript om inhoud weer te geven nadat de pagina is geladen, wat de zichtbaarheid vertraagt.

Als een crawler de pagina opent voordat het renderen is voltooid, kunnen belangrijke elementen zoals "tekst" en "links" mogelijk niet worden verwerkt. Dit creëert een risico dat zoekmachines onvolledige of lege pagina's indexeren.

Als gevolg daarvan bereikt inhoud die gebruikers kunnen zien nooit de zoekmachineresultaten.

2. Beperkingen van [crawlen]

SPAs [stellen] niet alle [pagina's] bloot via traditionele statische [links], waardoor [crawlen] complexer wordt.

Veel pagina's zijn alleen toegankelijk via interne "client-side" navigatie, die zoekbots mogelijk niet volgen.

Zelfs moderne crawlers zoals Googlebot renderen JavaScript met vertragingen en beperkte verwerkingstijd. Pagina's die meerdere rendercycli of geneste [data] ophalen vereisen, kunnen het crawlbudget overschrijden.

Belangrijke "weergaven" kunnen volledig worden gemist, waardoor de zichtbaarheid van de site in "zoekresultaten" wordt verzwakt.

3. Dynamische Metadata-afhandeling

Elke weergave in een SPA mist unieke metadata tenzij deze handmatig wordt geconfigureerd.

Zonder dynamische updates van titels, beschrijvingen en canonieke tags lijken alle URL's identiek voor zoekmachines.

Dit leidt tot indexeringsfouten, verminderde relevantie en lagere doorklikpercentages.

Metadata gekoppeld aan URL-wijzigingen moet in real time worden geïnjecteerd met behulp van bibliotheken of aangepaste logica. Het niet beheren hiervan blokkeert de toepassing om correct te rangschikken bij verschillende "zoekopdrachten".

4. Niet-standaard URL-structuren

SPAs kunnen URL's gebruiken die afhankelijk zijn van hash-fragmenten of browsergeschiedenismanipulatie. Deze formaten kunnen verwarring veroorzaken voor zoekmachines die de voorkeur geven aan schone, "canonieke" paden.

Als een route geen [juiste] "structuur" heeft, kan deze mogelijk niet worden geïndexeerd of kan deze als een duplicaat worden behandeld.

Inconsistente URL's breken ook het "deep linking", wat cruciaal is voor de [navigatie] van gebruikers en de [crawldiepte].

SEO-prestaties lijden wanneer bots geen echte, [onderscheidende] URLs kunnen interpreteren of openen.

5. Onjuiste HTTP-statuscodes

In tegenstelling tot traditionele sites, reageren SPAs met 200 OK zelfs voor niet-bestaande "routes".

Dit misleidt zoekmachines om foutpagina's of irrelevante [inhoud] te indexeren.

Zonder correcte codes zoals 404 Niet Gevonden of 301 Omleiding, kunnen crawlers verouderde pagina's niet verwijderen of nieuwe paden volgen.

Bots hebben nauwkeurige status signalen nodig om de [site structuur] en [inhoudsveranderingen] te interpreteren.

SPAs die deze reacties verkeerd afhandelen, verliezen de controle over hoe hun inhoud in zoekresultaten verschijnt.

6. Geen [pagina] herlaadacties tijdens [navigatie]

In SPAs, "route" veranderingen vinden plaats binnen de browser zonder dat de pagina opnieuw wordt geladen. Dit voorkomt dat zoekmachines navigatiegebeurtenissen herkennen als nieuwe pagina's.

Bots kunnen aannemen dat de gebruiker nog steeds op dezelfde pagina is, wat de indexering van nieuwe [weergaven] beperkt.

In tegenstelling tot sites met meerdere pagina's, moeten SPAs deze overgangen simuleren zodat SEO-tools ze kunnen detecteren. Zonder dit wordt route-specifieke inhoud over het hoofd gezien of verkeerd geclassificeerd.

7. Vertraagde Weergave van Inhoud

SPAs vertragen [zichtbare] [inhoud] door meerdere JavaScript-afhankelijkheden en asynchroon laden.

Vanwege dit kunnen zoekmachine-crawlers de pagina verwerken voordat essentiële [gegevens] verschijnen.

Lange rendertijden kunnen resulteren in gedeeltelijke indexering, ontbrekende "headings", en onvolledige [pagina]samenvattingen.

Als betekenisvolle inhoud niet gereed is tijdens de crawl, gaan zoekmachines ervan uit dat de pagina geen waarde heeft of kunnen ze de pagina beschouwen als "dunne inhoud."

Dit vermindert uiteindelijk "rankings", "zichtbaarheid" en "verkeer".

Conclusie

Het goed krijgen van SEO voor "single page applications" is niet eenvoudig.

Zoekmachines moeten meteen echte inhoud zien en niet wachten tot scripts deze achteraf laden. Daarom moet je correcte HTML versturen, elke route behandelen als een echte pagina, en titels en beschrijvingen bijwerken terwijl de gebruiker door de app navigeert.

Je moet ook statuscodes beheren, interne links bouwen, gestructureerde gegevens toevoegen en ervoor zorgen dat zoekmachines elk deel van de site kunnen crawlen. Wanneer alles op zijn plaats is, wordt je single page application gemakkelijker te indexeren en gemakkelijker om te "rangschikken".